Lineare Algebra 2

Erstellt von Markus Windisch nach der Vorlesung von Clemens Heuberger im Sommersemester 2003

Institut für Optimierung und Diskrete Mathematik (Math B) Technische Universität Graz

Diese Auflage entspricht jenen Teilen der Vorlesung aus dem Sommersemester 2009, die ab Sommersemester 2010 noch Bestandteil der Vorlesung sind. Die ab Sommersemester 2010 neu

hinzugekommenen Stoffgebiete sind nicht enthalten.

Stand 488: 12. Jänner 2010 16:25:53

Inhaltsverzeichnis

0 Motivation 4

0.1 Vektor- und Matrizennormen . . . 4

0.2 Skalarprodukte und Orthogonalität . . . 4

0.3 Eigenwerte . . . 5

0.3.1 Asymptotik von Matrizenprodukten . . . 5

0.3.2 Positiv Definite Matrizen . . . 5

0.4 Singulärwertzerlegung . . . 5

I Matrizennormen 6

1 Vektor- und Matrizennormen 7 1.1 Vektornorm . . . 71.2 Operator- bzw. Matrixnormen . . . 8

2 Sensitivität linearer Gleichungssysteme 11 2.1 Konditionszahl, Sensitivität linearer Gleichungssysteme bei Störung der rechten Seite 11 2.2 Sensitivität eines Gleichungssystems bei beidseitiger Störung . . . 12

II Innere Produkte 14

3 Innere Produkte und Orthogonalität 15 3.1 Unitäre Räume und Euklidsche Räume . . . 153.2 Durch innere Produkte induzierte Normen . . . 16

3.3 Skalarprodukt und Winkel . . . 17

3.4 Orthogonalität . . . 17

3.5 Darstellung von Inneren Produkten durch Matrizen . . . 19

4 Innere Produkte und Lineare Abbildungen 20 4.1 Adjungierte Abbildungen . . . 20

4.2 Unitäre Abbildungen . . . 22

4.3 Projektionen . . . 24

4.4 Spiegelungen . . . 28

4.5 Dualraum . . . 29

4.5.1 Zusammenhang zwischen Dualraum und inneren Produkten . . . 30

5 Über- und unterbestimmte Gleichungssysteme, QR-Zerlegung 31 5.1 QR-Zerlegung . . . 31

5.2 Überbestimmte Gleichungssysteme . . . 32

5.3 Unterbestimmte Gleichungssysteme . . . 34

III Eigenwerte 35

6 Eigenwerte in allgemeinen Körpern 36

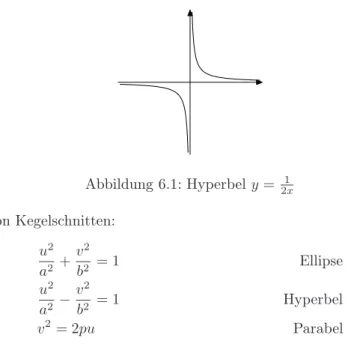

6.1 Motivation . . . 36

6.2 Eigenwerte und Eigenvektoren . . . 38

6.3 Charakteristisches Polynom von Matrizen . . . 39

6.4 Charakteristisches Polynom linearer Abbildungen . . . 43

6.5 Diagonalisierbarkeit . . . 44

6.6 Jordan-Zerlegung . . . 47

6.7 Anwendungen von Jordan-Zerlegung bzw. Diagonalisierung . . . 50

6.7.1 Matrizenpotenzen . . . 50

6.7.2 Satz von Cayley-Hamilton . . . 52

6.7.3 Asymptotisches Verhalten diskreter dynamischer Systeme . . . 52

6.7.4 Lineare Rekursionen mit konstanten Koeffizienten . . . 53

6.7.5 Differentialgleichungen . . . 55

7 Eigenwerte überR undC 56 7.1 Schursche Normalform . . . 56

7.2 Unitäre Diagonalisierbarkeit . . . 56

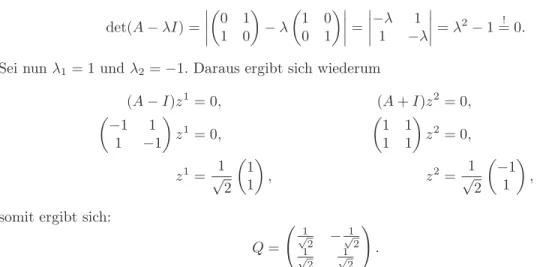

7.3 Anwendung: Klassifikation von Kegelschnitten . . . 59

8 Eigenwerte bei symmetrischen Matrizen 62 8.1 Rayleigh-Ritz-Prinzip . . . 62

8.2 Positiv definite Matrizen . . . 65

8.3 Berechnung der Cholesky-Faktorisierung . . . 67

8.4 Hadamardsche Ungleichung . . . 69

9 Nichtnegative Matrizen und der Satz von Perron-Frobenius 70 9.1 Reduzible und irreduzible Matrizen und deren kombinatorische Deutung . . . 70

9.2 Satz von Perron-Frobenius, Erster Teil . . . 72

9.3 Drehungsinvarianz von Eigenwerten . . . 74

9.4 Primitive Matrizen . . . 75

IV Singulärwertzerlegung 77

10 Singulärwertzerlegung 78 10.1 Definition, Existenz und einfache Eigenschaften . . . 7810.2 Anwendungen der Singulärwertzerlegung . . . 80

10.2.1 Über- und unterbestimmte Gleichungssysteme . . . 81

10.2.2 Kern, Bild, Rang . . . 82

10.2.3 Numerischer Rang . . . 82

10.2.4 Konditionszahl . . . 84

10.2.5 Bildkompression . . . 84

Kapitel 0

Motivation

0.1 Vektor- und Matrizennormen

Seien

A=

1.0000 1.0000 1.0000 1.0001

, c=

2.0000 2.0000

, B=

1.0000 1.0000 1.0000 0.0001

, d=

2.0000 2.0001

. Löse die Gleichungssysteme Ax(1) =c,Ax(2)=d,Bx(3) =c,Bx(4) =d:

x(1) = 2

0

, x(2) = 1

1

, x(3) = 2

0

, x(4) =

2.0001

−0.0001

Aist schlecht konditioniert,κ2(A) = 40002,B ist gut konditioniert,κ2(B) = 2.6184.

0.2 Skalarprodukte und Orthogonalität

Gegeben seien200Punktepaare

0.030309884000 10.179922000000 0.048384392000 10.120494000000 0.083117662000 10.145601000000

... ...

9.935929800000 94.606340000000 9.967067200000 95.324167000000 9.996520900000 96.100050000000 Gesucht ist jene Funktion

f(x) =a0+a1x+a2x2+a3x3+a4x4+a5ex+a6cosx+a7sinx, die die Punkte am besten approximiert.

0.3 Eigenwerte

0.3.1 Asymptotik von Matrizenprodukten

Betrachte eine (abgeschlossene) Population von Hühnern und Füchsen. Die Anzahl der Hühner zum ZeitpunktnseiHn, jene der FüchseFn. Es gelte

Fn+1= 0.6Fn+ 0.5Hn,

Hn+1=−kFn+ 1.2Hn, k„Killrate“.

Zum Zeitpunkt 0gibt esF0= 100Füchse undH0= 1000Hühner.

• Wie entwickeln sich Fn,Hn fürn→ ∞?

• Wie groß muss ksein, damit beide Populationen aussterben?

• Gibt es einen „stabilen“ Zustand?

0.3.2 Positiv Definite Matrizen

Diskretisieren der stationären Wärmeleitungsgleichung

−d2u

dx2 =f(x), 0≤x≤1, u(0) =u(1) = 0 mit dem finiten Differenzen Schema

−u(xk+h)−2u(xk) +u(xk−h)

h2 =f(xk)

ergibt ein Gleichungssystem der Gestalt

2 −1 0 0 0

−1 2 −1 0 0 0 −1 2 −1 0 0 0 −1 2 −1

0 0 0 −1 2

u1

u2

u3

u4

u5

= 1 62

f(1/6)

... f(5/6)

tridiagonale, positiv definite Matrix

0.4 Singulärwertzerlegung

Sei

A=

0.3023161 0.7667215 0.3111570

−0.2835463 0.2194864 −0.0403317

−0.1163911 0.1914451 0.0094212

−0.2112675 0.4953307 0.0587599

,

B =

0.302324 0.766728 0.311133

−0.283463 0.219550 −0.040571

−0.116693 0.191214 0.010283

−0.211201 0.495382 0.058570

.

Numerische Rechnungen ergebenrank(A) = 3, rank(B) = 2undkA−Bk2= 0.001. Wie sieht man einer Matrix an, ob ihr Rang „echt“ ist oder durch numerisches Rauschen verursacht wurde?

Teil I

Matrizennormen

Kapitel 1

Vektor- und Matrizennormen

Notation 1.0.1. Folgende Notationen werden in diesem Skriptum verwendet.

K:=RoderC K:=Körper

1.1 Vektornorm

Definition 1.1.1. SeiV einK-Vektorraum. Eine Funktionk · k:V →RheißtVektornorm wenn sie die üblichen Normaxiome

(N1) kxk ≥0undkxk= 0⇔x= 0, (N2) kαxk=|α| · kxk,

(N3) kx+yk ≤ kxk+kyk

für allex, y∈V, α∈Kerfüllt.(V,k · k)heißt normierter Raum.

Beispiel 1.1.2. V =Kn, p∈N,kxkp:= pp

|x1|p+· · ·+|xn|p. Beispiel 1.1.3. V =Kn,kxk∞:= max{|x1|, . . . ,|xn|}. Beispiel 1.1.4. V =C[a, b], p∈N,kfkp:= p

qRb

a|f(x)|pdx.

Beispiel 1.1.5. V =C[a, b],kfk∞:= sup

x∈[a,b]|f(x)|.

Bemerkung 1.1.6. Sei (V,k · k) ein normierter Raum, dann wirdV vermittels d(x, y) :=kx−yk zu einem metrischen Raum (und damit zu einem topologischen Raum).

Satz 1.1. (Normäquivalenzsatz)

Seienk · kundk · k′ zwei Normen aufKn. Dann gibt es zwei positive Konstantenc1 undc2, sodass für alle x∈Kn gilt:

c1kxk′ ≤ kxk ≤c2kxk′. Beweis. Zunächst setze:k · k′=k · k2

1. Seix= (x1, . . . , xn)t=x1e1+· · ·+xnen.Dann gilt

kxk(N3)≤ kx1e1k+. . .+kxnenk(N≤ |2) x1| · ke1k+· · ·+|xn| · kenk

≤ max

i=1...n|xi|(ke1k+. . .+kenk

| {z }

c3

)≤ 2 q

|x1|2+. . .+|xn|2c3=c3kxk2.

2. Durchf(x) :=kxkwird eine Abbildungf :Kn →Rerklärt.

Behauptung:f ist stetige Funktion vomKn versehen mit der 2-Norm nachR. Seienx, y∈Kn.O.B.d.Af(x)≤f(y). Dann gilt:

0≤f(y)−f(x) =kyk − kxk=k(y−x) +xk − kxk ≤ ky−xk+kxk − kxk ≤c3kx−yk2, also|f(y)−f(x)| ≤c3kx−yk2.

Daher istf Lipschitz-stetig mit Lipschitzkonstantec3, also stetig.

3. Die MengeS:={x∈Kn:kxk2= 1}ist abgeschlossen und beschränkt, daher kompakt.

4. f nimmt auf S sein Minimum bei x = x0 an. Daher gilt f(x) ≥ f(x0) =c4 >0 für alle x∈S.

5. Seienx∈Kn, α=kxk2. Dann gilt:

kxk= α1

αx

=|α| · kyk=|α|f(y)

∈S ≥c4kxk2.

6. Sei jetztk · k′ eine beliebige Norm. Nach 1-5 gibt es positivec3, c4, c5, c6 mit:

c4kxk2≤ kxk ≤c3kxk2, c6kxk2≤ kxk′≤c5kxk2, c4

c5

|{z}

c1

kxk′≤c4kxk2≤ kxk ≤c3kxk2≤ c3

c6

|{z}

c2

kxk′.

Bemerkung 1.1.7. Dadurch wird auf Kn durch verschiedene Normen dieselbe Topologie definiert.

1.2 Operator- bzw. Matrixnormen

Notation 1.2.1. Die Bezeichnungen „Linearer Operator“ und „lineare Abbildung“ werden in der Folge synonym verwendet.

Km×n. . . Menge derm×nMatrizen mit Einträgen ausK.

Wie soll man Matrizen eigentlich „messen“?

Jede Matrix∈Km×n kann als langer Vektor imKmn gedacht werden.

Definition 1.2.2. SeiA∈Km×n, dann definiere

kAkF :=

vu ut

Xm i=1

Xn j=1

|aij|2 (Frobeniusnorm).

Bemerkung 1.2.3. k · kF erfüllt die Normaxiome (N1) bis (N3).

Bemerkung 1.2.4. SeienA∈Km×n, B∈Kn×r, x∈Kn.Dann gilt:

kAxk2≤ kAkFkxk2, kABkF ≤ kAkFkBkF.

Die erste dieser Eigenschaften ist besonders wünschenswert (k · kF undk · k2sind verträglich).

Für eine interessante Matrixnorm soll also gelten:

kAk ≥ kAxk

kxk x6= 0.

Eine mögliche Wahl ist daher

kAk= sup kAxk

kxk : x6= 0

.

Definition 1.2.5. Seien(V,k · kV)und(W,k · kW)normierte Räume undF :V →W eine lineare Abbildung. Dann definiere:

kFkV,W := sup

kF(x)kW

kxkV

: x6= 0

„die vonk · kW undk · kV induzierte Operatornorm vonF“.

Bemerkung 1.2.6. Dadurch wird auch induzierte Matrixnorm definiert.

Satz 1.2(Eigenschaften von Operatornormen). Seien(V,k · kV),(W,k · kW),(X,k · kX)normier- te Räume,F, H:V →W, G:W →X, x∈V, α∈K.Dann gilt:

(N1) kFkV,W ≥0und kFkV,W = 0⇔F = 0 (Nullabbildung), (N2) kαFkV,W =|α| · kFkV,W,

(N3) kF+HkV,W ≤ kFkV,W+kHkV,W, (N4) kF(x)kW ≤ kFkV,WkxkV,

(N5) kG◦FkV,X ≤ kGkW,X· kFkV,W. Beweis von (N3). Es gilt:

k(F+H)(x)kW

kxkV

=kF(x) +H(x)kW

kxkV ≤ kF(x)kW

kxkV

+kH(x)kW

kxkV ≤ kFkV,W+kHkV,W. Bildet man auf beiden Seiten das Supremum über allex6= 0, so folgt

kF+HkV,W ≤ kFkV,W+kHkV,W.

Bemerkung 1.2.7. SeienV =Kn, W =Km, F :V →W linear. Dann gilt:

kFk= max{kF(x)kW : kxkV = 1} Beweis. Da

kF(x)k kxk

(N2)

=

1

kxk·F(x) =

F

1 kxk ·x

| {z }

k·k=1

,

müssen nurxmit kxkV = 1 betrachtet werden. Da diese eine kompakte Menge bilden, wird das Supremum tatsächlich angenommen, es handelt sich also um ein Maximum.

Satz 1.3. SeiA∈Kn×n. Dann gilt

• kAk∞:=kAk∞,∞= max

i=1...n

Pn

j=1|aij|„Zeilensummennorm“,

• kAk1=kAk1,1= max

j=1...n

Pn

i=1|aij|„Spaltensummennorm“.

Beweis. • Seix∈Kn mitkxk∞= 1.Dann gilt

kAxk∞= max

i=1...n|(Ax)i|= max

i=1...n

Xn j=1

aijxj

≤ max

i=1...n

Xn j=1

|aij| |xj|

|{z}

≤kxk∞=1

≤ max

i=1...n

Xn j=1

|aij|,

und damitkAk∞= max

kxk=1kAxk∞≤ max

i=1...n

Pn j=1|aij|.

Um die umgekehrte Richtung zu zeigen, wähle k ∈ {1, . . . n} so, dass Pn

j=1|akj| =

i=1...nmax Pn j=1|aij|.

Mann mussxj so wählen, dass|xj|= 1und|akj| · |xj|

|{z}

1

=akjxj.Setze

xj = (|a

kj|

akj akj 6= 0 1 akj = 0. Jetzt gilt also in obiger Ungleichung überall Gleichheit.

Kapitel 2

Sensitivität linearer Gleichungssysteme

2.1 Konditionszahl, Sensitivität linearer Gleichungssysteme bei Störung der rechten Seite

Ax=b, A(x+△x) =b+△b Wie groß ist△xhöchstens?

Seik · kin diesem und im nächsten Abschnitt eine feste Norm.

Was ist ein vernünftiges Maß für△x?

• k△xk. . . absoluter Fehler (uninteressant)

• besser: k△kxxkk. . .relativer Fehler Es gilt:

Ax+A△x=b+△b, A△x=△b,

△x=A−1△b,

k△xk=kA−1△bk ≤ kA−1k · k△bk, kbk=kAxk ≤ kAk · kxk,

alsokxk ≥ kA1kkbk, zusammen erhalten wir k△xk

kxk ≤ kAk · kA−1kk△bk kbk . Definition 2.1.1. SeiA∈Kn×n.Dann definiere

κ(A) :=

(kAk · kA−1k . . .falls A regulär, +∞ . . .falls A singulär.

„Konditionszahl von A.“

Satz 2.1. SeienA∈Kn×n, b,△b, x,△x∈Kn, Aregulär,Ax=b,A(x+△x) = (b+△b). Dann gilt:

k△xk

kxk ≤κ(A)k△bk kbk . Bemerkung 2.1.2.

1. Die Konditionszahl hängt von der gewählten Norm ab. Wegen des Normäquivalenzsatzes heißt allerdings große Konditionszahl in einer Norm auch große Konditionszahl in jeder anderen Norm.

2. große Konditionszahl⇒Matrix schlecht konditioniert, kleine Konditionszahl⇒Matrix gut konditioniert.

3. geg. Gleichungssystem Ax = b (riesig). Sei x˜ eine Näherungslösung (z.B. aus iterativem Verfahren) Sei r:=A˜x−b„Residuum“ . Anders geschrieben:Ax=b, A˜x=b+r,

=Satz⇒kx−x˜k

kxk ≤κ(A)krk kbk.

2.2 Sensitivität eines Gleichungssystems bei beidseitiger Stö- rung

Notation 2.2.1. I . . .Einheitsmatrix

Lemma 2.2.2. Sei B ∈ Kn×n mit kBk < 1. Dann ist I−B invertierbar, die Reihe P∞

k=0

Bk konvergiert, es gilt (I−B)−1= P∞

k=0

Bk und k(I−B)−1k ≤ 1−k1Bk.

Beweis. 1. Annahme:I−B ist nicht invertierbar, d.h. es gibt einx6= 0, sodass(I−B)x= 0.

Dann giltx=Bx.

kxk=kBxk ≤ kBk · kxk<kxk Widerspruch.

2.

(I−B) XN k=0

Bk= XN k=0

Bk− XN k=0

Bk+1=I−BN+1 daraus folgt:

XN k=0

Bk = (I−B)−1(I−BN+1) DakBN+1k ≤ kBk

|{z}

<1

N+1 N→∞

−−−−→0, folgt

X∞ k=0

Bk = (I−B)−1. 3.

k(I−B)−1k=k X∞ k=0

Bkk ≤ X∞ k=0

kBkk ≤ X∞ k=0

kBk

|{z}

<1

k= 1

1− kBk.

Satz 2.2. SeienA,△A∈Kn×n, b,△b, x, △x∈Kn. Es gelteAx=b,(A+△A)(x+△x) =b+△b, δ:= maxn

k△Ak

kAk , k△kbbkko

, r:=δκ(A)<1. Weiters seiA regulär. Dann gilt:

k△xk

kxk ≤2κ(A) 1−r ·max

k△Ak kAk , △bk

kbk

.

Beweis. 1. Brauche zunächst die Inverse von(A+△A) = (A+I△A) =A(I+A−1△A).

Wir wissen:kA−1△Ak ≤ kA−1k · k△Ak ≤ kA−1k ·δ· kAk=δκ(A) =r <1.

⇒obengenannte Matrix ist invertierbar (laut Lemma).

2. Multipliziere von links mitA−1

(I+A−1△A)(x+△x) =x+A−1△b, x+△x+A−1△A(x+△x) =x+A−1△b,

△x=A−1△b−A−1△A(x+△x), (2.1) k△bk ≤δkbk=δkAxk ≤δkAk · kxk,

kx+△xk=k(I+A−1△A)−1(x+A−1△b)k ≤ k(I+A−1△A)−1k ·(kxk+kA−1k · k△bk) und laut Lemma gilt

≤ 1

1−r(kxk+δkA−1k · kAk

| {z }

κ

| {z }

r

·kxk) = 1 +r 1−rkxk.

Alles in (2.1) einsetzen ergibt k△xk ≤δkA−1k · kAk

| {z }

δκ(a)

·kxk+δκ(A)1 +r

1−rkxk=δκ(A)

1 + 1 +r 1−r

| {z }

2 1−r

kxk,

daraus folgt

k△xk

kxk ≤2κ(A) 1−r max

k△Ak kAk , k△bk

kbk

.

Teil II

Innere Produkte

Kapitel 3

Innere Produkte und Orthogonalität

3.1 Unitäre Räume und Euklidsche Räume

Definition 3.1.1. Sei V ein K-Vektorraum. Eine Funktion h·,·i : V ×V → K heißt inneres Produkt (bzw. Hermitesches Produkt/Form für K=C oder Skalarprodukt fürK=R), falls für allex, y, z∈V, α∈Kgilt:

(IP1) hx, y+zi=hx, yi+hx, zi(Linearität im 2. Argument) (IP2) hx, αyi=αhx, yi

(IP3) hx, yi=hy, xi Wenn zusätzlich

(IP4) hx, xi >0 fürx6= 0

gilt, so heißt das IP positiv definit (p.d.)

(V,h·,·i)heißt Inner-Produktraum (bzw. wenn das IP positiv definit ist, unitärer Raum fallsK=C, oder Euklidscher Raum fallsK=R).

Bemerkung 3.1.2. 1.

hαx+βy, zi=hz, αx+βyi=αhz, xi+βhz, yi=

=αhz, xi+βhz, yi=αhx, zi+βhy, zi. 2. Achtung: Definitionen, Namen, Position der Konjugation variieren.

Beispiel 3.1.3. V =Rn hx, yi:=

Pn i=1

xiyi=xty

„Standard-inneres-Produkt“, ist positiv definit.

Notation 3.1.4. FürA∈Km×n schreiben wir

AH=A∗:=At die zuAadjungierte Matrix.

Bemerkung 3.1.5.

(A+B)∗=A∗+B∗ (αA)∗=αA∗ (AB)∗=B∗A∗

(A∗)∗=A

Beispiel 3.1.6. V =Cn

hx, yi= Xn i=1

xiyi=xty=x∗y

=„Standard-IP“. Da

hx, xi= Xn i=n

xixi = Xn i=1

|xi|2>0, ist das IP positiv definit.

Beispiel 3.1.7. SeiA∈Kn×n mitA∗=A.Dann ist hx, yiA:=x∗Ay ein inneres Produkt.

Beispiel 3.1.8. V =C[a, b] :={f : [a, b]→C : fstetig} hf, gi:=

Zb x=a

f(x)g(x)dx

3.2 Durch innere Produkte induzierte Normen

Definition 3.2.1. SeiV ein Vektorraum mit p.d. IPh·,·i, fürx∈V definiere kxkh·,·i:=p

hx, xi.

„Durchh·,·iinduzierte Vektornorm“.

Lemma 3.2.2 (Cauchy-Schwarzsche Ungleichung). V sei ein Innerer-Produktraum (p.d.),x, y ∈ V.Dann gilt

|hx, yi| ≤ kxk · kyk.

Beweis. Da füry= 0beide Seiten verschwinden, ist in diesem Fall nichts zu zeigen. Wir können daher annehmen, dassy6= 0. Seiµ∈K.Dann gilt

0≤ hx+µy, x+µyi=hx, xi+µhy, xi+µhx, yi+µµhy, yi. Wähleµ=−hhy,xy,yii. Es folgt

0≤ hx, xi −hx, yihy, xi

hy, yi −hx, yihy, xi

hy, yi +hx, yihy, xi hy, yihy, yihy, yi, 0≤ hx, xi −hx, yihy, xi

hy, yi , hx, yihx, yi ≤ hx, xihy, yi,

|hx, yi|2≤ kxk2· kyk2.

Satz 3.1. Die vorhin definierte Norm kxkh·,·i :=p

hx, xiist tatsächlich eine Vektornorm.

Beweis. (N1) und (N2) sind klar. Wir zeigen (N3):

kx+yk2=hx+y, x+yi = hx, xi+hy, xi+hx, yi+hy, yi=

=hx, xi+hy, yi+hx, yi+hx, yi = hx, xi+hy, yi+ 2·Rehx, yi ≤

≤ hx, xi+hy, yi+ 2|hx, yi| C.S.≤ kxk2+kyk2+ 2kxk · kyk=

= (kxk+kyk)2

Bemerkung 3.2.3. Das Standard IP auf Kn induziert die k · k2-Norm.

3.3 Skalarprodukt und Winkel

a2=b2+c2−2bccosα („Cosinus-Satz“) a=ky−xk, b=kyk, c=kxk ky−xk2=kxk2+kyk2−2kxk · kykcosα

ky−xk2=hy−x, y−xi=hy, yi − hx, yi − hy, xi+hx, xi

x

y y−x

α 0 Daraus folgt

cos∠(x, y) = hx, yi kxk · kyk

Für normierte Vektoren ist das Standard-Skalarprodukt gleich dem Cosinus des von ihnen eingeschlossenen Winkels. Wenn xund y den Winkel von90◦ einschließen: hx, yi = 0 „x und y sind orthogonal“.

3.4 Orthogonalität

In diesem Abschnitt sind alle IP p.d..

Definition 3.4.1. SeiV ein IPR,v, w∈V. vundwheißenorthogonal, wennhv, wi= 0.

Beispiel 3.4.2. V =Kn,Standard IP, v=ei, w=ej, i6=j.

Satz 3.2 (Satz von Pythagoras). Seienx, y orthogonale Vektoren, dann gilt:

kx+yk2=kxk2+kyk2. Beweis.

kx+yk2=hx+y, x+yi=hx, xi+hx, yi

| {z }

0

+hy, xi

| {z }

0

+hy, yi=kxk2+kyk2.

y x+y

x

·

Definition 3.4.3. SeiV ein IPR undW ein Teilraum vonV, dann heißt W⊥:={v∈V : hv, wi= 0 ∀w∈W} das „orthogonales Komplement vonW“

Proposition 3.4.4. Seien V, W, W⊥ wie in Definition 3.4.3. Dann ist W⊥ ein Teilraum vonV. Beweis. Seienv, v′ ∈W⊥, α, β∈K. Dann gilt für allew∈W

hw, αv+βv′i=αhw, vi

| {z }

=0

+βhw, v′i

| {z }

=0

= 0.

Proposition 3.4.5. W ∩W⊥ ={0}.

Beweis. Seiv ∈W undv∈W⊥. Dann gilt

hv, wi= 0 fürw∈W und speziell fürw=v:

0 =hv, vi ⇒v= 0.

Definition 3.4.6. SeiV ein IPR,S⊆V.S heißt Orthogonalsystem, wenn:

• v6= 0 ∀v∈S,

• hv, wi= 0 fürv 6=w∈S.

Wenn zusätzlich

• hv, vi= 1 ∀v∈S

gilt, heißtS ein Orthonormalsystem. IstS eine Basis eines TeilraumesW, so heißtS eine Ortho- gonalbasis bzw. Orthonormalbasis vonW.

Beispiel 3.4.7. V =Kn, S ={e1, . . . , en}ist Orthonormalbasis vonKn. Beispiel 3.4.8. V =C[−π, π] : gn= √12πeinx

Behauptung: (gn)n∈Z ist ein Orthonormalsystem.

hgn, gmi= Zπ

−π

√1

2πeinx 1

√2πeimxdx

= 1 2π

Zπ

−π

ei(m−n)xdx

= 1 2π

1

i(m−n)ei(m−n)x

π

−π m6=n

x|π−π m=n

= 1 2π

(cos((m−n)π)+isin((m−n)π)−cos((m−n)π)+isin((m−n)π)

i(m−n) m6=n

π−(−π) m=n

=

(0 m6=n 1 m=n

Proposition 3.4.9. Jedes Orthogonalsystem ist linear unabhängig.

Beweis. Seienv1, . . . , vk ∈S, λ1, . . . , λk∈K. 0 =λ1v1+. . .+λkvk 0 =λ1hvi, v1i

| {z }

0

+. . .+λihvi, vii+. . .+λkhvi, vki

| {z }

0

=λihvi, vii

| {z }

6

=0

.

Daraus folgtλi = 0füri= 1, . . . , k.

3.5 Darstellung von Inneren Produkten durch Matrizen

M ∈Kn×n, M∗=M,hx, yiM :=x∗M yist inneres Produkt.

Satz 3.3. SeiV ein endlich-dimensionaler IPR (IP nicht notwendigerweise p.d.) mit einer festen Basis B = {v1, . . . , vd} mit der Koordinatenabbildung ΦB : Kd → V. Dann gibt es genau eine MatrixM, sodass für alle x,y∈V

hx, yi= Φ−B1(x)∗MΦ−B1(y).

gilt. Für diese Matrix gilt M =M∗. Beweis. Seix=

Pd j=1

xjvjundy= Pd j=1

yjvj, alsoΦ−B1(x) = (x1, . . . , xd)tundΦ−B1(y) = (y1, . . . , yd)t, dann gilt

hx, yi=

* d X

j=1

xjvj, Xd k=1

ykvk +

=X

j,k

xjhvj, vk

| {z }

mjk

iyk = Φ−B1(x)∗MΦ−B1(y).

Somit giltmjk=hvj, vki1≤j,k≤d. FürM∗ folgt daraus:

M∗= (hvj, vki)1≤k≤d 1≤j≤d

= (hvk, vji)1≤k≤d 1≤j≤d

=M.

Falls es eine zweite Matrix gibt, sagen wirN, dann folgt daraus, dass für allex, y Φ−B1(x)∗MΦ−B1(y) =hx, yi= Φ−B1(x)∗NΦ−B1(y)

gilt, alsoΦ−B1(x)∗(M−N)Φ−B1(y) = 0. Sei nunC=M−N, dann gilt für alleu, v∈Kn:u∗Cv= 0.

Sei nunu=ei, v=ej. Dann folgt

(ei)∗Cej =cij,

für allei, j, somit mussC= 0gelten und daraus folgt schließlichM =N.

Kapitel 4

Innere Produkte und Lineare Abbildungen

4.1 Adjungierte Abbildungen

A∈Km×n ist lineare Abbildung Kn→Km viax7→Ax. A∗=Atist AbbildungKm→Kn. Beispiel 4.1.1. Standard-IP. Füry∈Km, x∈Kn gilt

hy, Axi

imKm

=y∗Ax=y∗(A∗)∗x= (A∗y)∗x=hA∗y, xi

imKn

Definition 4.1.2. Seien V, W IPR mit IP h·,·iV, h·,·iW, F : V → W linear. Eine Abbildung F∗:W →V heißt zu F adjungiert, wennhy, F(x)iW =hF∗(y), xiV, ∀x∈V,∀y∈W.

Beispiel 4.1.3. Fortsetzung des Beispiels 4.1.1.

IstF :x7→Axso istF∗:y7→A∗y zuF adjungiert.

Lemma 4.1.4. Seien V ein IPR mit p.d. IP und x, x′ ∈V. Gilt hx, yi=hx′, yi ∀y ∈V,dann gilt x=x′.

Beweis.

hx−x′, yi= 0 ∀y∈V Wähley=x−x′.Daraus folgt

hx−x′, x−x′i= 0 und daraus folgt wiederumx−x′= 0⇒x=x′.

Proposition 4.1.5. SeienV, W, F, F∗wie in Definition 4.1.2,h·,·isei p.d.. Dann istF∗:W →V linear.

Beweis. Seieny, z∈W, α, β∈K. Dann gilt für allex∈V

hF∗(αy+βz), xi=hαy+βz, F(x)i=αhy, F(x)i+βhz, F(x)i=

=αhF∗(y), xi+βhF∗(z), xi=hαF∗(y) +βF∗(z), xi und aus Lemma 4.1.4 folgt nun

F∗(αy+βz) =αF∗(y) +βF∗(z).

Proposition 4.1.6. Seien V, W, F wie in Definition 4.1.2. Die IP seien p.d.. G, H : W → V seien zu F adjungiert. Dann folgt G=H.

Beweis. Für allex∈V und y∈W gilt

hG(y), xi=hy, F(x)i=hH(y), xi, und aus Lemma 4.1.4 folgt

G(y) =H(y) ∀y∈W und daraus folgt natürlichG=H.

Satz 4.1. SeienV, W IPR mit p.d. IP.V sei endlich-dimensional,F :V →W linear. Dann gibt es genau eine Abbildung F∗:W →V , die zuF adjungiert ist. Sie ist gegeben durch

F∗(y) = Xd j=1

cjvj,wobei

c1

... cd

= hvi, vji−1 1≤i,j≤d

hF(v1), yi ... hF(vd), yi

und{v1, . . . , vd} eine Basis von V ist.

Beweis. Sei{v1, . . . vd} eine Basis vonV undy ∈W. Wir setzen F∗(y) =

Xd j=1

cjvj an, dann gilt:

hx, F∗(y)i=hx, Xd j=1

cjvji= Xd j=1

cjhx, vji. Andererseits gilthx, F∗(y)i=hF(x), yiund daraus folgt:

Xd j=1

hx, vjicj=hF(x), yi ∀x∈V.

DaV endlich-dimensional ist, müssen nur diex=vi mit i= 1, . . . , düberprüft werden, für alle anderenxfolgt es aus Linearkombination.

Xd j=1

hvi, vjicj =hF(vi), yi i= 1, . . . , d Das ist ein lineares GLS mit Systemmatrix:

M = (hvi, vji)1≤i,j≤d∈Kd×d.

WennM regulär ist, so hat das lineare GLS eine eindeutige Lösung, nämlich

c1

... cd

=M−1

hF(v1), yi ... hF(vd), yi

.

Annahme:M ist singulär. Dann existiert ein u6= 0∈Kd, sodass M u= 0 gilt, und daraus folgt u∗M u= 0.

0 =u∗M u= Xd i=1

Xd j=1

uihvi, vjiuj =

* d X

i=1

uivi, Xd j=1

ujvj +

, und daraus folgt:

Xd i=1

uivi= 0v=j⇒l.u.u1=. . .=ud= 0, Widerspruch.

Beispiel 4.1.7. Fortsetzung des Beispiels 4.1.1. Überprüfe Formel an diesem Spezialfall. Seivi=ei deri-te Einheitsvektor

hei, eji=

(0 i6=j

1 i=j, M =I, M−1=I.

F(ei) =ai. . . i-te Spalte vonA

hF(ei), yi= (ai)∗y

(hF(ei), yi)i=1,...,d= ((a1)∗, . . . ,(ad)∗)ty=A∗y c=IA∗y=A∗y

F∗(y) = Xd i=1

cjej= (c1. . . cd)t=A∗y

Definition 4.1.8. Sei V IPR, F : V → V linear. F heißt selbstadjungiert, wenn F = F∗ (A . . .hermitsch wennK=C, A . . .symmetrisch wennK=R).

Beispiel 4.1.9. Fortsetzung des Beispiels 4.1.1.

x7→Axist selbstadjungiert, wennA∗=A.

Proposition 4.1.10. U, V, W, endlich-dimensionale VR, F, G : V → W, H : U → V linear, α∈K. Dann gilt:

(F+G)∗=F∗+G∗ (αF)∗=αF∗ (F◦H)∗=H∗◦F∗

(F∗)∗=F

4.2 Unitäre Abbildungen

In diesem Abschnitt seien alle IP positiv definit.

Definition 4.2.1. SeienV, W IPR,F :V →W. F heißtunitär, wenn gilt:

hF(x), F(y)iW =hx, yiV ∀x, y∈V.

Bemerkung 4.2.2. Unitäre Abbildungen sind längen- und winkeltreu.

Lemma 4.2.3. Sei V ein endlich dimensionaler IPR und F :V →V linear. Dann ist F genau dann unitär, wennF∗◦F = idV.

Beweis. DaV endlich-dimensional ist, gibt es die adjungierte AbbildungF∗.

F ist unitär ⇐⇒ Für alle x, y ∈V gilthF(x), F(y)i=hx, yi ⇐⇒ Für alle x, y ∈V gilt h(F∗◦F)(x), yi=hx, yi ⇐⇒ Für allex∈V gilt(F∗◦F)(x) =x ⇐⇒ F∗◦F= id.

Im vorletzten Schritt wurde Lemma 4.1.4 benutzt.

Proposition 4.2.4. Sei A ∈ Km×n und h ·,· i das Standard-IP. Dann sind folgende Aussagen äquivalent:

1. x7→Axist unitär.

2. A∗A=I.

3. Die Spalten vonA bilden ein Orthonormalsystem.

Beweis. (1)⇔(2) folgt sofort aus Lemma 4.2.3 und Beispiel 4.1.1.

Im folgenden Beweis wird die i-te Zeile (bzw. Spalte) der Matrix A mit A(i,:)(bzw. A(:, i)) bezeichnet.

(2)⇔(3)A∗A=Igilt genau dann, wenn

hA(:, i), A(:, j)i= (A(:, i))∗·A(:, j) =A∗(i,:)·A(:, j) = (A∗A)ij =

(1 i=j 0 i6=j

Definition 4.2.5. Eine Matrix, die eine unitäre Abbildung bezüglich des Standard-IP vermittelt, heißtunitäre Matrix (fallsK=C) bzw.orthogonale Matrix (fallsK=R).

Satz 4.2. SeiV ein endlich-dimensionaler IPR. Dann bildet die Menge U(V) :={F :V →V : F ist unitär}

zusammen mit der Hintereinanderausführung von Funktionen eine Gruppe („unitäre Gruppe von V“).

Beweis. 1. SeienF, G∈U(V). H:=F◦G.

hH(x), H(y)i = hF(G(x)), F(G(y))i

Funitär

= hG(x), G(y)iGunitär= hx, yi. Daraus folgt, dass H unitär ist.

2. SeiF ∈U(V).Behauptung:F ist injektiv. Seix∈KerF, dann gilt 0 =hF(x), F(x)i=hx, xi.

Somit istx= 0und damit giltKer(F) = 0. Daraus folgt wiederum, dassF ist injektiv ist.

3. Aufgrund der Dimensionsformel folgt, dassF surjektiv und somit bijektiv ist. Deshalb exis- tiert auch die Funktion F−1.

4. AusF∗◦F = idV =F−1◦F folgt durch Multiplikation vonF−1von rechts, dassF∗=F−1. Daraus folgtidV =F◦F−1=F◦F∗= (F∗)∗◦F∗, also istF−1=F∗ unitär.

Bemerkung 4.2.6. In einer orthogonalen(n×n)-Matrix sind nach dem letzten Punkt des Beweises von Satz 4.2 auch die Zeilen orthogonal.

Definition 4.2.7. Die unitäre GruppeU(Cn)desCn wird mit Un (unitäre Gruppe der Ordnung n), jeneU(Rn)desRnwird mitOn (orthogonale Gruppe der Ordnungn) bezeichnet. Diespezielle unitäre bzw.orthogonale Gruppe der Ordnungnsind

SUn:={F ∈Un: detF = 1}, SOn:={F ∈On: detF = 1} Was sind orthogonale Matrizen imR2? SeiA∈R2×2 orthogonal.

A= a c

b d

, somit kommt man zu folgendem Ansatz:

a2+b2= 1, c2+d2= 1, ac+bd= 0,

a= cos(φ), c= cos(ψ),

b= sin(φ), d= sin(ψ),

cos(φ)·cos(ψ) + sin(φ)·sin(ψ) = 0, cos(φ−ψ) = 0.

Somit muss geltenφ−ψ=2k+12 π, und schließlichψ=φ−2k+12 πfür eink∈Z. cos(ψ) = cos(φ)·0 + sin(φ)·sin

2k+ 1 2 π

| {z }

=:s∈{±1}

cos(ψ) =s·sin(φ) sin(ψ) = sin(φ)·cos

2k+ 1 2 π

−cos(φ)·sin

2k+ 1 2 π

| {z }

s

sin(ψ) =−s·cos(φ) Somit ergibt sich für die MatrixA:

A=

cos(φ) s·sin(φ) sin(φ) −s·cos(φ)

=

cos(φ) −sin(φ) sin(φ) cos(φ)

· 1 0

0 −s

1. Fall: (s=−1)

A=

cos(φ) −sin(φ) sin(φ) cos(φ)

2. Fall: (s= 1)

A=

cos(φ) −sin(φ) sin(φ) cos(φ)

1 0 0 −1

Die vordere Matrix entspricht hierbei einer Drehmatrix um den Winkelφ(im mathematisch posi- tiven Sinn). Sie ist Element derSO2. Die hintere Matrix hingegen entspricht einer Spiegelung an derx-Achse.

Satz 4.3. Orthogonale Abbildungen desR2 sind Zusammensetzungen von Drehungen und Spiege- lungen.

Proposition 4.2.8. Sei A∈Km×n, U ∈Km×m,V ∈Kn×n, wobei U undV unitär sind. Dann gilt

1. kU Ak2=kAk2. 2. kU AkF=kAkF 3. kAVk2=kAk2 4. kAVkF =kAkF Beweis. als Übung.

4.3 Projektionen

In diesem Abschnitt ist V ein IPR mit positiv definitem IP undW ein Teilraum vonV. Definition 4.3.1. Seienx, x∈V.xheißt Projektion vonxaufW, falls:

• x∈W,

• x−x∈W⊥. x¯

x

·

W

Proposition 4.3.2. Sei x∈V. Dann gibt es höchstens eine Projektion von xauf W. Beweis. Seieny, zProjektionen vonxaufW.

x−y=y′ ∈W⊥ x−z=z′ ∈W⊥ y+y′=x=z+z′

y−z

| {z }

∈W

=z′−y′∈W⊥

daraus folgt wegen Proposition 3.4.5y−z= 0und schließlichy=z.

Satz 4.4. Seix∈V und xeine Projektion von xaufW. Dann gilt:

kx−xk= min{kx−wk : w∈W}. Beweis.

kx−wk2=kx−x

| {z }

∈W⊥

k2+kx−w

| {z }

∈W

k2 (Pythagoras), somit istkx−wk ≥ kx−xk, also istkx−xk der kürzeste Abstand.

Gibt es immer eine Projektion?

Seix∈V,undPW(x)die gesuchte Projektion mitPW :V →W hx−PW(x), wi= 0 ∀w∈W,∀x∈V

hx, wiV =hPW(x), wiW ∀x∈V,∀w∈W hx,i(w)iV =hPW(x), wiW

miti :W →V undw7→w

Also istPW :V →W adjungierte Abbildung zu i. Diese existiert auf jeden Fall, fallsW endlich- dimensional ist, da wenn{w1, . . . , wd} eine Basis vonW ist, gilt nach Satz 4.1

PW(x) = Xd j=1

cjwjfür

c1

... cd

= (hwi, wji)−1≤1i,j≤d

hw1, xi

... hwd, xi

.

Satz 4.5. Sei W endlich-dimensional. Dann gibt es genau eine Abbildung PW :V →V, sodass PW(x)die Projektion von xaufW ist (∀x∈V). Wenn{w1, . . . , wd} eine Basis von W ist, so ist

PW(x) = Xd j=1

cjwjfür

c1

... cd

= (hwi, wji)−1≤1i,j≤d

hw1, xi

... hwd, xi

.

Beweis. Siehe vorhergehende Überlegungen.

Korollar 4.3.3. SeiV =Knund{w1, . . . , wd}eine Basis vonW und seiA:= (w1. . . wd). Dann gilt

PW(x) =A·(A∗A)−1A∗x.

Beweis.

PW(x) =Ac, wobei c= (A∗A)−1A∗x.

Korollar 4.3.4. Sei{w1, . . . , wd} eine Orthonormalbasis vonW. Dann gilt PW(x) =

Xd j=1

hwj, xi ·wj.

Beweis. Durch Einsetzen von (hwi, wji)1≤i,j≤d = I und cj = hwj, xi erhält man direkt obiges Ergebnis.

Beispiel 4.3.5. V =C[−π, π], WN = span{√12πeinx : −N ≤n≤N}. Seif ∈ C[−π, π]. Suche die Projektion vonf auf WN, also den kürzesten Abstand zwischenf undWN, beziehungsweise die beste Approximation vonf durch Funktionen inWN.

PW(f) = XN n=−N

cneinx wobei

cn = 1

√2πdn= 1

√2π· h 1

√2πeinx, fi= 1 2π

Zπ

−π

e−inxf(x)dx Diecn heißen Fourierkoeffizienten vonf.

Korollar 4.3.6. FallsW endlich-dimensional ist, so giltV =W⊕W⊥,PW⊥ existiert und es gilt PW+PW⊥ = idV. Falls zusätzlich dimV <∞, dann gilt

dimW⊥= dimV −dimW.

Beweis. Seix∈V. Dann gilt:

x=PW(x)

| {z }

∈W

+ (x−PW(x))

| {z }

∈W⊥

.

Korollar 4.3.7. Seienx, y∈V mitkyk= 1. Dann gilt:

Pspan{y}(x) =hy, xi ·y, insbesondere

kPspan{y}(x)k=|hy, xi|. Beweis. Siehe Korollar 4.3.4.

Wie bekommt man eine Orthonormalbasis? Gibt es so etwas immer?

Korollar 4.3.8 (Gram-Schmidt-Verfahren). Sei {v1, . . . , vd}eine Basis von W, dann definiere:

wk :=vk−

k−1

X

j=1

hwj, vki

hwj, wjiwj k= 1, . . . , d.

Die Vektoren w1, . . . , wd bilden eine Orthogonalbasis vonW.

Beweis. Behauptung:{w1, . . . , wk} ist Orthogonalbasis vonspan{v1, . . . , vk}. k= 1 :

w1=v1. (k−1)→k:

zk:= 1 kwkkwk,

wk =vk−

k−1

X

j=1

hzj, vkizj,

=vk−Pspan{w1,...,wk−1}(vk),

daraus folgt:wk∈span{w1, . . . , wk−1}⊥. Somit folgt wiederum, dassw1, . . . , wk ein Orthogonal- system ist. Außerdem gilt

span{w1, . . . , wk}= span{w1, . . . , wk−1, vk}= span{v1, . . . , vk−1, vk}.

Bemerkung4.3.9.Das Gram-Schmidt-Verfahren ist numerisch besonders empfindlich. Auslöschung kann auftreten, wennvk+1 „fast“ ausspan{v1, . . . , vk} ist. (bsp_2_1.m,alg_2_1.m)

Satz 4.6 (Satz über Projektionsabbildungen). SeiP :V →V linear mit Im(P) =W. Dann ist P genau dann gleich der Projektionsabbildung PW, wenn:

• P2=P „P ist idempotent“,

• P∗=P „P ist selbstadjungiert“.

Beweis. 1. Für allex∈V undy∈W gilt

hPW(x), yi=hx, yi, (4.1)

hPW2(x), yi=hPW(PW(x)), yi

=hPW(x), yi,

somit folgt PW2(x) =PW(x)für allex∈V und es gilt:PW2=PW. 2. Für allex, y∈V gilt:

hPW∗(x), yi = hx, PW(y)

| {z }

∈W

i

=hPW(x), PW(y)i(4.1)= hPW(x), yi somit folgt: PW(x) =PW∗(x)für allex∈V und somitPW∗=PW.

3. Sei P eine Abbildung mit den angegebenen Eigenschaften. Für allex∈V gilt:P(x)∈W. Nun ist zu zeigen

x−P(x)∈W⊥⇔ hx−P(x), yi= 0∀y∈W ⇔ hP(x), yi=hx, yi∀y∈W.

Für alle x∈V undy∈W gilt

hP(x), yi=hx, P∗(y)i=hx, P(y)i. Schreibe nun y=P(z)für passendesz∈V, und erhalte

hx, P2(z)i=hx, P(z)i=hx, yi.

4.4 Spiegelungen

V sei ein IPR mit positiv definitem IP undW sei ein endlich-dimensionaler Teilraum.

Definition 4.4.1. Die AbbildungSW :V →V mit SW(x) = 2PW(x)−x, heißt Spiegelung anW.

PW(x) x

SW(x)

·

W

Satz 4.7. SeiF :V →V linear. Dann ist F genau dann die Spiegelung SW, wenn

• F ist unitär,

• F2= id (F ist involutorisch),

• W ={x∈V : F(x) =x} (W ist der invariante Unterraum vonF).

Beweis. 1. Es gilt

hSW(x), SW(y)i=h2PW(x)−x,2PW(y)−yi

= 4hPW(x), PW(y)i −2hx, PW(y)i −2hPW(x), yi+hx, yi

= 2hPW(x), yi+ 2hx, PW(y)i −2hx, PW(y)i −2hPW(x), yi+hx, yi

=hx, yi,

da für v∈V undw∈W hv, wi=hPW(v), wi. 2.

SW(SW(x)) =SW(2PW(x)−x) = 2PW(2PW(x)−x)−2PW(x) +x

= 4PW(PW(x))

| {z }

PW(x)

−2PW(x)−2PW(x) +x=x.

Somit istS2W die identische Abbildung.

3. SeiF eine Abbildung mit den angegebenen Eigenschaften. SeiG(x) = F(x)+x2 . Zu zeigen ist nun, dassG=PW gilt. Zeige zunächst, dass G(x)∈W, und dannx−G(x)∈W⊥.

•

F(G(x)) =F

F(x) +x 2

= 1

2(F2(x) +F(x)) = 1

2(x+F(x)) =G(x), und daraus folgtG(x)∈W.

• Seiw∈W,

hw, x−G(x)i=

w, x−F(x) +x 2

=

w,x−F(x) 2

=

=D w,x

2 E−D

F(w), Fx 2

E

=D w,x

2 E−D

w,x 2 E

= 0, und daraus folgtG(x) =PW(x)für allex.

Wir möchten nun für gegebenexundy eine Hyperebene W ={x:hx, wi= 0}= span{w}⊥ finden, sodassy=SW(x). Dabei sollwnormiert sein, d.h. kwk= 1.

SW(x) = 2PW(x)−x= 2(x−Pspan{w}(x))−x

= 2x−2(hw, xiw)−x=x−2hw, xiw.

Proposition 4.4.2. Sei V endlich-dimensional, w∈V mitkwk= 1. Dann gilt Sspan{w}⊥ =x−2hw, xiw.

Wir suchen nun einw, sodass

Sspan{w}⊥(x) =y.

Brauchekxk=kyk, daS längentreu ist.y−xmuss auf Hyperebene normal stehen, somit muss w=α(y−x)für passendesα∈Kgelten und somit

1 =kwk=|α| · ky−xk ⇒ |α|= 1 ky−xk.

Da die Multiplikation von w mit einem Skalar die Hyperebene nicht ändert, kann es nur mit w= kyy−−xxk funktioneren.

Probe:

y−

x−2

y−x ky−xk, x

y−x ky−xk

= (y−x) + 2

hy−x, y−xihy−x, xi(y−x) =

=

1 + 2 hy−x, xi hy−x, y−xi

(y−x).

Hoffnung:hy−x, y−xi=−2hy−x, xi, dies ist äquivalent zu 0 =hy−x,2x+ (y−x)i

=hy−x, x+yi=hy−x, y+xi

=hy, yi − hx, yi+hy, xi − hx, xi

= 2 Imhy, xi. Somit ergibt sich die weitere Forderunghx, yi ∈R.

Proposition 4.4.3. Seien x, y∈V,kxk=kyk,hx, yi ∈R. Setze:w= kyy−−xxk. Dann gilt Sspan{w}⊥(x) =y.

Beweis. Siehe vorhergehende Überlegungen.

4.5 Dualraum

Definition 4.5.1. SeiV einK-Vektorraum, dann heißt V∗ :={f :V →K, f linear} der Dual- raum vonV. Seine Elemente heißen „lineare Funktionale“.

Bemerkung 4.5.2. V∗ ist einK-Vektorraum.

Proposition 4.5.3. Ist V endlich-dimensional, dann ist auch V∗ endlich-dimensional und es gilt dimV∗ = dimV. Wenn {v1, . . . , vd} eine Basis von V ist, so ist eine Basis von V∗ durch {f1, . . . , fd} gegeben, wobei

fi(vj) =

(1 i=j 0 i6=j , die „duale Basis“ ist.

Beweis.

V∗∼={f :Kd→K linear} ∼=K1×d∼=Kd,

und somit giltdimV∗=d= dimV. Die Basis(ei)t, i= 1, . . . , d, desK1×dentspricht dabei genau den Abbildungenfi aus der Proposition.

4.5.1 Zusammenhang zwischen Dualraum und inneren Produkten

Sei V ein endlich-dimensionaler IPR mit p.d. IP. Für ein w ∈ V ist hw,·i : V → K, v 7→ hw, vi lineare Abbildung.

Φ :V →V∗, w7→ hw,·i.

Sei zunächstK=R. Für alle v, w, w′∈V undα, β∈Kgilt

Φ(αw+βw′)(v) =hαw+βw′, vi=αhw, vi+βhw′, vi

= (αΦ(w) +βΦ(w′))(v),

und daraus folgt, dass Φeine lineare Abbildung: V →V∗ ist. Behaupte nun Φsei injektiv, dies ist aber dasselbe wieKer Φ ={0}.

Beweis. Seiw∈V mitΦ(w) = 0. Daraus folgthw, vi= 0für allevund somit istw= 0. Aufgrund der Dimensionsformel ergibt sich nun, dass Φ surjektiv ist, und somit ist Φ natürlich auch ein Vektorraumisomorphismus.

Satz 4.8. SeiV ein endlich-dimensionaler Euklidischer Raum (mit p.d. IP). Dann ist die Abbil- dungΦ :V →V∗, w7→ hw,·iein Vektorraumisomorphismus.

WennK=Cgilt, dann istΦbijektiv und antilinear.