Statistik-Teil der Vorlesung

“Statistische und numerische Methoden”

f¨ ur Chemie-Ingenieure

Januar 2003

Unterlagen von Dr. Werner Stahel, Seminar f¨ur Statistik, ETH Z¨urich

Vorbemerkungen

a F¨ur Sie als Chemieingenieure und -Ingenieurinnen sind einige Fragestellungen der Statistik besonders wichtig:

• Eine Zielgr¨osse wie Ausbeute oder Reinheit eines Produkts oder Dauer eines Pro- zesses k¨onnen durch verschiedene Gr¨ossen beeinflusst werden, die den Prozess be- einflussen – am naheliegendsten sind Temperatur, Feuchtigkeit, Ausgangsmaterial.

– Zun¨achst gilt es, solche Zusammenh¨ange zu erfassen, was das Thema der sta- tistischen Regressionsrechnung und der Varianzanalyse ist. Die einfache oder die multiplelineare Regressionsrechnung gen¨ugt meistens.

– Optimierung von Produktions-Prozessen:Wenn man die Zusammenh¨ange kennt, wird man die Gr¨ossen so einstellen, dass der Prozess optimal l¨auft. Da- mit man diese Einstellungen systematisch und effizient findet, braucht es die Versuchsplanung

• Chemische Prozesse laufen nach bestimmten Gesetzen ab (“law and order of chemical change”, Swinbourne, 1971), die durch Differentialgleichungen modelliert werden.

In diesen Gleichungen treten Konstanten – die Reaktionsraten – auf, die oft aus Daten gesch¨atzt werden m¨ussen. In einfachen F¨allen f¨uhrt dies zur einfachen linearen Regression; oft aber sind Methoden dernichtlinearen Regression, kombiniert mit numerischer L¨osung der Differentialgleichungen, n¨otig. Diese Kombination wird auch Systemanalyse genannt.

• Chemische Bestimmungen von Konzentrationen oder Mengen von chemischen Kom- ponenten werden heute oft durch spektroskopische Messungen ersetzt. Methoden, die von Spektren auf Mengen von chemischen Komponenten schliessen lassen, geh¨oren zurmultivariaten Statistik.

f¨uhren. Wir beginnen mit der linearen Regression. Die einfache lineare Regression ben¨utzen wir dazu, grundlegendeBegriffe der Statistikzu repetieren. Das folgende Vorgehen ist typisch:

1. Man formuliert die Fragestellung und charakterisiert die Daten, die zur Verf¨ugung stehen oder gewonnen werden k¨onnen.

2. Man ¨uberlegt sich ein Wahrscheinlichkeitsmodell, das dem Wissen um die formu- lierten Vorg¨ange, die zu den Daten f¨uhren, entspricht. Dabei bleiben typischerweise einige ”‘Parameter”’ (mehr oder weniger) unbestimmt, ¨uber die man aus den Daten mehr erfahren m¨ochte. Das Modell kann formuliert werden, bevor Daten vorliegen.

3. Die Statistik baut die Br¨ucke zwischen dem Modell und den Daten. Wenn es um Paramter geht, beantwortet die Statistik die folgenden Fragen:

(a) Welcher Wert ist ist f¨ur den (respektive jeden) Parameter am plausibelsten?

Die Antwort wird durch eineSch¨atzung gegeben.

(b) Ist ein bestimmter Wert plausibel? Die Entscheidung trifft man mit einemTest.

(c) Welche Werte sind insgesamt plausibel? Als Antwort erh¨alt man eine ganze Menge plausibler Werte, die meistens ein Intervall bilden – das Vertrauens- intervall oderKonfidenzintervall.

4. In vielen Anwendungen stellt sich auch die Frage einerVorhersagevon Messungen, Beobachtungen, die noch nicht vorliegen.

c Die lineare Regression wurde in der Einf¨uhrungsvorlesung (Mathematik 2B) behan- delt. Sie werden gebeten, die entsprechenden Unterlagen als Repetition vor der er- sten Vorlesung durchzulesen. Falls Sie sie nicht mehr zur Hand haben, finden Sie auf www.stat.math.ethz.ch/~stahel/courses/cheming eine etwas l¨angere Version, die leicht zu lesen ist.

In der ersten Woche werde ich die multiple lineare Regression kurz repetieren, und in den ¨Ubungen werden Sie die entsprechenden Matlab-Befehle kennen lernen.

Die Unterlagen zum folgenden Kapitel finden Sie ebenfalls unter www.stat.math.ethz.ch/~stahel/courses/cheming

3

Zusammenfassung der Linearen Regression

1 Einfache lineare Regression

a Das Modell der einfachen linearen Regression lautet Yi=α+βxi+Ei .

Die xi sind feste Zahlen. Die Ei sind zuf¨allig und werden zuf¨allige Abweichungen oder Zufallsfehler genannt. Es wird (normalerweise) angenommen, dass

Ei∼ N h0, σ2i, Ei, Ek unabh¨angig

sei. (Man spricht auch bei anderen Annahmen ¨uber die Zufallsfehler von einfacher linearer Regression.)

Die Parameter des Modells sind die Koeffizienten α, β und die Standardabweichung σ des Zufallsfehlers.

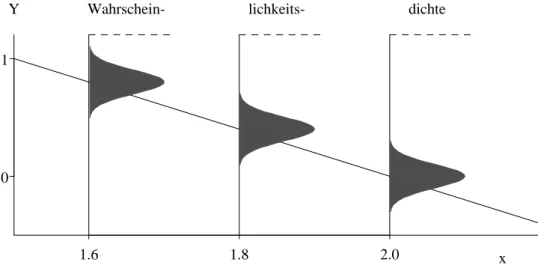

Figur 1.a veranschaulicht das Modell. Es ist n¨utzlich, sich simulierte Datens¨atze zum Modell vorzustellen.

1.6 1.8 2.0

0 1

x

Y Wahrschein- lichkeits- dichte

Abbildung 1.a: Veranschaulichung des Wahrscheinlichkeitsmodells Yi = 4−2xi+Ei f¨ur drei Beobachtungen Y1, Y2 und Y3 zu den x-Werten x1 = 1.6, x2 = 1.8 und x3= 2 b DieSch¨atzung der Koeffizientenerfolgt ¨uber das Prinzip der Kleinsten Quadrate,

das man aus dem Prinzip der Maximalen Likelihood herleiten kann. Das ergibt βb=

Pn

i=1(Yi−Y)(xi−x) Pn

i=1(xi−x)2 , αb=Y −β x .b Die Sch¨atzungen sind normalverteilt,

βb∼ N hβ, σ2/SSQ(X)i, αb∼ ND

α, σ2

1

n+x2/SSQ(X)E , SSQ(X) = Xn

i=1(xi−x)2 .

Sie sind also erwartungstreu. Ihre Varianz ist, wenn das Modell stimmt, die kleinstm¨ogliche (unter den erwartungstreuen Sch¨atzungen).

c Die Abweichungen der beobachteten Werte Yi von den gesch¨atzten oder angepassten Wer- ten αb+βxb i heissen Residuen und sind

”Sch¨atzungen“ f¨ur die Zufallsfehler Ei. Sie f¨uhren zur Sch¨atzung der Standardabweichung σ des Zufallsfehlers,

b

σ2 = 1 n−2

Xn i=1

Ri2.

d Testf¨ur die Nullhypothese β =β0: Die Testgr¨osse T = βb−β0

se(β) , se(β)= q

b

σ2/SSQ(X) ist t-verteilt mit n−2 Freiheitsgraden.

Daraus erh¨alt man das Vertrauensintervall

βb±qt0.975n−2 se(β), se(β)=σ/b q

SSQ(X). Programm-Ausgabe: siehe multiple Regression.

e Das

”Vertrauensband“ f¨ur den Wert der Regressionsfunktion verbindet die Endpunkte der Vertrauensintervalle f¨ur EhY|xi=α+βx.

Ein Prognose-Intervall soll einen (noch unbekannten) Messwert Y0 f¨ur gegebenes x0 enthalten – mit der vorgegebenen

”statistischen Sicherheit“ (von meistens 95%). Verbindet man die Endpunkte f¨ur verschiedene x0, so erh¨alt man das

”Prognoseband“.

2 Multiple lineare Regression

a Das Modell lautet

Yi = β0+β1x(1)i +β2x(2)i +...+βmx(m)i +Ei

Ei ∼ N h0, σ2i, Ei, Ek unabh¨angig. InMatrix-Schreibweise:

Y = fXβe+E , E∼ Nnh0, σ2Ii.

b Die Sch¨atzung erfolgt wieder ¨uber das Prinzip der Kleinsten Quadrate, βb= (fXTfX)−1fXTY .

Aus der Verteilung der gesch¨atzten Koeffizienten βbj ∼ N

βj, σ2

(fXTXf)−1

jj

erh¨alt man t-Tests und Vertrauensintervalle f¨ur einzelne Koeffizienten.

Die Standardabweichung σ wird gesch¨atzt durch b

σ2 =Xn i=1R2i.

(n−p).

2. MULTIPLE LINEARE REGRESSION 5 c Tabelle 2.c zeigt eineProgramm-Ausgabe, angereichert durch die mathematischen Sym-

bole.

Die multiple Korrelation R ist die Korrelation zwischen den angepassten ybi und den beobachteten Werten Yi. Ihr Quadrat misst auch den

”durch die Regression erkl¨arten Anteil der Varianz“

R2 = 1−SSQ(E)/SSQ(Y) und heisst deshalb Bestimmtheitsmass.

Coefficients:

Value Std. Error t value Pr(>|t|)

(Intercept) 19.7645 2.6339 7.5039 0.0000

pH -1.7530 0.3484 -5.0309 0.0000

lSAR -1.2905 0.2429 -5.3128 0.0000

Residual standard error: σb= 0.9108 on n−p= 120 degrees of freedom Multiple R-Squared:R2 = 0.5787

Analysis of variance

Df Sum of Sq Mean Sq F Value Pr(F)

Regression m= 2 SSQ(R)= 136.772 68.386 T = 82.43 0.0000 Residuals n−p= 120 SSQ(E)= 99.554 σb2 = 0.830 P-Wert

Total 122 SSQ(Y)= 236.326

Tabelle 2.c: Computer-Output f¨ur das Beispiel der basischen B¨oden mit Varianzanalyse- Tabelle und der im folgenden verwendeten Notation

d Vielfalt der Fragestellungen. Das Modell der multiplen linearen Regression kann viele Situationen beschreiben:

• Transformationen der X- (und Y-) Variablen k¨onnen aus urspr¨unglich nicht- linearen Zusammenh¨angen lineare machen.

• Ein Vergleich von zwei Gruppen l¨asst sich mit einer zweiwertigen X-Variablen, von mehreren Gruppen mit einem

”Block“ von dummy Variablen als multiple Regression schreiben. Auf diese Art werdennominale erkl¨arende Variable in ein Regressi- onsmodell aufgenommen.

• Die Vorstellung von verschiedenen linearen Abh¨angigkeiten f¨ur verschiedene Grup- pen von Daten kann als ein einziges Modell hingeschrieben werden. Allgemeiner k¨on- nen Wechselwirkungen zwischen erkl¨arenden Variablen durch zus¨atzliche Terme ins Modell aufgenommen werden.

• Die polynomiale Regressionist ein Spezialfall der multiplen linearen (!) Regres- sion.

e DerF-Test zum Vergleich von Modellenerm¨oglicht es, zu pr¨ufen, ob mehrere Koeffi- zienten =0 sind. Das ist n¨otig, um zu testen, ob eine nominale Variable einen Einfluss auf die Zielgr¨osse hat.

3 Residuen-Analyse

a Die Annahmen des Modells der multiplen linearen Regression kann man aufl¨osen in (a) ihr Erwartungswert ist EhEii= 0 (oder: die Regressionsfunktion ist korrekt), (b) sie haben alle die gleiche Streuung, varhEii=σ2,

(c) sie sind normalverteilt.

(d) Die Ei sind unabh¨angig,

Diese Voraussetzungen sollen ¨uberpr¨uft werden, um

• aus Abweichungen auf bessere Modelle zu schliessen,

• Tests und Vertrauensintervalle zu rechtfertigen.

Abweichungen werden mit grafischen Darstellungen entdeckt. Tests spielen eine unterge- ordnete Rolle.

b Die folgenden grafischen Darstellungen sind n¨utzlich:

(a) Nicht-Linearit¨aten: Streudiagramme der (unstandardisierten) Residuen gegen an- gepasste Werte (Tukey-Anscombe plot) und gegen die (urspr¨unglichen) erkl¨a- renden Variablen.

Wechselwirkungen: Pseudo-dreidimensionales Diagramm der (unstandardisierten) Residuen gegen je zwei erkl¨arende Variable.

(b) Gleiche Streuungen: Streudiagramme der (standardisierten) absoluten Residuen gegen angepasste Werte und gegen die (urspr¨unglichen) erkl¨arenden Variablen (meist nicht speziell dargestellt, mit den Streudiagrammen unter (a) mitbetrachtet).

(c) Normalverteilung: Q-Q-plot (oder Histogramm) der (standardisierten) Residu- en.

(d) Unabh¨angigkeit: (Unstandardisierte) Residuen gegen die Zeit oder gegen den Ort auftragen.

(*) Einflussreiche Beobachtungen f¨ur die gesamte Anpassung: Streudiagramm der (standardisierten) Residuen gegen die leverage.

Einflussreiche Beobachtungen f¨ur einzelne Koeffizienten: added-variable plot.

(*) Kollinearit¨aten: Scatterplot matrix (Streudiagramme der erkl¨arenden Variablen gegeneinander) und numerische Werte (R2j oder VIFj oder

”tolerance“).

c Massnahmen zur Verbesserung eines Modells:

• Transformation der Zielgr¨osse: bei schiefer Verteilung, Nicht-Linearit¨aten, un- gleichen Streuungen.

• Transformation(nicht-lineare) vonerkl¨arenden Variablen: bei Nicht-Linearit¨aten, Hebelpunkten (schiefe Verteilung der erkl¨arenden Variablen und einzelne hohe le- verages) und Wechselwirkungen.

• Zus¨atzliche Terme: bei Nicht-Linearit¨aten und Wechselwirkungen.

• Lineare Transformation von mehreren erkl¨arenden Variablen: beiKollinearit¨aten.

• Gewichtete Regression: bei ungleichen Streuungen.

3. RESIDUEN-ANALYSE 7

• Uberpr¨¨ ufung der Korrektheit von Beobachtungen: beiAusreissern.

• Verwerfung von Ausreissern: wenn solche vorhanden sind und man nicht robust rechnen will (siehe unten).

Wo geht’s weiter? Noch nicht behandelte Methoden:

• Verallgemeinerte Kleinste Quadrate: bei stochastischen Abh¨angigkeiten der Zufalls- fehler.

• Nicht-lineare Regression: bei Nicht-Linearit¨aten, wenn Transformationen nicht zum Ziel f¨uhren oder vom Anwendungszweck her nicht zul¨assig sind.

• Robuste Regression: immer; vor allem bei Ausreissern und langschw¨anzigen Vertei- lungen.

d Eine Regressions-Analyse ohne Residuen-Analyse ist eine unn¨utze Rechnung!

L Literatur

a Kurze Einf¨uhrungen in die Regression:

• Schlittgen (2003) ist ein empfehlenswertes Einf¨uhrungsbuch mit datenanalytischer Ausrichtung. Die einfache lineare Regression einschliesslich Residuenanalyse wird im letzten Kapitel recht gr¨undlich besprochen.

• In englischer Sprache enthalten die auch sonst empfehlenswerten Einf¨uhrungsb¨ucher von Devore (2004) und Rice (2007) Kapitel zur Regression.

b Die Literatur zum Thema Regression ist ¨ausserst umfangreich, besonders im englischen Sprachbereich.

• Ein Buch in deutscher Sprache stammt von Pokropp (1994).

• Das englische, anwendungsorientierte Buch von Chatterjee and Price (2000) ist 1995 auch in deutscher ¨Ubersetzung erschienen.

• Ein neueres, anwendungsorientiertes Buch, das auch in allgemeinere Regressionmo- delle einf¨uhrt, ist Ryan (1997).

• Weisberg (2005) betont die explorative Suche nach einem geeigneten Modell – eine empfehlenswerte Einf¨uhrung in die Praxis der Regressionsanalyse mit vielen Beispie- len.

• Draper and Smith (1998): Ein klassisches Einf¨uhrungsbuch, das der ¨uberpr¨ufung der Voraussetzungen die n¨otige Beachtung schenkt.

• Daniel and Wood (1980): Empfehlenswertes, anwendungsorientiertes Buch, das zur Entwicklung der explorativen Datenanalyse beigetragen hat und deshalb bereits zu den Klassikern geh¨ort.

• Sen and Srivastava (1990) und Hocking (1996): Mathematische Theorie und Anwen- dungsaspekte werden diskutiert. Empfohlen f¨ur mathematisch Interessierte.

c Spezielle Hinweise

• Wetherill (1986) behandelt einige spezielle Probleme der multiplen linearen Regres- sion ausf¨uhrlicher, insbesondere dieKollinearit¨at.

• In Cook and Weisberg (1999) wird gezeigt, wie man mit modernen grafischen Mitteln Modelle (nicht nur lineare) von Grund auf entwickeln kann. Es f¨uhrt in ein daf¨ur entwickeltes, einfach zu bedienendes Computer-Paket (R-code) ein, das mit dem Buch mitgeliefert wird.

• Harrell (2002) diskutiert explorative Modell-Entwicklung in der ganzen Breite und wird damit dem Titel

”Regression Modeling Strategies“ gerecht.

• Das Buch von Fox (2002) f¨uhrt anwendungsorientiert in die Entwicklung von Re- gressionmodellen ein und st¨utzt sich dabei auf die Statistiksoftware R ab.

• Die explorative Datenanalyse wurde popul¨ar durch das Buch von Mosteller and Tukey (1977), das viele Ideen enth¨alt.

• Robuste Regression wurde f¨ur die Anwendung nutzbar durch Rousseeuw and Leroy (1987). Das Thema wird vollst¨andiger und k¨urzer im Buch von Maronna, Martin and Yohai (2006) ¨uber Robuste Statistik behandelt.

Numerische und statistische Methoden f¨ur Chemieingenieure, Nov 2008

1 Nichtlineare Regression

Unterlagen von Andreas Ruckstuhl, Z¨urcher Hochschule Winterthur,

¨

uberarbeitet von Werner Stahel, ETHZ, Jan. 2000 bis 2004

1.1 Das Modell

a Regression studiert den Zusammenhang zwischen einer Zielgr¨osse Y und einer oder mehrerenAusgangs-Variablen x(j). Das allgemeine Modell lautet

Yi=hhx(1)i , x(2)i , . . . , x(m)i ; θ1, θ2, . . . , θpi+Ei.

Dabei ist h eine geeignete Funktion, die von den Ausgangs-Variablen und von Para- metern abh¨angt, die wir zu Vektoren zusammenfassen wollen, x= [x(1)i , x(2)i , . . . , x(m)i ] und θ= [θ1, θ2, . . . , θp].

b In der (multiplen)linearen Regressionwerden Funktionen h betrachtet, die linear sind in den Parametern θj,

hhx(1)i , x(2)i , . . . , x(m)i ; θ1, θ2, . . . , θpi=θ1xe(1)i +θ2xe(2)i +. . .+θpex(p)i ,

wobei die xe(j) beliebige Funktionen der urspr¨unglichen Ausgangs-Variablen x(j) sein k¨on- nen. (Die Parameter werden dort ¨ublicherweise mit βj statt θj bezeichnet.)

c In der nichtlinearen Regression werden Funktionen h untersucht, die sich nicht als lineare Funtionen in den Parametern schreiben lassen. Oft wird eine solche Funktion aus der Theorie abgeleitet. Es bestehen im Prinzip unbeschr¨ankte M¨oglichkeiten, den deter- ministischen Teil des Modells anzusetzen. Wie wir sehen werden, wird diese Flexibilit¨at erkauft durch einen gr¨osseren Aufwand, statistische Aussagen zu gewinnen.

Die Voraussetzungen f¨ur den zuf¨alligen Teil, der ja nur aus denzuf¨alligen Abweichungen oder Fehlern Ei besteht, sind die gleichen wie bei der linearen Regression:

Ei∼ N 0, σ2

, unabh¨angig.

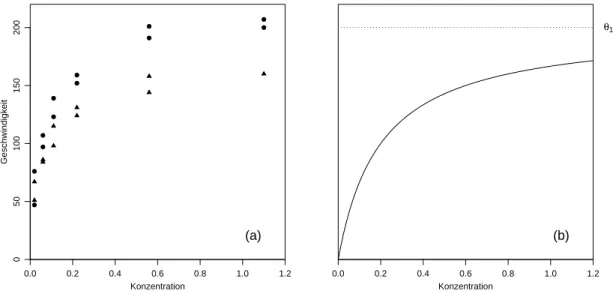

d ⊲ Beispiel Puromycin. Die Geschwindigkeit, mit der eine enzymatischen Reaktion ab- l¨auft, h¨angt von der Konzentration eines Substrates ab. Gem¨ass den Angaben von Bates and Watts (1988) wurde untersucht, wie eine Behandlung des Enzyms mit einer weiteren Substanz namens Puromycin diese Reaktionsgeschwindigkeit beeinflusst. Als Zielvariable wurde die Anfangsgeschwindigkeit der Reaktion gew¨ahlt, welche ¨uber Radioaktivit¨at ge- messen wird. (Die Einheit der Zielvariablen ist Anzahl/min2; die Anzahl Anschl¨age in einem Geigerz¨ahler pro Zeiteinheit misst ja die Quantit¨at der vorhandenen Substanz, und die Reaktionsgeschwindigkeit ist proportional zu deren Ver¨anderung pro Zeiteinheit) Der Zusammenhang der Zielgr¨osse mit der Substrat-Konzentration x (in ppm) wird be- schrieben durch dieMichaelis-Menten-Funktion

hhx;θi = θ1x θ2+x .

Version ChemIng - 11.2008, cA. Ruckstuhl / W. Stahel

F¨ur unendlich grosse Substratkonzentration (x → ∞) ergibt sich die

”asymptotische“

Geschwindigkeit θ1. Es wurde vermutet, dass diese Gr¨osse durch das Hinzuf¨ugen von Puromycin beeinflusst wird. Das Experiment wurde deshalb einmal mit dem mit Puromy- cin behandelten Enzym und einmal mit dem unbehandelten Enzym durchgef¨uhrt. Figur 1.1.d zeigt das Resultat. In diesem Abschnitt werden die Daten des behandelten Enzyms benutzt.

0.0 0.2 0.4 0.6 0.8 1.0 1.2

050100150200

Konzentration

Geschwindigkeit

(a)

Konzentration

0.0 0.2 0.4 0.6 0.8 1.0 1.2

θ1

(b)

Abbildung 1.1.d: Beispiel Puromycin. (a) Daten. • behandeltes Enzym; △ unbehan- delt) und (b) typischer Verlauf der Regressionsfunktion

⊳

e ⊲ Beispiel Sauerstoffverbrauch. Um den biochemischen Sauerstoffverbrauch zu be- stimmen, werden Flusswasserproben mit gel¨osten organischen N¨ahrstoffen, mit anorgani- schen Materialien und mit gel¨ostem Sauerstoff angereichert und in verschiedene Flaschen abgef¨ullt (Marske, 1967, siehe Bates and Watts, 1988). Jede Flasche wird dann mit ei- ner Mischkultur von Mikroorganismen geimpft und verschlossen in eine Klimakammer mit konstanter Temperatur gestellt. Die Flaschen werden periodisch ge¨offnet und nach gel¨ostem Sauerstoffgehalt analysiert. Daraus wird der biochemische Sauerstoffverbrauch [mg/l] berechnet. Das verwendete Modell, das den kumulierten biochemischen Sauerstoff- verbrauchY mit der Inkubinationszeitx in Verbindung bringt, basiert auf exponentiellem Abfall der Zuw¨achse, was zu

hhx, θi =θ1

1−e−θ2x

f¨uhrt. Figur 1.1.e zeigt die Daten und die zu verwendende Regressionsfunktion.

⊳

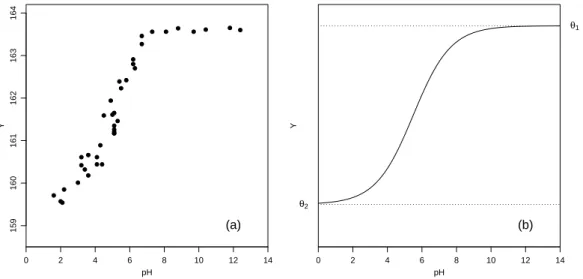

f ⊲ Beispiel aus der Membrantrenn-Technologie(Rapold-Nydegger, 1994). Das Ver- h¨altnis von protonierten zu deprotonierten Carboxylgruppen in den Poren von Cellulose- membranen ist vom pH-Wert x der Aussenl¨osung abh¨angig. Die Protonierung des Car- boxylkohlenstoffatoms kann mit 13C-NMR erfasst werden. Wir nehmen an, dass der Zu- sammenhang mit der erweiterten

”Henderson-Hasselbach-Gleichung“ f¨ur Polyelektrolyte

1.1. DAS MODELL 11

0 1 2 3 4 5 6 7 8

05101520

Tage

Sauerstoffverbrauch

(a)

Tage

0 1 2 3 4 5 6 7 8

θ1

(b)

Abbildung 1.1.e: Beispiel Sauerstoffverbrauch. (a) Daten und (b) typischer Verlauf der Regressionsfunktion

beschrieben werden kann,

log10

θ1−y y−θ2

=θ3+θ4x ,

wobei die unbekannten Parameter θ1, θ2 und θ3 >0 und θ4 <0 sind. Aufl¨osung nach y f¨uhrt zu

hhx;θi = θ1+θ210θ3+θ4x 1 + 10θ3+θ4x .

Die Regressionsfunktion hhx;θi f¨ur ein sinnvoll gew¨ahltes θ ist in Figur 1.1.f neben den Daten dargestellt.

0 2 4 6 8 10 12 14

159160161162163164

pH

Y

(a)

pH

Y

(b)

0 2 4 6 8 10 12 14

θ1

θ2

Abbildung 1.1.f: Beispiel Membrantrenn-Technologie. (a) Daten und (b) ein typischer Ver- lauf der Regressionsfunktion.

⊳

g Einige weitere Beispiele f¨ur nichtlineare Regressionsfunktionen:

• Hill-Modell (Enzymkinetik):

hhx;θi =θ1xθ3/(θ2+xθ3).

F¨ur θ3 = 1 ist dies auch unter dem Namen Michaelis-Menten-Modell bekannt (1.1.d).

• Die Mitscherlich-Funktion wird in der Wachstumsanalyse verwendet, hhx;θi =θ1+θ2exphθ3xi .

• Aus der Kinetik (Chemie) stammt die Funktion hD

x(1), x(2); θE

= expD

−θ1x(1)expD

−θ2/x(2)E E .

• Die Produktions-Funktion von Cobbs und Douglas Cobbs-Douglas-Modell lautet hD

x(1), x(2);θE

=θ1

x(1)θ2 x(2)θ3

.

Da die n¨utzlichen nichtlinearen Regressionsfunktionen aus der Theorie des jeweiligen An- wendungsgebietes hergeleitet werden, ist eine allgemeine ¨Ubersicht von beschr¨anktem Nut- zen. Eine Zusammenstellung von Funktionen aus Publikationen findet man in Anhang 7 von Bates and Watts (1988).

h Einige nichtlineare Regressionsfunktionen lassen sich durch Transformationen der Ziel- gr¨osse und der Ausgangs-Variablen linearisieren.

Beispielsweise l¨asst sich eine Potenzfunktion, hhx;θi =θ1xθ2

zu einer (in den Parametern) linearen Funktion transformieren, lnhhhx;θi i= lnhθ1i+θ2lnhxi =β0+β1xe=eh

e x;β

,

wobei β0 = lnhθ1i, β1 =θ2 und ex= lnhxi ist. Die Regressionsfunktion h nennen wir linearisierbar, wenn sie durch Transformationen der Argumente und eine monotone Transformation des Resultats in eine in den Parametern lineare Funktion verwandelt werden kann.

Hier einige weitere linearisierbare Funktionen (siehe auch Daniel and Wood (1980)):

y=θ1x/(θ2+x) ←→ 1/y= 1/θ1+θ2/θ11x y= exp

−θ1x(1)exp

−θ2/x(2) ←→ lnhlnhyi i= lnh−θ1i + ln x(1)

−θ2/x(2) y=θ1 x(1)θ2

x(2)θ3

←→ lnhyi= lnhθ1i +θ2 ln x(1)

+θ3 ln x(2)

. Das letzte ist das Cobbs-Douglas-Modell aus 1.1.g.

1.1. DAS MODELL 13 i Eine lineare Regression mit der linearisierten Regressionsfunktion beruht im genannten

Beispiel auf dem Modell

lnhYii =βe0+βe1xei+Ei,

wobei die Zufallsfehler Ei alle der gleichen Normalverteilung folgen. Transformieren wir dieses Modell zur¨uck, so erhalten wir

Yi =θ1xθ2 Eei

mit Eei = exphEii. Die Fehler Eei, i = 1, . . . , n wirken nun multiplikativ und sind lo- gnormal verteilt! Die Annahmen ¨uber die Zufallsabweichungen ver¨andern sich also recht drastisch gegen¨uber einem Modell, das direkt auf h basiert,

Yi =θ1xθ2+Ei∗

mit Zufallsabweichungen Ei∗, die wie ¨ublich einer einzigen Normalverteilung folgen.

Eine Linearisierung der Regressionsfunktion ist deshalb nur dann angebracht, wenn damit auch die Annahmen ¨uber die Zufallsabweichungen besser befriedigt werden k¨on- nen – im Beispiel, falls tats¨achlich die Fehler eher multiplikativ als additiv wirken und lognormal statt normal verteilt sind. Diese Annahmen m¨ussen mit Residuen-Analyse gepr¨uft werden.

j Diese ¨Uberlegung kann umgekehrt auch dazu f¨uhren, dass man aus einem linearen Regres- sionsmodell ein nichtlineares macht.

⊲ Beispiel Schadstoffe im Tunnel. (Text aus der Einf¨uhrung in die lineare Regression.) Die Schadstoffe, die vom motorisierten Verkehr ausgestossen werden, bilden einen wesent- lichen Bestandteil der Belastung der Luft. Um die Gr¨osse dieser Belastung zu sch¨atzen, werden f¨ur die Fahrzeuge so genannte Emissionsfaktoren bestimmt. Dies kann einer- seits auf dem Pr¨ufstand geschehen, auf dem die Strasse mit Rollen simuliert wird. Der Widerstand der Rollen wird dabei variiert, so dass ein typischer

”Fahrzyklus“ durchge- spielt werden kann. – Andererseits eignen sich Strassentunnels mit Ein-Richtungs-Verkehr f¨ur Messungen unter realen Bedingungen. Misst man Schadstoff-Konzentrationen am An- fang und am Schluss des Tunnels und z¨ahlt, wie viele Fahrzeuge durch den Tunnel fahren, so kann man ebenfalls Emissionsfaktoren ausrechnen. Allerdings erh¨alt man zun¨achst nur einen gemittelten Faktor f¨ur jeden gemessenen Schadstoff, und dieser l¨asst sich nicht ohne zus¨atzliche Erkenntnisse auf andere Strassenabschnitte ¨ubertragen. Wenn man die Anzahl der Fahrzeuge nach Fahrzeug-Kategorien aufteilen kann, dann kann man immerhin mit Regressionsrechnung zu einem Emissionsfaktor f¨ur jede Fahrzeug-Kategorie kommen.

W¨ahrend einer Woche im September 1993 wurden in der S¨udr¨ohre des Gubrist-Tunnels n¨ordlich von Z¨urich solche Messungen durchgef¨uhrt. Die Schadstoff-Konzentrationen am Anfang und am Ende wurden gemessen und die Luftstr¨omung erfasst. Daraus l¨asst sich die Schadstoff-Emission Y pro Kilometer f¨ur alle durchgefahrenen Fahrzeuge zusammen berechnen. Von einem Schlaufen-Detektor im Strassenbelag wurden die Fahrzeuge in zwei Kategorien gez¨ahlt: Auf Grund des Abstands von Vorder- und Hinterachse wurden die Lastwagen von den ¨ubrigen Fahrzeugen getrennt. Es bezeichne x(1) die Anzahl

”Nicht- Lastwagen“ und x(2) die Anzahl Lastwagen. Die gesamten Emissionen in der Zeitperiode i setzen sich zusammen gem¨ass

Yi =θ1x(1)i +θ2x(2)i +Ei ,

wobei θ1 die durchschnittliche Emission pro Nicht-Lastwagen und θ2 diejenige pro Last- wagen bedeutet – also die Gr¨ossen, an denen wir in der Studie prim¨ar interessiert sind.

Die”Zufallsfehler“ Ei entstehen durch Variationen in Bauart und Zustand der Fahrzeuge, durch zeitliche Abgrenzungs-Schwierigkeiten und durch Mess-Ungenauigkeiten.

Lastwagen-Anteil

Ef.NOx

0.0 0.05 0.10 0.15 0.20 0.25 0.30

02000400060008000

Abbildung 1.1.j: Emissionsfaktor f¨ur NOx und Lastwagen-Anteil, gemittelt ¨uber jeweils 15 Minuten, im Beispiel der Schadstoffe im Tunnel. Drei extrem hohe Y-Werte sind im Bildrand dargestellt.

Die Formel l¨asst sich in eine ¨ublichere und vielleicht noch einfachere Form bringen: Wir dividieren Yi, x(1)i und x(2)i durch die gesamte Anzahl Fahrzeuge x(1)i +x(2)i und erhalten Yei = θ1xe(1)i +θ2ex(2)i +Eei, wobei Yei der

”mittlere Emissionsfaktor“ f¨ur die Zeitperiode i und xe(1)i und ex(2)i die Anteile der Nicht-Lastwagen und der Lastwagen bedeuten. Da e

x(1)i = 1−xe(2)i ist, gilt

Yei =θ1+ (θ2−θ1)xe(2)i +Eei .

⊳

k ⊲ Die einfache und plausible ¨Uberlegung, wie die Schadstoffe zusammenkommen, hat also auf ein einfaches lineares Regressionsmodell gef¨uhrt,

Yi=β0+β1xi+Ei

(mit β0 = θ1, β1 = θ2 −θ1 und xi = xe(2)i ). In Figur 1.1.j zeigt sich als Tendenz in der Tat eine lineare Zunahme des mittleren Emissionsfaktors f¨ur NOx mit zunehmen- dem Lastwagen-Anteil. Es wird aber auch klar, dass die Zufallsabweichungen eine schiefe Verteilung haben.

Bei solchen Verteilungen wurde angeraten, die Zielgr¨osse zu transformieren, und dabei zuerst die Logarithmus-Transformation zu versuchen. Wenn wir dies aber in der ¨ublichen Weise tun, wird die logarithmierte Zielgr¨osse als lineare Funktion der gegebenen Ausgangs- Variablen angesetzt, also lnhYii =β0 +β1xi+Ei. Das widerspricht der ¨Uberlegung, die

1.2. METHODIK ZUR SCH ¨ATZUNG DER PARAMETER 15 zum Modell gef¨uhrt hat. Da die Regressionsfunktion durch diese ¨Uberlegung festgelegt ist, m¨ussen wir beide Seiten transformieren, ehD

x;βeE

= lnhβ0+β1xi und erhalten als Modell lnhYii = lnhβ0+β1xii +Ei .

⊳

Hier haben wir also die lineare Regressionsfunktion in eine nichtlineare verwandelt, um einen geeigneten additiven Fehlerterm Ei zu erhalten.

l Soweit die einf¨uhrenden Beispiele.

Wir haben fast ausschliesslich von Regressionfunktionen gesprochen, die nur von einer Ausgangs-Variablen abh¨angen. Dies geschah vor allem, weil dann eine Grafik das Modell umfassend veranschaulichen kann. Die nun folgende Theorie funktioniert ebenso gut f¨ur Regressionsfunktionenhhx;θi, die von mehreren Ausgangs-Variablenx= [x(1), x(2), ..., x(m)] abh¨angen.

1.2 Methodik zur Sch¨ atzung der Parameter

a Um Sch¨atzungen f¨ur die Parameter θ = [θ1, θ2, . . . , θp]T zu erhalten, wendet man, wie in der linearen Regression, das Prinzip der Kleinsten Quadrate an. Die Summe der quadrierten Abweichungen

Shθi :=Xn

i=1(yi−ηihθi)2 mit ηihθi :=hhxi;θi

soll also minimiert werden. Die Schreibweise, die hhxi;θi durchηihθi ersetzt, ist sinnvoll, weil nach der Messung oder Beobachtung die Daten [xi, yi] gegeben sind und nun die Parameter θ zu bestimmen bleiben.

Leider lassen sich das Minimum der Quadratsumme und damit die Sch¨atzungen nicht wie in der linearen Regression explizit angeben. Iterative numerische Verfahren helfen weiter. Die Grundidee, die hinter dem ¨ublichen Algorithmus steckt, soll hier skizziert werden. Sie bildet auch die Basis f¨ur die einfachste Art, Tests und Vertrauensbereiche herzuleiten.

b Geometrische Veranschaulichung.Die beobachteten Werte Y = [Y1, Y2, ..., Yn]T legen einen Punkt im n-dimensionalen Raum fest. Das Gleiche gilt f¨ur die

”Modellwerte“η(θ) = [η1hθi, . . . , ηnhθi]T f¨ur gegebenes θ.

Achtung! Die ¨ubliche geometrische Veranschaulichung von Daten, die beispielsweise in der Multivariaten Statistik grundlegend ist, betrachtet die Beobachtungen, die durch m Variable X(j), j= 1,2, ..., m, festgelegt sind, als Punkte im m-dimensionalen Raum. Hier betrachten wir dieY- und η-Werte aller nBeobachtungen als Punkte imn-dimensionalen Raum.

Leider h¨ort unsere Anschauung bei drei Dimensionen, also bei drei Beobachtungen auf.

Versuchen wir es also f¨ur ein solches Minibeispiel.

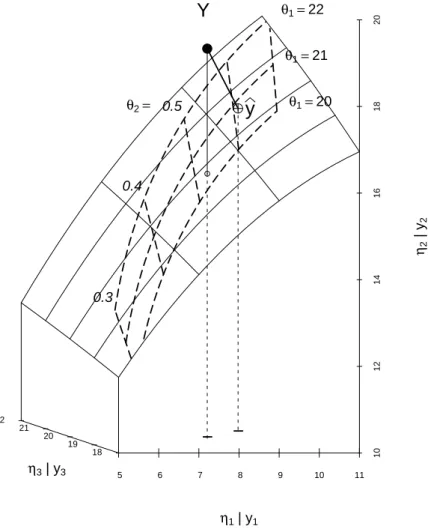

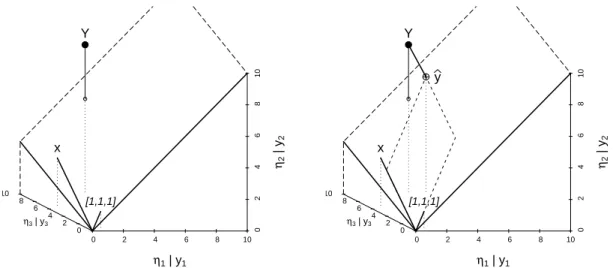

c ⊲ Im Beispiel des Sauerstoffverbrauchs sind die Messungen f¨ur die Tage 1, 4 und 7 – also x= [1,4,7]T gleich Y = [8.3,16,19.8]T. Die beiden Vektoren legen je einen Punkt im dreidimensionalen Raum fest.

Obwohl es f¨ur diese Daten wenig n¨utzt, wollen wir zun¨achst die Anpassung einer Geraden, also eineeinfache lineare Regression, betrachten. F¨ur gegebene Parameter β0 = 5 und β1 = 1 k¨onnen wir die Modellwerteηi

β

=β0+β1xi ausrechnen und den entsprechenden Vektor η

β

=β01 +β1x ebenfalls als Punkt darstellen (Figur 1.2.c). Nun fragen wir, wo alle Punkte liegen, die durch Variation der Parameter erreicht werden k¨onnen. Sie sind die m¨oglichen Linearkombinationen (Summen von Vielfachen) der beiden Vektoren 1 und x und bilden deshalb die Ebene die

”durch 1 und x aufgespannt“ wird. Figur 1.2.c h¨alt das grafisch fest.

0 2 4 6 8 10

0 2 4 6 810

0 2 4 6 8 10

η1 | y1

η2 | y2

η3 | y3

Y

[1,1,1]

x

0 2 4 6 8 10

0 2 4 6 810

0 2 4 6 8 10

η1 | y1

η2 | y2

η3 | y3

Y

[1,1,1]

x

y

Abbildung 1.2.c: Geometrische Veranschaulichung der einfachen linearen Regression. Die Werte von η

β

= β0 +β1x f¨ur varierende Parameter [β0, β1] f¨uhren zu einer Ebene im Raum. Rechts ist zus¨atzlich der Punkt auf der Ebene eingezeichnet, der dem Punkt Y = [Y1, Y2, Y3] am n¨achsten liegt. Er stellt die angepassten Werte yb dar und legt die gesch¨atzten Parameterwerte βb fest.

Zur¨uck zum Problem der Sch¨atzung der Parameter. Das Kriterium S β

ist, geometrisch ausgedr¨uckt, der quadrierte Abstand zwischen Y und η

β

. Gesucht ist also der Punkt auf der Ebene, der den kleinsten Abstand zu Y hat. Dieser wird auch die Projektion von Y auf die Ebene genannt. Die Parameterwerte, die diesem Punkt ηbentsprechen, sind dann die gesch¨atzten Parameterwerte βb= [βb0,βb1]T.

⊳

d Nun soll die nichtlineare Funktion hhx;θi = θ1exph1−θ2xi an die gleichen drei Beob- achtungen angepasst werden. F¨ur θ1 = 16 und θ2 = 0.4 erh¨alt man ηhθi = hhx;θi = [5.275,12.770,15.027]T. Ver¨andert man die beiden Parameter, so erh¨alt man eine zweidi- mensionale, gekr¨ummte Fl¨ache im dreidimensionalen Raum, siehe Figur 1.2.d.

e DasSch¨atzproblem besteht wieder darin, den Punkt ηbauf der Fl¨ache zu finden, der Y am n¨achsten liegt. In Figur 1.2.e sieht man, dass der entsprechende Wert bθ1 etwas kleiner als 21 und θb2 etwas gr¨osser als 0.6 ist. Die genaue L¨osung ist θb= [20.82,0.6103]T .

1.2. METHODIK ZUR SCH ¨ATZUNG DER PARAMETER 17

5 6 7 8 9 10 11

101214161820

18 19 20 21 22

η1 | y1

η2 | y2

η3 | y3

− Y

Abbildung 1.2.d: Geometrische Veranschaulichung der nichtlinearen Regression. Die Werte von ηhθi = hhx.;θ1, θ2i f¨ur varierende Parameter [θ1, θ2] f¨uhren zu einer zweidimensio- nalen

”Modellfl¨ache“ im dreidimensionalen Raum. Die Linien auf der Fl¨ache entsprechen konstantem η1 respektive η3.

f Die Hauptidee des ¨ublichenAlgorithums’ l¨auft wie folgt: Wenn ein vorl¨aufig bester Wert θ(ℓ) vorliegt, approximiert man die Modellfl¨ache durch die Ebene, die die Fl¨ache im Punkt η

θ(ℓ)

=h

x;θ(ℓ)

ber¨uhrt. Nun sucht man den Punkt in dieser Ebene, der am n¨achsten bei Y liegt. Das l¨auft auf die Sch¨atzung in einem linearen Regressionsproblem hinaus.

Dieser neue Punkt liegt auf der Ebene, aber nicht auf der Fl¨ache, die dem nichtlinearen Problem entspricht. Er legt aber einen Parametervektor θ(ℓ+1) fest, und mit diesem geht man in die n¨achste Iterations-Runde.

g Um die approximierende Ebene zu bestimmen, brauchen wir die partiellen Ableitungen A(j)i hθi := ∂ηihθi

∂θj ,

die wir zu einer n×p-Matrix A zusammenfassen k¨onnen. Die Approximation der Mo- dellfl¨ache ηhθi durch die

”Tangentialebene“ in einem Parameterwert θ∗ lautet ηihθi ≈ηihθ∗i +A(1)i hθ∗i(θ1−θ∗1) +...+A(p)i hθ∗i(θp−θ∗p)

5 6 7 8 9 10 11

101214161820

18 19 20 21 22

η1 | y1

η2 | y2

η3 | y3

− Y

θ1=20 θ1=21 θ1=22

0.3 0.4

θ2= 0.5

− y

Abbildung 1.2.e: Geometrische Veranschaulichung der nichtlinearen Regression. Es sind zus¨atzlich Linien konstanter Parameterwerte θ1 respektive θ2 eingezeichnet. Der Vektor der gesch¨atzten Modellwerte yb= hD

x;θbE

ist der Punkt auf der Fl¨ache, der dem Punkt Y am n¨achsten liegt.

oder, in Matrixschreibweise,

ηhθi ≈ηhθ∗i+Ahθ∗i(θ−θ∗).

Wenn wir nun den Zufallsfehler wieder hinzuf¨ugen, erhalten wir ein lineares Regressions- modell

Y −ηhθ∗i = Ahθ∗iβ+E mit den

”vorl¨aufigen Residuen“ Yi−ηihθ∗i als Zielgr¨osse, den Spalten von A als Regres- soren und den Koeffizienten βj =θj−θj∗ (ein Modell ohne Achsenabschnitt β0).

h Der Gauss-Newton-Algorithmus besteht darin, ausgehend von einem Startwert θ(0) f¨ur θ das gerade eingef¨uhrte lineare Regressionsproblem mit θ∗ =θ(0) zu l¨osen, um eine Korrektur βb und daraus einen verbesserten Wert θ(1) =θ(0)+βb zu erhalten. F¨ur diesen wird wieder das approximierende Modell ausgerechnet, also die Residuen Y−η

θ(1) und die partiellen Ableitungen A

θ(1)

bestimmt, und daraus ergibt sich θ(2). Mit diesem Iterationsschritt wird so lange weitergefahren, bis die Korrektur β vernachl¨assigbar wird.

1.3. SCH ¨ATZUNG DER PARAMETER: STARTWERTE UND BEISPIELE 19 Es kann nicht garantiert werden, dass dieses Verfahren tats¨achlich das Minimum der Qua- dratsumme findet. Die Chancen daf¨ur stehen besser, je besser sich die p-dimensionale Modellfl¨ache im Minimum bθ= (bθ1, . . . ,θbp)T durch eine p-dimensinale

”Ebene“ lokal ap- proximieren l¨asst, und je n¨aher der Startwert θ(0) zur gesuchten L¨osung ist.

i* Komfortable Algorithmen bestimmen die Ableitungsmatrix A numerisch. In komplexeren Proble- men kann die numerische N¨aherung ungen¨ugend sein und Konvergenzprobleme verursachen. Dann ist es von Vorteil, wenn analytische Ausdr¨ucke f¨ur die ersten partiellen Ableitungen angegeben werden k¨onnen. Damit kann die Ableitungsmatrix numerisch zuverl¨assiger bestimmt werden und das Verfahren konvergiert eher (siehe jedoch auch Abschnitt 1.7).

1.3 Sch¨ atzung der Parameter: Startwerte und Beispiele

a Ein iteratives Verfahren ben¨otigt Startwerte, damit es ¨uberhaupt angewandt werden kann. Gute Startwerte helfen, dass das iterative Verfahren schneller und sicherer die L¨osung findet. Einige M¨oglichkeiten, diese mehr oder weniger einfach zu gewinnen, werden hier kurz vorgestellt.

b Wie schon in der Einleitung bemerkt, stammen die nichtlinearen Modelle vielfach aus theoretischen ¨Uberlegungen in der jeweiligen Substanzwissenschaft. Bestehen schonVor- kenntnisse aus ¨ahnlichen Experimenten, so k¨onnen diese verwendet werden, um Start- werte zu gewinnen. Um sicher zu gehen, dass der gew¨ahlte Startwert passt, ist es ratsam, die Regressionsfunktion hhx;θi f¨ur verschiedene m¨ogliche Startwerte θ = θ0 graphisch mit den Daten zusammen darzustellen (z. B. so wie in Abbildung 1.3.c, rechts).

c Manchmal ist man wegen der Verteilung der Fehler gezwungen, in Modellen mitlineari- sierbaren Regressionsfunktionenbei der nichtlinearen Form zu verbleiben. Im Beispiel der Schadstoffe im Tunnel (1.1.j) war sogar der Ausgangspunkt ein lineares Modell, das wegen der Verteilungsannahmen in ein nichtlineares verwandelt wurde. Das lineare Modell kann aber Startwerte liefern.

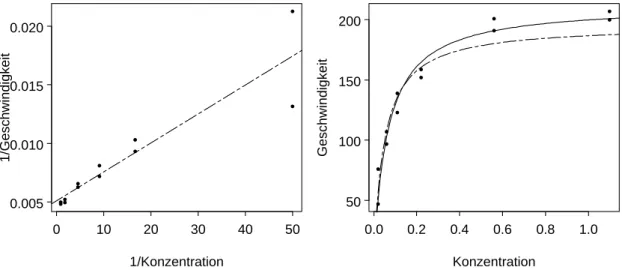

⊲ ImBeispiel Puromycinist die Regressionsfunktion linearisierbar: Die Kehrwerte der beiden Variablen erf¨ullen

e y= 1

y ≈ 1

hhx;θi = 1 θ1 +θ2

θ1 1

x =β0+β1ex .

Die Kleinste-Quadrate-L¨osung f¨ur dieses modifizierte Problem istβb= [bβ0,βb1]T = (0.00511,0.000247)T (Figur 1.3.c (a)). Das liefert die Startwerte

θ1(0)= 1/bβ0 = 196, θ(0)2 =βb1/βb0= 0.048.

⊳

•

•

•

•

••

••

••••

1/Konzentration

1/Geschwindigkeit

0 10 20 30 40 50

0.005 0.010 0.015 0.020

•

•

•

•

•

•

••

•

• •

•

Konzentration

Geschwindigkeit

0.0 0.2 0.4 0.6 0.8 1.0 50

100 150 200

Abbildung 1.3.c: Beispiel Puromycin. (a) Regressionsgerade im linearisierten Problem.

(b) Regressionsfunktion hhx;θi f¨ur die Startwerte θ(0) ( ) und f¨ur die Kleinste- Quadrate-Sch¨atzung bθ (——).

d ⊲ Im Beispiel Puromycin k¨onnen wir auch noch auf eine andere, instruktive Art zu Startwerten gelangen: θ1 ist der y-Wert f¨ur x=∞. Da die Regressionsfunktion monoton steigend ist, k¨onnen wir den maximalen yi-Wert oder einen visuell bestimmten

”asympto- tischen Wert“ θ10= 207 als Startwert f¨ur θ1 ben¨utzen. Der Parameter θ2 ist der x-Wert, bei dem y die H¨alfte des asymptotischen Wertes θ1 erreicht. Das ergibt θ02 = 0.06.

⊳

Die Startwerte ergeben sich also aus der geometrischen Bedeutung der Parameter und einer groben Bestimmung der entsprechenden Aspekte von einer von Auge eingepassten“

Kurve.

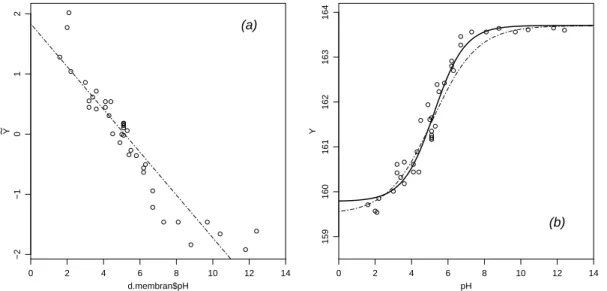

e ⊲ Lassen wir im Beispiel aus der Membrantrenn-Technologie x → ∞ gehen, so geht hhx;θi → θ1 (da θ4 < 0); f¨ur x → −∞ geht hhx;θi → θ2. Aus Figur 1.1.f (a) und den Daten geht hervor, dass θ1≈163.7 und θ2 ≈159.5 ist. Sind θ1 und θ2 bekannt, so kann man die Regressionsfunktion linearisieren durch

e

y:= log10

*θ(0)1 −y y−θ2(0)

+

=θ3+θ4x .

Man spricht von einerbedingt linearisierbaren Funktion. Die lineare Regression f¨uhrt zu den Startwerten θ(0)3 = 1.83 und θ4(0)=−0.36.

Mit diesen Startwerten konvergiert der Algorithmus zur L¨osung θb1 = 163.7, bθ2 = 159.8, bθ3 = 2.67 und bθ4 =−0.512. Die Funktionen h

·;θ(0)

und hD

·;bθE

sind in Figur 1.3.e (b) dargestellt.

* Die Eigenschaft der bedingten Linearit¨at von Funktionen kann auch dazu benutzt werden, einen dieser Situation speziell angepassten Algorithmus zu entwickeln (siehe z. B. Bates and Watts (1988)).

1.4. GEN ¨AHERTE TESTS UND VERTRAUENSBEREICHE 21

0 2 4 6 8 10 12 14

−2−1012

d.membran$pH

Y

(a)

0 2 4 6 8 10 12 14

159160161162163164

pH

Y

(b)

Abbildung 1.3.e: Beispiel aus der Membrantrenn-Technologie. (a) Regressionsgerade, die zur Bestimmung der Startwerte f¨ur θ3 und θ4 gebraucht wird. (b) Daten und Regressions- funktion hhx;θi f¨ur die Startwerte θi=θ(0) ( ) und f¨ur die der Kleinste-Quadrate- Sch¨atzung θi=bθ (——).

1.4 Gen¨ aherte Tests und Vertrauensbereiche

⊳

a Die Sch¨atzung θb liefert den Wert von θ, der optimal zu den Daten passt. Nun fragen wir, welche Parameterwerte θ mit den Beobachtungen vertr¨aglich sind. Der Vertrau- ensbereich ist die Menge all dieser Werte. F¨ur einen einzelnen Parameter θj wird der Vertrauensbereich zumVetrauensintervall oderKonfidenzintervall.

Die Resultate, die nun folgen, beruhen darauf, dass die Sch¨atzung bθ asymptotisch multi- variat normalverteilt ist. F¨ur einen einzelnen Parameter f¨uhrt das zu einem

”z-Test“ und zum entsprechenden Vertrauensintervall; f¨ur mehrere Parameter kommt der entsprechende Chiquadrat-Test zum Zug und liefert elliptische Vertrauensbereiche.

b Dieasymptotischen Eigenschaftender Sch¨atzung k¨onnen aus der linearen Approxima- tion hergeleitet werden. Das Problem der nichtlinearen Regression ist ja n¨aherungsweise gleich dem in 1.2.g erw¨ahnten linearen Regressionsproblem, wenn der Parametervektor θ∗, der f¨ur die Linearisierung verwendet wird, nahe bei der L¨osung liegt. Im L¨osungspunkt bθ ist die L¨osung f¨ur β im linearen Problem exakt = 0 – sonst w¨are es nicht die L¨osung. Die Standardfehler der Koeffizienten β – und allgemeiner die Kovarianzmatrix von βb – geben aber n¨aherungsweise die entsprechenden Gr¨ossen f¨ur bθ wieder.

* Etwas genauer: Die Standardfehler geben ja die Unsicherheiten wieder, die durch die Zufalls- schwankungen der Daten erzeugt werden. Die vorliegenden Daten haben zum Sch¨atzwertθbgef¨uhrt.

W¨aren die Daten etwas anders ausgefallen, dann w¨are θbimmer noch ungef¨ahr richtig, also – so nehmen wir an – gut genug f¨ur die Linearisierung. Die Sch¨atzung von β f¨ur den neuen Datensatz w¨urde also so weit vom Sch¨atzwert f¨ur den vorliegenden Daten weg liegen, wie es der Verteilung der Parameter im linearisierten Problem entspricht.

c Aus dieser ¨Uberlegung folgt: Asymptotisch ist die Kleinste-Quadrate-Sch¨atzung θb nor- malverteilt (und konsistent) und deshalb

bθ≈∼ Nhθ,Vhθi/ni .

mit asymptotischer Kovarianzmatrix Vhθi =σ2(AhθiTAhθi)−1, wobei Ahθi die n×p Matrix der partiellen Ableitungen ist (1.2.g).

Um die Kovarianzmatrix explizit zu bestimmen, wird Ahθi an der Stelle bθ berechnet, und f¨ur die Fehlervarianz σ2 wird die ¨ubliche Sch¨atzung eingesetzt,

d

Vhθi =σb2 AD

bθE

TAD θbE−1

, σb2= 1 n−pSD

θbE

= 1

n−p Xn

i=1(yi−hhxi;θbi)2. Damit ist dieVerteilung der gesch¨atzten Parameter n¨aherungsweise bestimmt, und daraus lassen sich wie in der linearen Regression Standardfehler und Vertrauensintervalle herleiten, ebenso Vertrauens-Ellipsen (oder -Ellipsoide), wenn mehrere Parameter gemein- sam betrachtet werden.

Der Nenner n−p in σb2 wurde in der linearen Regression eingef¨uhrt, um die Sch¨atzung erwartungstreu zu machen. Tests und Vertrauensintervalle wurden nicht mit der Normal- und Chiquadrat-Verteilung bestimmt, sondern mit dert- und F-Verteilung. Damit wur- de ber¨ucksichtigt, dass die Sch¨atzung von σ2 eine zus¨atzliche Zufallsschwankung bewirkt.

Auch wenn die Verteilungen nicht mehr exakt gelten, so werden die N¨aherungen doch genauer, wenn man dies bei der nichtlinearen Regression ebenfalls tut. Asymptotisch geht der Unterschied gegen null.

d ⊲ Eine Computer-Ausgabe f¨ur das Beispiel aus der Membrantrenn-Technologie zeigt Tabelle 1.4.d. Die Sch¨atzungen der Parameter stehen in der Kolonne

”Value“, gefolgt von den gesch¨atzten approximativen Standardfehler und den Teststatistiken (

”t value“), die approximativ tn−p-verteilt sind. In der letzten Zeile wird die gesch¨atzte Standardab- weichung σb der Zufallsfehler Ei angegeben.

Parameters:

Value Std. Error t value T1 163.706 0.1262 1297.21 T2 159.784 0.1595 1002.03

T3 2.675 0.3813 7.02

T4 -0.512 0.0703 -7.28

Residual standard error: 0.2931 on 35 degrees of freedom

Tabelle 1.4.d: Computer-Ausgabe f¨ur das Beispiel aus der Membrantrenn-Technologie Aus diesen Angaben k¨onnen wie in der linearen Regression die Vertrauensintervalle f¨ur die Parameter bestimmt werden: Das approximative 95%-Vertrauensintervall f¨ur den Pa- rameter θ1 ist 163.706±q0.975t35 ·0.1262 = 163.706±0.256.

⊳

1.4. GEN ¨AHERTE TESTS UND VERTRAUENSBEREICHE 23 e ⊲ Beispiel Puromycin. Zur ¨Uberpr¨ufung eines Einflusses der Behandlung des Enzyms mit Puromycin von der postulierten Form (1.1.d) kann ein gemeinsames Modell f¨ur die Daten mit und ohne Behandlung folgendermassen formuliert werden:

Yi = (θ1+θ3zi)xi

θ2+θ4zi+xi +Ei .

Dabei ist z die Indikatorenvariable f¨ur die Behandlung (zi = 1, wenn behandelt, sonst

=0).

Parameters:

Value Std. Error t value T1 160.286 6.8964 23.24

T2 0.048 0.0083 5.76

T3 52.398 9.5513 5.49

T4 0.016 0.0114 1.44

Residual standard error: 10.4 on 19 degrees of freedom Tabelle 1.4.e: Computer-Ausgabe f¨ur das Beispiel Puromycin

Tabelle 1.4.e zeigt, dass der Parameter θ4 nicht signifikant von 0 verschieden ist, denn der t-Wert von 1.44 ist kleiner als die kritische Grenze q0.975t19 = 2.09. Die Behandlung hat aber einen eindeutigen Einfluss, der sich durch θ3 ausdr¨uckt; das 95% Vertrauensintervall

¨

uberdeckt 52.398±9.5513·2.09 = [32.4,72.4].

⊳

f Neben den Parametern ist oft der Funktionswert hhx0, θi f¨ur ein beliebiges x0 von In- teresse. In der linearen Regression wird der Funktionswert h

x0, β

= xT0β durch xT0βb gesch¨atzt, und das (1−α)-Vertrauensintervall daf¨ur ist

xT0βb±σb q

xT0(XTX)−1x0qt1−α/2n−p .

Durch analoge ¨Uberlegungen und asymptotische N¨aherung kann man Vertrauensintervalle f¨ur den Funktionswerte hhx0;θi f¨ur nicht lineare h angeben. Wird die Funktion η0hθi :=

hhx0, θi an der Stelle θ linear approximiert, so erh¨alt man η0D

θbE

≈η0hθi +aT0 (bθ−θ) mit a0 = ∂hhx0, θi

∂θ .

(Wenn x0 gleich einem beobachteten xi ist, dann ist a0 gleich der entsprechenden Zeile der Matrix A aus 1.2.g.) Das Vertrauensintervall f¨ur den Funktionswert hhx0, θi ist dann approximativ

hD x0,bθE

±q1−α/2tn−p σbx0 mitσbx0 =σb q

b

aT0(AbTAb)−1ab0.

In dieser Formel wurden wieder die unbekannten Gr¨ossen durch ihre Sch¨atzungen ersetzt.

g Der Ausdruck f¨ur das Vertrauensintervall f¨ur hhx0, θi gilt f¨ur beliebiges x0. Es ist wie in der linearen Regression naheliegend, die Grenzen dieses Intervalls als Funktion von x0 als

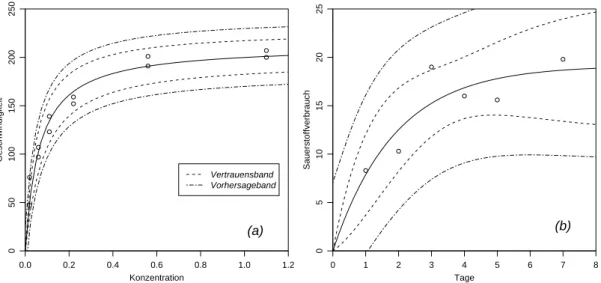

”Vertrauensband“ aufzuzeichnen, wie dies Figur 1.4.g f¨ur die beiden Beispiele Puromycin und Sauerstoffverbrauch zeigt.

0.0 0.2 0.4 0.6 0.8 1.0 1.2

050100150200250

Konzentration

Geschwindigkeit

Vertrauensband Vorhersageband

(a)

0 1 2 3 4 5 6 7 8

0510152025

Tage

Sauerstoffverbrauch

(b)

Abbildung 1.4.g: Vertrauensband f¨ur den Funktionswert h und Vorhersageband, (a) Bei- spiel Puromycin, (b) Beispiel Sauerstoffverbrauch.

Vertrauensb¨ander f¨ur lineare und nichtlineare Regressionsfunktionen verhalten sich ver- schieden: Bei linearen Funktionen ist das Vertrauensband beim Schwerpunkt der Ausgangs- Variablen am engsten und wird gegen aussen allm¨ahlich breiter. Im nichtlinearen Fall k¨on- nen die B¨ander beliebiger sein. Weil die Funktionen in den Beispielen durch den Nullpunkt gehen m¨ussen, schrumpft dort das Intervall zu einem Punkt. Beide Modelle haben eine horizontale Asymptote und deshalb wird das Band f¨ur grosse x eine konstante Breite erreichen.

h Das betrachtete Vertrauensband gibt an, wo die idealen Funktionswerte hhx;θi, al- so die Erwartungswerte von Y bei gegebenen x, liegen. Die Frage, in welchem Bereich k¨unftige Beobachtungen Y0 f¨ur vorgegebenes x0 zu liegen kommen, ist damit nicht beantwortet. Sie ist aber oft interessanter als die Frage nach dem idealen Funktionswert;

man m¨ochte beispielsweise wissen, in welchem Bereich der zu messende Wert des Sauer- stoffverbrauches f¨ur eine Inkubinationszeit von 6 Tagen liegen wird.

Eine solche Angabe ist eine Aussage ¨uber eine Zufallsvariable und ist prinzipiell zu unterscheiden von einem Vertrauensintervall, das ¨uber einenParameter, also eine feste, aber unbekannte Zahl, etwas aussagt. Entsprechend der Fragestellung nennen wir den gesuchten BereichVorhersage-Intervalloder Prognose-Intervall.

Wie im linearen Fall ist dieses Intervall eng mit dem Vertrauensintervall f¨ur den Funktions- wert verkn¨upft; man muss lediglich σbx0 in der obigen Formel durch p

b

σ2+σb2x0 ersetzen.

Die entsprechenden B¨ander sind in Figur 1.4.g ebenfalls eingezeichnet.

![Abbildung 1.2.d: Geometrische Veranschaulichung der nichtlinearen Regression. Die Werte von η h θ i = h h x.; θ 1 , θ 2 i f¨ ur varierende Parameter [θ 1 , θ 2 ] f¨ uhren zu einer zweidimensio-nalen](https://thumb-eu.123doks.com/thumbv2/1library_info/4456724.1588196/17.892.227.657.126.649/abbildung-geometrische-veranschaulichung-nichtlinearen-regression-varierende-parameter-zweidimensio.webp)