Beiträge

Sebastian Vater*, Johannes Pallauf, Marian Hoffmann, Thorsten Stein und Fernando Puente León

Erzeugung präziser Referenzdaten für die 3D-Kopfposenschätzung

Creating precise reference data for 3D head pose estimation

DOI 10.1515/teme-2015-0104

Eingang 12. November 2015; überarbeitet 6. Juli 2016; angenommen 10. Juli 2016

Zusammenfassung: In dieser Arbeit wird eine Metho- de zur Erzeugung von Referenzdaten für die 3D-Kopfpo- senschätzung mit Hilfe eines Vicon MX Motion-Capture- Systems vorgestellt. Im Rahmen der Arbeit wurden jeweils 22 Videos von sechs Probanden mit einer handelsübli- chen RGB-Kamera mit einer Frequenz von30Bildern pro Sekunde aufgenommen. Die Videosequenzen zeigen Sze- narien, welche aus Drehbewegungen des Kopfes um die drei Raumachsen unter verschiedenen Beleuchtungsbe- dingungen bestehen. Die Videos wurden mit einer Auf- lösung von800 × 600Bildpunkten im RGB24-Format auf- genommen, welche eine weitere Bildverarbeitung zur Detektion charakteristischer Merkmale zulässt. Über die Referenzdaten der Kopfposition hinaus wurden Informa- tionen über die Blickrichtung der Probanden aufgezeich- net, indem die Probanden aufgefordert wurden, Punkte bekannter Koordinaten auf einem Bildschirm zu verfolgen.

Dieser Beitrag liefert eine detaillierte Beschreibung des Messaufbaus und der Durchführung. Ziel ist es eine Me- thode vorzustellen, um aus den 3D-Trajektorien der Mar- ker des Motion-Capture-Systems Referenzdaten für den Zustandsvektor des Kopfes zu bestimmen. Darüber hinaus wird ein mit der vorgestellten Methode erzeugter Daten- satz zur Validierung von erscheinungsbasierten Algorith- men zur Kopfposenschäztung bereitgestellt.

*Korrespondenzautor: Sebastian Vater, Karlsruher Institut für Technologie (KIT), Institut für Industrielle Informationstechnik (IIIT), Hertzstraße 16, 76187 Karlsruhe, E-Mail: sebastian.vater@kit.edu Johannes Pallauf, Fernando Puente León: Karlsruher Institut für Technologie (KIT), Institut für Industrielle Informationstechnik (IIIT), Hertzstraße 16, 76187 Karlsruhe

Marian Hoffmann, Thorsten Stein: Karlsruher Institut für Technologie (KIT), BioMotion Center, Institut für Sport und Sportwissenschaft (IfSS), Engler-Bunte-Ring 15, 76131 Karlsruhe

Schlüsselwörter: Referenzdatenbestimmung, Erschei- nungsbasierte 3D-Kopfposenschatzung, Motion-Capture- System.

Abstract: This article presents a method for creating ground truth data for 3D head pose estimation utilizing a Vicon MX motion capture system. In the context of this work22video sequences of six individuals were captured using an off-the-shelf RGB camera with a rate of30frames per second. The sequences consist of scenarios that show head rotations with respect to each rotational axis under- going different lighting conditions. The video data was captured at a resolution of800 × 600pixels in the RGB24 format, allowing for further image processing to detect characteristic features. In addition to the provided 3D head pose data, information about the gaze was recorded by re- questing the user to follow points displayed on a screen.

The article describes the measurement setup as well as the experimental procedure in detail. The goal is to show how the 3D trajectories of the markers of the motion capture system can be transformed into reference data for the state vector of the head. Furthermore, a dataset created with the proposed method is provided that allows a validation of appearance-based head pose estimation algorithms.

Keywords: Ground truth data, appearance-based head pose estimation, motion capture system.

1 Einleitung

Die dreidimensionale Kopfposenschätzung ist Bestandteil zahlreicher Systeme im Rahmen der maschinellen Wahr- nehmung und stellt daher eine wichtige Komponente von Mensch-Maschine-Systemen dar. Sie findet Anwendung in der Gesichtsdetektion sowie Gesichtserkennung, in der Emotionserkennung, der Bildregistrierung und ist insbe- sondere notwendig für eine kopfposeninvariante Blick- richtungsschätzung.

Abbildung 1: Ablaufschema zur kopfposeninvarianten Blickrichtungsschätzung basierend auf 2D-Bilddaten.

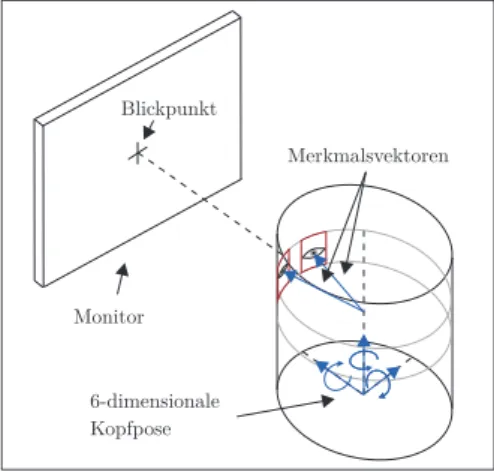

Abbildung 2: Skizze zur Blickrichtungserkennung. Der Kopf wird als Zylinder modelliert. Aus Gründen der Übersichtlichkeit ist das Kopfzentrum am Boden des Zylinders eingezeichnet.

Abbildung1zeigt schematisch einen Ablauf zur Be- stimmung des Blickpunktes basierend auf 2D-Bilddaten.

Nach einer erfolgreichen Detektion des Kopfes ist für die Blickrichtungserkennung eine Bestimmung der Kopf- pose sowie der Irispositionen notwendig. Mit Hilfe dieser beiden Informationen lassen sich Merkmalsvektoren defi- nieren, mit denen sich auf auf die Blickrichtung schließen lässt. Dieser Zusammenhang ist in Abbildung2skizziert.

Die Informationen über die Merkmalsvektoren in Form der Kopfpose sowie der Irispositionen können dann einem Re- gressionsalgorithmus übergeben werden, welcher hieraus auf den Blickpunkt schließt.

Um die Blickrichtungserkennung kopfposeninvariant zu gestalten, ist insbesondere eine zuverlässige und ge- naue Methode zur Bestimmung der Kopfpose notwendig.

Zur Verifizierung der Funktionsweise und der Genauigkeit erforschter Methoden zur Bestimmung der Kopfpose müs- sen hierfür verlässliche Referenzdaten zur Verfügung ste- hen. Dieser Beitrag beschäftigt sich daher mit der Erzeu- gung von Referenzdaten für die dreidimensionale Kopfpo- se für die Anwendung zur Blickrichtungsschätzung. Ziel

dabei ist es, Referenzdaten für den6-dimensionalen Zu- standsvektor des Kopfes im Raum, bestehend aus3Rota- tionen und3Translationen, zeitlich aufgelöst und mit ge- ringer Abweichung bereitzustellen.

Das Erzeugen von Referenzdaten aus Motion-Capture- Daten wurde bereits zur Untersuchung von Algorith- men zur Verfolgung der Gehbewegung von Personen genutzt [13,16,20] und findet Anwendung bei der Evaluie- rung von Algorithmen zum 3D-Körpertracking [4].

Bestehende Datensätze für die Kopfpose wurden häu- fig mit der Zielsetzung erstellt, eine Gesichtsdetektion oder Gesichtserkennung robust gegenüber einer variierenden Kopfposition zu gestalten. Diese Datensätze bestehen aus Einzelbildern mit einer definierten Kopforientierung. Gou- rier et al. [10] bringen visuell zu fixierende Punkte in ei- nem regelmäßigem Muster an einer Wand an und neh- men Bilder aus einer konstanten Kameraposition auf. Sim et al. [21] und Gao et al. [9] verwenden Kamera-Arrays, um Bilder verschiedener Kopfposen zu erhalten. Die Aufnah- merichtungen werden mit22,5∘beziehungsweise45∘dis- kretisiert, wobei die Position des Kopfes mit einer Vorrich- tung gestützt wird und die Blickrichtung der Probanden nicht variiert. Um die Aufnahmerichtung zu variieren, nut- zen Little et al. [12] eine Drehscheibe, auf welcher sich der Proband befindet, und eine statische Kamera. Hier wird die Drehrichtung um die vertikale Achse1∘aufgelöst.

Um die Performanz von Trackingmethoden, welche die Position des Kopfes über einen längeren Zeitraum durch Berechnung kleiner Änderungen der Kopfpose schätzen, zu testen, sind Datenbanken, die aus Einzelbil- dern bestehen [9,10], nicht geeignet.

Kontinuierliche Daten zur Untersuchung der Aufmerk- samkeit von Autofahrern wurden von Murphy-Chutorian et al. [14] durch die Schätzung der Kopforientierung mit Hilfe eines in einem Fahrzeug eingebauten Vicon-Systems aufgenommen. Es wurden allerdings keine Informationen über die extrinsische Kameramatrix aufgezeichnet, sodass keine Auswertung in einem lokalen Kamerakoordinaten- system möglich ist.

Cascia et al. [11] präsentieren einen Datensatz, bei dem Referenzdaten mit Hilfe eines magnetischen „Flock of Birds“-Trackers [1] aufgenommen werden. Der Empfän- ger zeichnet die relative Änderung der Position des Sen- ders bezüglich des Empfängers sowie die Orientierung des Senders auf. Für die Bestimmung von Rotationen wird bei störungsfreier Aufnahme vom Hersteller eine Standardab- weichung von0,5∘und für Translationen eine Standardab- weichung von1,8 mmangegeben [2]. Störungen können durch metallische Gegenstände oder elektromagnetische Signale auftreten. Cascia et al. geben für ihre Untersu- chungen einen Fehler von größer als 0,5∘ for Rotationen

an. Da die Kalibrierungsdaten, welche den initialen Ab- stand zwischen Sender und Empfänger beinhalten, nicht zur Verfügung gestellt werden, lassen sich Translationen nicht auswerten [7]. Ein weiterer Nachteil ist die niedri- ge Auflösung von320 × 240Bildpunkten, die es nicht er- laubt, feine Strukturen – wie etwa die Iris – zu detektieren.

Ba und Odobez [3] sowie Voit [25] nutzen ebenfalls einen magnetischen Sensor zum Aufzeichnen von Referenzda- ten. Bei Ba und Odobez sitzen Probanden an einem Tisch und bei Voit bewegen sich die Personen frei in einer Bü- roumgebung, während der magnetische Sensor die Kopf- pose aufzeichnet.

Zusammenfassend lässt sich sagen, dass vorhandene Datensätze eine unzureichende Auflösung und Genauig- keit bezüglich der Position und Ausrichtung der Kopfpose, unvollständige Informationen über vorhandene Messda- ten oder eine niedrige Bildauflösung der zugehörigen Vi- deosequenzen besitzen. Ziel dieses Beitrags ist es diesen Missstand zu beheben, indem ein Rahmenwerk zur Erzeu- gung präziser Referenzdaten für die 3D-Kopfposition prä- sentiert und ein geeigneter Datensatz zur Validierung von erscheinungsbasierten Algorithmen zur Kopfposenschät- zung bereitgestellt wird.

Um die Anforderungen für Referenzdaten zur Verifi- zierung eines Algorithmus zur Kopfposen- und Blickrich- tungsschätzung zu erfüllen, soll in dieser Arbeit ein Vicon MX Motion-Capture-System [22] als Messumgebung die- nen. Das System besteht aus einem Infrarot(IR)-Kamera- Array und einer Basisstation, welche die von den IR- Kameras gelieferten Daten zu dreidimensionalen Punkte- trajektorien auswertet. Aus diesen Trajektorien können dann zeitlich aufgelöst Referenzdaten für die Kopfpose be- züglich eines lokalen Koordinatensystems bestimmt wer- den. In dieser Arbeit soll bei der Erzeugung von Referenz- daten für die 3D-Kopfpose darüber hinaus der Aspekt be- rücksichtigt werden, dass die 3D-Kopfposenschätzung als Ausgangspunkt für eine Bestimmung der Blickrichtung genutzt werden soll. Um eine präzise und gegenüber der Kopfpose invariante Schätzung der Blickrichung durchzu- führen, sollte gewährleistet sein, dass der aus der Kopfpo- senschätzung resultierende Fehler klein genug ist, um nah beieinander liegende Objekte zuverlässig durch Auswer- tung eines Blickrichtungsvektors unterscheiden zu kön- nen. Neben zugehörigen Videosequenzen mit einer ausrei- chend hohen Auflösung sollen in diesem Beitrag Informa- tionen über die zur Videoaufnahme genutzte RGB-Kamera in Form der extrinsischen und intrinsischen Kamerapara- meter geliefert werden.

Die zur Erzeugung der Referenzdaten und Erstellung der Datenbank durchgeführten Schritte werden in die- sem Beitrag diskutiert. Beginnend mit der Beschreibung

des Messaufbaus in Abschnitt 2 wird anschließend in Abschnitt3die Durchführung der Messung beschrieben.

Basierend auf den aufgenommenen 3D-Trajektorien der Marker wird in Abschnitt 4 die Berechnung der Refe- renzdaten für die Kopfpose im Kamerakoordinatensystem, in welchem die Auswertung der 3D-Kopfposenschätzung durchgeführt wird, beschrieben. Ein abschließender Aus- blick zeigt Möglichkeiten zur Nutzung des Datensatzes auf.

2 Messaufbau

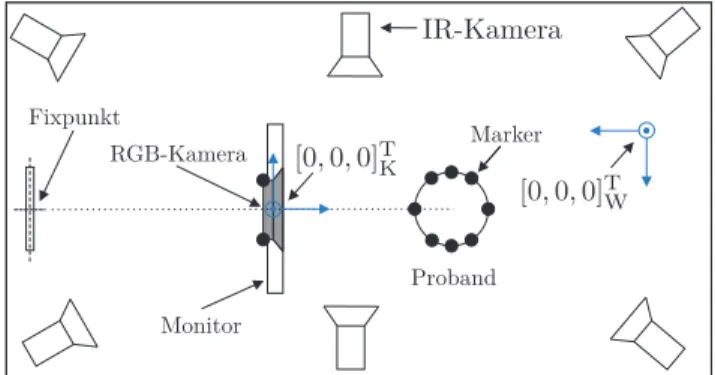

Das verwendete Vicon MX Motion-Capture-System nutzt 6Infrarotkameras, welche aus verschiedenen Positionen auf die Szene gerichtet sind. Ein Proband positioniert sich vor einem Monitor in einem durch die Ausrichtung der IR- Kameras definierten Kontrollvolumen. Oberhalb des Moni- tors ist eine RGB-Kamera angebracht, welche eine Video- sequenz der Szene aufzeichnet. Abbildung3zeigt sche- matisch eine Draufsicht des Messaufbaus.

2.1 Konvention für Koordinatensysteme und Begrifflichkeiten

Der Ursprung[0, 0, 0]TKdes KamerakoordinatensystemsK liegt im Mittelpunkt des Gehäuses der RGB-Kamera, wo- bei dessen𝑧K-Achse in Richtung des Probanden zeigt, sie- he Abbildung4. Die Drehrichtungen𝜔x,𝜔yund𝜔zwer- den im Folgenden mitPitch, Yaw und Roll (Nicken, Gieren und Rollen) bezeichnet. Mit[0, 0, 0]TWsei der Ursprung des Weltkoordinatensystems Wbezeichnet, in welchem die 3D-Markerpositionen durch das Vicon-System aufgezeich- net werden. Der Ursprung des SystemsWwird durch eine am Boden befestigte dreieckige Platte, an deren Eckpunk- ten Marker befestigt sind, definiert.

Abbildung 3: Messaufbau und Szene (Draufsicht).

Abbildung 4:

Koordinatenachsen und Orientierungen im

KamerakoordinatensystemK.

Abbildung 5: Einzelbild aus einer Videosequenz des Datensets mit Markerhalterung.

Das Motion-Capture-System liefert die dreidi- mensionalen Markerpositionen xW = [𝑥W, 𝑦W, 𝑧W]T𝑖, 𝑖 ∈ {1, . . . , 8}. Die Marker sind an einer Markerhalterung befestigt, welche die Probanden während der Messung aufsetzen. Abbildung5zeigt ein Einzelbild aus einem der Referenzvideos mit den Markern.

Die Trajektorien der Markerpunkte inWwerden von der Vicon Nexus Software [24] aus den Daten der IR- Kameras bestimmt, wobei die Güte bezüglich der Positi- onsbestimmung stark von der Kalibrierung des Systems abhängt [22]. Die Kalibrierung erfolgt mit drei auf einen Stab positionierten Markern, deren Abstand zueinander bekannt ist. Der Stab dient dem System bei der Kalibrie- rung als Bezugsgröße. Während der Kalibrierung wird der Kalibrierstab manuell durch den Kontrollraum bewegt, wobei der Raum durch die Bewegungen des Kalibrierstabs vollständig abgedeckt werden sollte.

2.2 Abschätzung der Genauigkeit

In der Literatur existieren Untersuchungen zur Genau- igkeit von Vicon 370 und Vicon MX Motion-Capture-

Systemen. Dabei wird die Positionsbestimmung von Mar- kern zueinander, die sich in einem bekannten, festen Abstand auf sich bewegenden, starren Körper befinden, untersucht [5,6,18]. Allerdings lässt sich hierdurch kei- ne direkte Aussage der Genauigkeit des Systems bezüglich der Trajektorienbestimmung von Markern in einen zuvor definierten Weltkoordinatensystem formulieren. Aus die- sem Grund soll in diesem Abschnitt die erreichbare Genau- igkeit für die Bestimmung von Markertrajektorien ausge- hend von den aus der Kalibrierung resultierenden Unge- nauigkeiten des Vicon MX Systems erörtert werden.

Bei den durchgeführten Untersuchungen liegen die nach der Kalibrierung vorliegenden Abweichungen der einzelnen IR-Kameras bezüglich der Bestimmung der Mar- kerpositionen bei|𝜖IR| ≤ 0,22 mm. Hierbei wird𝜖IR vom Hersteller als mittlerer quadratischer Pixelfehler zwischen den 2D-Markerpositionen im Sensorsignal und den aus der 3D-Rekonstruktion zurückprojizierten Markerpositio- nen angegeben [22]. Um die Eignung des hier verwen- deten Motion-Capture-Systems zur Erzeugung von Refe- renzdaten zur Kopfposenschätzung zu zeigen, wird eine Worst-case-Beispielrechung zur Genauigkeit des Systems durchgeführt, welche zeigen soll, dass nach einer erfolg- reichen Kalibrierung mit der vorgeschlagenen Methode ei- ne Winkelabweichung von weniger als0,11∘erreicht wer- den kann.

Für Elemente auf einem Monitor mit einer Anzeige- breite von518,4 mmsowie1920Bildpunkten in horizon- taler Richtung (94,34 ppi) ergibt sich für einen zulässigen Fehler von 25 Bildpunkten ein maximaler Winkelfehler vonΔ𝜔y= 0,5∘. Hierbei wird bei der Schätzung der Kopf- pose ein Abstand der Person zum Monitor von80 cmver- wendet. Ein Wert von0,5∘liegt in der Größenordnung ma- gnetischer „Flock of Birds“-Tracker [11].

Um Referenzdaten mit einem Fehler kleiner als0,5∘zu erhalten, muss also für die euklidische Norm des Fehlers der Marker

𝜖 = √Δ𝑦W2 + Δ𝑥2W+ Δ𝑧2W, (1) wobeiΔ𝑦W, Δ𝑥W,Δ𝑧W die Ungenauigkeiten der Positi- onsbestimmung des Motion-Capture-Systems sind, gelten:

𝜖 𝑑M

< tan(𝛼) = tan (0,5∘ 𝜋

180∘) . (2) Mit𝑑Mist hier der euklidische Abstand zweier Marker be- zeichnet, siehe Abbildung6.

Bezüglich des Drehwinkels 𝛼 um eine gemeinsame Drehachse beider Marker bildet𝜖die Gegenkathete zu𝛼. Der Abstand der Marker ist durch deren feste Anord- nung an der Markerhalterung gegeben und ergibt sich zu

Abbildung 6: Skizze zur Abschätzung des Fehlers der Markerpositionen.

𝑑M, min≈ 50 mm. Hierbei ist zu beachten, dass der durch eine fehlerbehaftete Bestimmung der Markerposition re- sultierende Winkelfehler für die Kopfpose für einen klei- ner werdenden Abstand zwischen den zwei betrachteten Markern zunimmt.

Aus Gleichung (2) ergibt sich: |𝜖| < 0,45 mm. Mit

|𝜖IR| ≤ 0,22 mmist das verwendete System somit fähig, zu- verlässige Messdaten zu liefern.

Unter der Annahme, dass der Abstand eines Nutzers zum Monitor gewöhnlich kleiner als80 cmist, der durch das Motion-Capture-System verursachte Fehler in dieser Arbeit im arithmetischen Mittel bei| ̄𝜖IR| = 0,16 mmund der mittlere Abstand der Marker bei𝑑M̄ = 84 mmliegt, er- gibt sich mit Gleichung (2) eine Winkelabweichung von 0,11∘, was einem Fehler von weniger als5Bildpunkten auf dem Monitor entspricht. Ein Fehler von0,11∘liegt deutlich unter dem mit einem magnetischen Tracker erreichbaren Fehler [23].

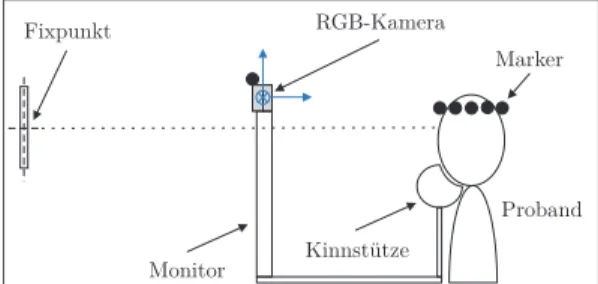

3 Experimentelle Durchführung

Um bei der Erstellung der Referenzdaten zuverlässige Wer- te für die Translation des Kopfes bestimmen zu können, muss die relative Position zwischen Markerpositionen und Kopf bekannt sein. Hierzu werden Kopf und Markerhalte- rung zueinander ausgerichtet, indem der Proband gera- deaus auf einen Fixpunkt schaut und die durch die acht Marker definierte Ebene der Markerhalterung parallel zur Nullebene vonWausgerichtet wird. Eine Kinnstütze sorgt für eine reproduzierbare Position der Kopfes. Abbildung7 zeigt den Aufbau schematisch in der Seitenansicht.

Bei der Durchführung wurde die Aufnahme der Mar- kerpositionen durch das Motion-Capture-System zuerst gestartet. Nach Start der Videoaufnahme durch die RGB- Kamera wird durch einen in der Videosequenz sichtbaren Trigger eines Lichtschrankensignals ein Zeitstempel in der Bildsequenz gesetzt. Das Lichtschrankensignal erzeugt einen Zeitstempel im Referenzsystem, mit welchem der Anfang des Videos mit dem Signal des Motion-Capture- Systems synchronisiert wird.

Abbildung 7: Messaufbau und Szene (Seitenansicht).

3.1 Zusammensetzung der Messdaten

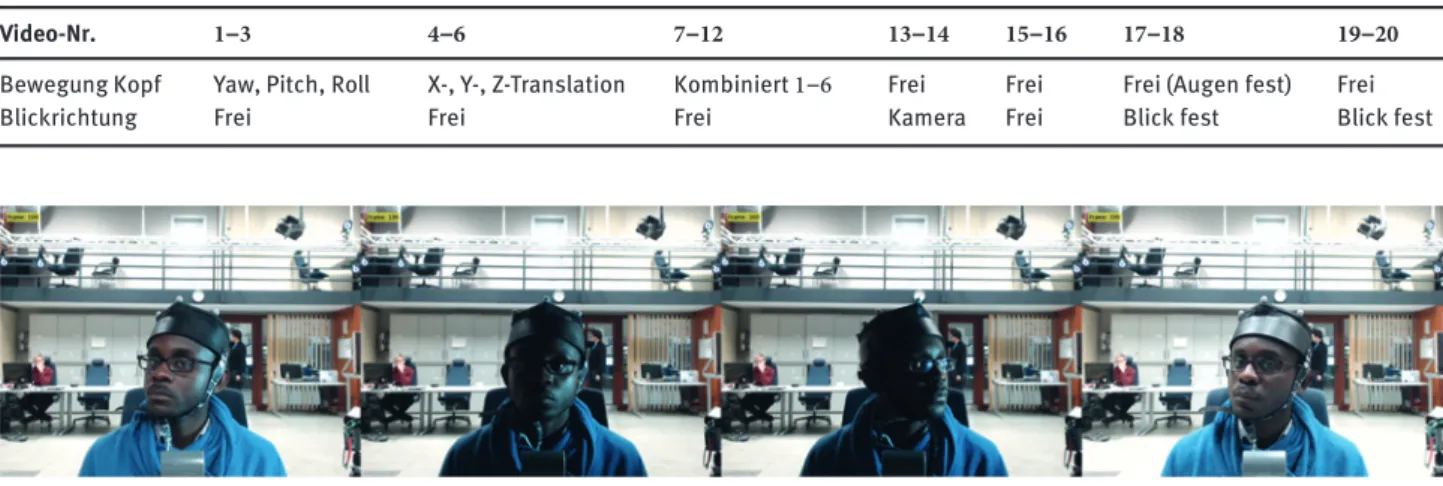

Da mit den aufgenommenen Daten erscheinungsbasier- te Algorithmen zur Schätzung der 3D-Kopfpose getestet werden sollen, wurde auf eine möglichst große Varianz bezüglich des Erscheinungsbilds sowie besonderer Merk- male der Probanden geachtet. Hierzu wurden im Rahmen dieser Arbeit Messdaten für insgesamt sechs Probanden aufgenommen. Die Sequenzen beinhalten Videos von Per- sonen verschiedener Ethnien (europäisch, asiatisch, afri- kanisch), Personen mit Brille sowie mit Barthaar. Die Vi- deos wurden im RGB24-Format mit einer Bildwiederhol- rate von30Bildern pro Sekunde aufgezeichnet. Für jede der Personen wurde eine definierte Messreihe mit20Mes- sungen durchgeführt für die jeweils der Parametervektor der Kopfpose p= [𝜔𝑥, 𝜔𝑦, 𝜔𝑧, 𝑡𝑥, 𝑡𝑦, 𝑡𝑧]Terzeugt wird. Die Zusammensetzung der Messreihe ist in Tabelle1gegeben.

Darüber hinaus wurden jeweils zwei weitere Videosequen- zen mit freien Kopfbewegungen aufgezeichnet, in denen sich die Beleuchtungsverhältnisse während der Aufnah- me ändern. In Abbildung8sind beispielhaft vier Frames einer Videosequenz mit veränderlichen Beleuchtungsbe- dingungen zu sehen.

Die einzelnen Szenarien können zur Validierung un- terschiedlicher Teilaspekte der 3D-Kopfposenschätzung herangezogen werden. Während mit den Szenarien 1–6 die Genauigkeit eines Algorithmus bezüglich genau defi- nierter Bewegungen getestet werden kann, dienen die frei- en Bewegungsszenarien, um allgemein die Robustheit zu testen. Durch Aufnahme von Videos, bei denen die Pro- banden aufgefordert werden, ein definiertes Muster auf dem Bildschirm zu verfolgen, kann die monokulare Blick- richtungsschätzung untersucht werden. Hierzu werden durch die Videos17–18Informationen über die Blickrich- tung sowohl allein aus der Kopfposenschätzung mit kon- stanter Position der Augen als auch durch Fusion mit einer Bewegung der Iris bereitgestellt (Videos19–20). Die Pro- banden wurden dabei in den Videos17–18aufgefordert, die Blickrichtung ausschließlich über die Kopfpose zu ver- ändern und die Irisposition konstant zu lassen. Darüber

Tabelle 1: Messprotokoll.

Video-Nr. 1–3 4–6 7–12 13–14 15–16 17–18 19–20

Bewegung Kopf Yaw, Pitch, Roll X-, Y-, Z-Translation Kombiniert1–6 Frei Frei Frei (Augen fest) Frei

Blickrichtung Frei Frei Frei Kamera Frei Blick fest Blick fest

Abbildung 8: Ausschnitte aus einer Sequenz des Datensatzes mit veränderlichen Beleuchtungsbedingungen.

hinaus verfolgen die Probanden in den Videos19–20ein vorgegebenes Muster durch eine kombinierte Bewegung von Kopf und Pupillen, sodass mit Hilfe der Referenzdaten die monokulare Blickrichtungsschätzung durch Algorith- men, die Kopfpose und Irisposition bestimmen, geschätzt werden kann.

Die Sequenzen mit veränderlichen Beleuchtungsbe- dingungen können herangezogen werden, um die Ro- bustheit eines Algorithmus gegenüber Veränderungen der Erscheinung des zu verfolgenden Objektes zu testen.

Nach Beendigung der Messung können die Rotations- und Translationsparameter der Kopfpose aus den Trajek- torien der Markerpositionen inWerzeugt werden.

4 Erzeugung der Referenzdaten

Im Folgenden soll gezeigt werden, wie aus den aufgenom- menen Messdaten Referenzdaten für die Kopfpose sowie die Blickrichtung erstellt werden können. Um eine Nut- zung der erzeugten Daten unabhängig von der hier genutz- ten Kamera und damit offline, ohne Kalibrierung, möglich zu machen, sollen hierbei die verwendeten und im Daten- satz enthaltenen intrinsichen und extrinsischen Kamera- parameter diskutiert werden.

4.1 Kopfpose

Da die Rotationen und Translationen des Kopfes mit dem verwendeten Motion-Capture-System nicht direkt gemes- sen werden können, wird in diesem Abschnitt eine Metho- de zur Bestimmung der Referenzdaten der Kopfpose für die Nutzung zusammen mit einem erscheinungsbasierten

Ansatz zur Kopfposenschätzung vorgestellt. Hierzu muss zunächst eine Koordinatentransformation der Marker- trajektorien ins Kamerakoordinatensystem durchgeführt werden. Anschließend wird im Kamerakoordinatensystem die Position und Orientierung des Kopfes aus den Marker- daten berechnet. Die 3D-Punkte der Referenzdaten kön- nen dann durch Anwendung der Zentralprojektion un- ter Verwendung der intrinsischen Kameraparameter in die Bildebene überführt werden.

4.2 Extrinische Kameraparameter

Um die Nutzung der Referenzdaten zur Kopfposenschät- zung für beliebige Kamerasysteme vergleichbar zu ma- chen, müssen die im Weltkoordinatensystem Waufge- nommenen Trajektorien zunächst in das Kamerakoordi- natensystemKtransformiert werden. Die Transformation vonWnachKwird durch die extrinsische Kameramatrix KExbeschrieben. Zur Ermittlung vonKExmüssen die Ver- schiebung und die Orientierung der Achsen beider Koordi- natensysteme bestimmt werden. Hierzu werden die Koor- dinaten der am Gehäuse der Kamera angebrachten Marker genutzt. Vor der Aufnahme der Videosequenzen wurden die vertikalen Achsen beider Koordinatensysteme paral- lel zueinander ausgerichtet. Mittels der Markerpositionen der Kameramarker lassen sich dann die translatorischen Verschiebungen tWKx , tWKy und tWKz vom Welt- ins Kame- rakoordinatensystem bestimmen. Die Verdrehung der ver- tikalen Achsen beider Koordinatensystem lässt sich dann aus

𝜙WKzW = arctan (Δ𝑥W,Kamera

Δ𝑦W,Kamera

) berechnen.

Die inWvorliegenden Punkte lassen sich dann in ho- mogenen Koordinaten[xWT, 1]Tmit den beiden Transfor- mationen

TWK = (

1 0 0 0

0 1 0 0

0 0 1 0

tWKx tWKy tWKz 1 )

und

RWK = (

cos (𝜙zWKW ) 0 − sin (𝜙WKzW ) 0

0 1 0 0

sin (𝜙WKzW ) 0 cos (𝜙zWKW ) 0

0 0 0 1

)

ins Kamerakoordinatensystem überführen:

xTK =xTW⋅ (−TWK) ⋅RWK.

Damit liegen Referenzdaten für die Translation und die Ro- tation des Kopfes inKvor und es kann die Kopfpose be- stimmt werden.

4.3 Bestimmung des Kopfposenvektors

Durch die Bestimmung der Orientierung der aus den acht Markern der Markerhalterung bestimmten Ebene im ge- wählten Koordinatensystem lassen sich die gesuchten Drehwinkel berechnen, während sich die Verschiebungen aus den 3D-Koordinaten der Markerpunkte direkt ergeben.

Dabei werden die Markerpositionen im Raum durch Trans- formation an eine bekannte Referenzposition von Punk- ten angepasst. Als Referenzposition werden hier die Aus- gangsposition der Marker [𝑥0K, 𝑦K0, 𝑧0K]T𝑖 zum Abtastzeit- punkt𝑛 = 0inKgewählt.

Die Berechnung der Orientierung und Translation der Marker wird als Starrkörperbewegung modelliert [8].

Durch Verwenden aller acht Markerpunkte zur Berech- nung der Starrkörperbewegung sollen fertigungsbedingte Fehler bezüglich der Markerhalterung sowie Ungenauig- keiten des Vicon-Systems minimiert werden. Mit Hilfe der auf den Ursprung transformierten jeweils acht Punkte x𝑛K,c und x0K,czum Abtastzeitpunkt𝑛bzw. 0 wird die Korrelati- onsmatrix

H=∑8

𝑖

[x𝑛K,c(x0K,c)T]

𝑖 (3)

definiert. Die3 × 3-DrehmatrixR𝑛kann dann durch Singu- lärwertzerlegung von H

[U,𝛬,VT] =SVD{H} , (4)

wobei SVD{⋅}den Operator der Singulärwertzerlegung dar- stellt, bestimmt werden:

R𝑛=VUT. (5) Der Zustandsvektor kann nun bestimmt werden: Die Dreh- winkel ergeben sich aus den ElementenR𝑛(𝑘,𝑙)der Drehma- trixR𝑛[15]

𝜔x = tan−1(RR𝑛(3,2)𝑛

(3,3)) , 𝜔y = tan−1(RR𝑛(2,1)𝑛

(1,1)) , (6)

𝜔z= tan−1( −R𝑛(3,1)

√(R𝑛(1,1))2+(R𝑛(2,1))2) (7)

und die Verschiebungsvektoren ergeben sich zu (tx

ty

tz) = −R𝑛(𝑥0K,c 𝑦0K,c

𝑧K,c0 ) + (𝑥𝑛K,c 𝑦K,c𝑛

𝑧K,c𝑛 ) . (8)

4.4 Intrinsische Kameraparameter

Ein Algorithmus zur Schätzung der Kopfpose, welcher auf der Berechnung des optischen Flusses basiert, nutzt ei- ne 2D-Bildsequenz als Eingangsdaten. Hierfür kann eine handelsübliche Webcam als Sensor dienen. Durch Einfüh- ren eines 3D-Modells für das zu verfolgende Objekt können durch Projektion die 3D-Punkte in die Bildebene überführt werden. Dies wird durch Anwendung der Zentralprojekti- on unter Verwendung der intrinsischen Kameraparameter erreicht. Die intrinsischen Kameraparameter umfassen die Brennweite𝑓, die Skalierungsfaktoren𝑆x,𝑆yzur Korrektur nicht quadratischer Pixel auf dem Sensor sowie den Off- set zwischen der optischen Achse des Sensors und dem Bildkoordinatensystem𝑂x und𝑂y. Diese liegen nach ei- nem Kalibriervorgang der RGB-Kamera in Form der intrin- sischen Kameramatrix

KIn= (f𝑆x 0 𝑂x

0 f𝑆y 𝑂y

0 0 1) (9)

vor. Die dreidimensionalen Punkte des Kopfmodells wer- den dann im Kamerakoordinatensystem realisiert, indem ein Zylinder als 3D-Punktewolke initialisiert wird. Mit Hil- fe von KIn werden diese dreidimensionalen Punkte xK dann in das Pixelkoordinatensystem transformiert:

(𝑢 𝑣

1) =KIn(1 0 0 0 0 1 0 0 0 0 1 0) (

𝑥K

𝑦K

𝑧K

1 )

Hierbei stellt[𝑢, 𝑣, 1]Teinen Pixel in homogenen Bildko- ordinaten dar.

Abbildung 9: Feste Punkte dargestellt auf dem Monitor zur Aufnahme von Referenzdaten für die Blickrichtung.

4.5 Blickrichtung

Um bei einem wie in Abbildung1 gezeigten Verfahren die Auswirkungen auf die Genauigkeit der Blickrichtungs- schätzung abhängig von der Kopfposenschätzung sowie von der Irislokalisierung zu überprüfen, wurden drei ver- schiedene Experimente durchgeführt, um Referenzdaten zu erzeugen. Das erste Experiment (Videos17und18) soll die Möglichkeit zur Untersuchung des Einflusses allein der Kopfposenschätzung auf eine Bestimmung der Blickrich- tung bereitstellen. Hierzu wurden die Probanden aufge- fordert das in Abbildung9vorgegebene Muster, bestehend aus den auf dem Monitor dargestellten Punkten1–5aus- schließlich durch Bewegung des Kopfes zu verfolgen, wäh- rend die Position der Augen starr gehalten wird. Für die Dauer der Fixierung der Punkte wurden dann die bekann- ten Monitorkoordinaten über den Frames aufgezeichnet.

Die entsprechenden Frames, die die Fixierung eines Punk- tes referenzieren, wurden dabei manuell durch Auswerten der Videos ermittelt. Durch Kenntnis der Kopfpose und der Monitorkoordinaten können dann einige Videos als Trai- ningsdaten für ein Kalibrierungsmodell ähnlich wie in [17]

genutzt werden:

𝑝xm,𝑖= ∑

𝑗

𝑎𝑗𝑝𝑗,𝑖, 𝑝ym,𝑖= ∑

𝑗

𝑏𝑗𝑝𝑗,𝑖. (10)

Dabei sind𝑝m𝑖 die aufgezeichneten Monitorkoordinaten über𝑖Frames, die zum Training dienen sollen,𝑎𝑗,𝑏𝑗,𝑗 = 1, . . ., 6, die Parameter des Modells und𝑝𝑗∈p die Elemen- te des Kopfposenvektors. Mittels der Methode der kleins- ten Fehlerquadrate kann dann das Gleichungssystem

Pm= 𝛷b,

gelöst werden, wobei Pm der 𝑖 × 2-dimensionale Schätz- vektor mit den Monitorkoordinaten[𝑝mx, 𝑝my]𝑖, b eine6 × 2 Matrix, die die zu schätzenden Parameter des Modells beinhaltet und𝛷die𝑖 × 6Beobachtungsmatrix der Kopf- pose ist. Die übrigen Videos können dann zur Auswertung

herangezogen werden, wobei unter Verwendung der zuvor bestimmten Matrix b der fixierte Monitorpunkt geschätzt werden kann.

Zur Auswertung der Videos 19 und 20 kann ähn- lich vorgegangen werden. Da hier die Blickrichtung durch die Kopfposition sowie die Positionen der Iriden be- stimmt wird, muss für ein lineares Schätzodell wie in Glei- chung10 eine 10 × 2 Matrix b geschätzt werden, da in der Beobachtungsmatrix für jedes Frame 𝑖 nun zusätz- lich zum6-dimensionalen Kopfposenvektor die jeweils 2D- Koordinaten der Pupillenmittelpunkte enthalten sind.

Eine weitere Möglichkeit einen erscheinungsbasier- ten Algorithmus zur Blickrichtungsschätzung auszuwer- ten bieten Video13und14, bei denen die Probanden auf- gefordert waren den Blick fest auf die Kamera zu richten, während Kopfposition und Position der Pupillen relativ zum Kopf bewegt werden.

5 Zusammenfassung

Dieser Beitrag stellt eine Methode zur Erzeugung von Re- ferenzdaten für 3D-Kopfposen aus gegebenen Markertra- jektorien aus einem Motion-Capture-System vor. Hierbei werden die mathematischen Zusammenhänge zwischen dem Koordinatensystem der Aufnahme und dem Koordi- natensystem der Auswertung beschrieben und die ent- sprechenden Transformationen bereitgestellt. Die Daten für die 3D-Kopfpose werden in einem Kamerakoordina- tensystem, zusammen mit den extrinsischen und intrinsi- schen Kameraparametern, zur Verfügung gestellt, sodass eine Auswertung in einem beliebigen System durchgeführt werden kann. Darüber hinaus präsentiert der Beitrag eine Methode zur Nutzung der erstellten Referenzdaten für ei- ne Auswertung eines Algorithmus zur erscheinungsbasier- ten, kopfposeninvarianten Blickrichtungsschätzung.

Aufgrund der erreichbaren Genauigkeit für die Refe- renzdaten mit dem verwendeten System ist die vorgestell- te Methode zur Erstellung präziser Referenzdaten für er- scheinungsbasierte und insbesondere auf der Berechnung des optischen Flusses basierende Algorithmen zur Kopf- posenschätzung, deren Genauigkeit für die Bestimmung der Kopfrotationen üblicherweise im Bereich mehrerer Grad sind [11], gut geeignet. Die Videosequenzen mit einer ausreichend hohen Auflösung von 800 × 600 Bildpunk- ten sollen Forschern eine weitere bildgestützte Auswer- tung, um beispielsweise Informationen über die Irisposi- tion zu extrahieren, ermöglichen. Um die Daten auch zur Validierung eines Algorithmus zur Blickrichtungsschät- zung nutzen zu können, wurden Videosequenzen erstellt,

für welche die Blickrichtung der Probanden aufgezeichnet wurde.

Durch Kenntnis der Kameraparameter ist für eine wei- tere Anwendung keine Kalibrierung notwendig. Mit Hil- fe der vorgestellten Methode sowie der erzeugten Refe- renzdaten können Forscher auf Grundlage des unter [19]

veröffentlichten Datensatzes ihre Ergebnisse der Kopfpo- senschätzung der Rotationen sowie der Translationen oh- ne Einflüsse von Kamera- oder Kalibrierungsparametern vergleichen. Damit soll dieser Beitrag Forschern als An- regung zum wissenschaftlichen Austausch bei der Eva- luierung von erscheinungsbasierten Algorithmen zur 3D- Kopfposenschätzung und zur Ermittlung der Blickrich- tung dienen.

Literatur

1. Ascension Technology Corporation. Flock of Birds-Tracker, zu- letzt zugegriffen April 2015.http://www.ascension-tech.com/.

2. Ascension Technology Corporation. Flock of Birds-Tracker, zuletzt zugegriffen Oktober 2015.

http://www.razor3d.co.kr/pds/ascension/flockofbirds.pdf.

3. S. O. Ba und J.-M. Odobez. Evaluation of multiple cue head pose estimation algorithms in natural environements. In Proc.

IEEE International Conference on Multimedia and Expo, Seite 1330–1333. IEEE, 2005.

4. K. Back, P. Hernández Mesa, M. Diebold und F. Puente León.

Dreidimensionales Körper-Tracking mit Hilfe eines evolutio- nären Algorithmus. tm – Technisches Messen, 80(10):335–342, 2013.

5. S. Barker, R. Craik, W. Freedman, N. Herrmann und H. Hillstrom.

Accuracy, reliability, and validity of a spatiotemporal gait analysis system. Medical engineering&physics, 28(5):460–

467, 2006.

6. B. Carse, B. Meadows, R. Bowers und P. Rowe. Affordable cli- nical gait analysis: An assessment of the marker tracking ac- curacy of a new low-cost optical 3D motion analysis system.

Physiotherapy, 99(4):347–351, 2013.

7. Z.-W. Chen, C.-C. Chiang und Z.-T. Hsieh. Extending 3D Lucas- Kanade tracking with adaptive templates for head pose estima- tion. Machine Vision and Applications, 21(6):889–903, 2010.

8. D. W. Eggert, A. Lorusso und R. B. Fisher. Estimating 3-D rigid body transformations: a comparison of four major algorithms.

Machine Vision and Applications, 9(5–6):272–290, 1997.

9. W. Gao, B. Cao, S. Shan, X. Chen, D. Zhou, X. Zhang und D. Zhao. The CAS-PEAL large-scale chinese face database and baseline evaluations. IEEE Transactions on Systems, Man and Cybernetics, Part A: Systems and Humans, 38(1):149–161, 2008.

10. N. Gourier, D. Hall und J. L. Crowley. Estimating face orienta- tion from robust detection of salient facial structures. FG Net Workshop on Visual Observation of Deictic Gestures, Seite 1–9, 2004.

11. M. La Cascia, S. Sclaroff und V. Athitsos. Fast, reliable head tracking under varying illumination: An approach based on registration of texture-mapped 3D models. IEEE Transactions on Pattern Analysis and Machine Intelligence, 22(4):322–336, 2000.

12. D. Little, S. Krishna, J. Black und S. Panchanathan. A methodo- logy for evaluating robustness of face recognition algorithms with respect to variations in pose angle and illumination angle.

IEEE International Conference on Acoustics, Speech and Signal Processing, Seite 89–92, 2005.

13. Carnegie Mellon University. Carnegie Mellon University (CMU) human motion capture database, zuletzt zugegriffen Oktober 2015.http://mocap.cs.cmu.edu/.

14. E. Murphy-Chutorian, A. Doshi und M. M. Trivedi. Head pose estimation for driver assistance systems: A robust algorithm and experimental evaluation. In Proc. 2007 IEEE Intelligent Transportation Systems Conference, Seite 709–714. IEEE, 2007.

15. R. M. Murray, Z. Li und S. S. Sastry. A mathematical introducti- on to robotic manipulation. CRC press, 1994.

16. J. Pallauf und F. Puente León. Richtungssensitive Fußgänger- Verfolgung durch Klassifikation von Bildmerkmalen. tm – Tech- nisches Messen, 82(5):242–250, 2015.

17. N. Ramanauskas. Calibration of video-oculographical eye- tracking system. Electronics and Electrical Engineering, 8(72):65–68, 2006.

18. J. G. Richards. The measurement of human motion: a compa- rison of commercially available systems. Human Movement Science, 18(5):589–602, 1999.

19. S. Vater, J. Pallauf, M. Hoffmann, T. Stein und F. Puente León.

IIIT Motion Capture Head Pose Dataset.http://www.iiit.kit.

edu/datasets.php.

20. L. Sigal, A. O. Balan und M. J. Black. HumanEva: Synchronized video and motion capture dataset and baseline algorithm for evaluation of articulated human motion. Int. J. Computer Visi- on, 87(1–2):4–27, 2010.

21. T. Sim, S. Baker und M. Bsat. The CMU pose, illumination, and expression database. IEEE Transactions on Pattern Analysis and Machine Intelligence, 25(12):1615–1618, 2003.

22. Vicon Motion Systems Ltd. UK. Vicon MX System System Refe- rence. Revision 1.4.

23. Vicon Motion Systems Ltd. UK. Vicon MX System, zuletzt zuge- griffen Oktober 2015.http://www.vicon.com.

24. Vicon Motion Systems Ltd. UK. Vicon Nexus, zuletzt zugegriffen Oktober 2015.http://www.vicon.com/products/software/

nexus.

25. M. Voit. Multimodale Bestimmung des visuellen Aufmerksam- keitsfokus von Personen am Beispiel aufmerksamer Umgebun- gen. Karlsruher Institut für Technologie (KIT), Dissertation, 2011.

Autoreninformationen

Dipl.-Ing. Sebastian Vater

Karlsruher Institut für Technologie (KIT), Institut für Industrielle Informationstechnik (IIIT),

Hertzstraße 16, 76187 Karlsruhe, Tel.:+49-721-608-44518 sebastian.vater@kit.edu

Sebastian Vater hat am Karlsruher Institut für Technologie (KIT) Maschinenbau studiert und ist seit Abschluss des Studiums als wissenschaftlicher Mitarbeiter am Institut für Industrielle Informa- tionstechnik tätig. Hauptarbeitsgebiete: Bildverarbeitung, Mensch- Maschine-Interaktion, Objektverfolgung und Signalverarbeitung.

Dipl.-Ing. Johannes Pallauf

Karlsruher Institut für Technologie (KIT), Institut für Industrielle Informationstechnik (IIIT),

Hertzstraße 16, 76187 Karlsruhe, Tel.:+49-721-608-44622 johannes.pallauf@kit.edu

Johannes Pallauf hat an der Technischen Universität München (TUM) Elektro- und Informationstechnik studiert und ist seit Ab- schluss des Studiums als wissenschaftlicher Mitarbeiter am Institut für Industrielle Informationstechnik tätig. Hauptarbeitsgebiete:

Informationsfusion, Multi-Objekt-Filterung, Bildverarbeitung und Messtechnik.

Marian Hoffmann

Karlsruher Institut für Technologie (KIT), BioMotion Center, Institut für Sport und Sportwissenschaft (IfSS),

Engler-Bunte-Ring 15, 76131 Karlsruhe, Tel.:+49-721-608-47485

marian.hoffmann@kit.edu

Marian Hoffmann hat am Karlsruher Institut für Technologie (KIT) die Fächer Sportwissenschaft, Mathematik und Physik für das Lehr- amt an Gymnasien studiert und ist seit Abschluss des Studiums als wissenschaftlicher Mitarbeiter am BioMotion Center des Instituts für Sport und Sportwissenschaft (IfSS) tätig. Hauptarbeitsgebiete:

Diagnose und Optimierung sportlicher Leistung, Biomechanik menschlicher Bewegungen.

Jun.-Prof. Dr. rer. nat. Thorsten Stein Karlsruher Institut für Technologie (KIT), BioMotion Center, Institut für Sport und Sportwissenschaft (IfSS),

Engler-Bunte-Ring 15, 76131 Karlsruhe, Tel.:+49-721-608-46654

thorsten.stein@kit.edu

Thorsten Stein leitet das BioMotion Center am Institut für Sport und Sportwissenschaft (IfSS) am Karlsruher Institut für Technologie (KIT). Hauptarbeitsgebiete: Motorische Kontrolle und motorisches Lernen, Biomechanik menschlicher Bewegungen, Diagnose und Optimierung sportlicher Leistung.

Prof. Dr.-Ing. Fernando Puente León Karlsruher Institut für Technologie (KIT), Institut für Industrielle Informationstechnik (IIIT),

Hertzstraße 16, 76187 Karlsruhe, Tel.:+49-721-608-44521

Fernando Puente León leitet das Institut für Industrielle Informa- tionstechnik (IIIT) am Karlsruher Institut für Technologie (KIT).

Hauptarbeitsgebiete: Mess- und Automatisierungstechnik, Signal- verarbeitung, automatische Sichtprüfung und Bildverarbeitung, Mustererkennung und Informationsfusion.