In: M. Klinger, A. Schüler-Meyer, L. Wessel (Hrsg.), Hanse-Kolloquium zur Hochschuldi- daktik der Mathematik 2018 (pp. 63-74). Münster: WTM, 2019.

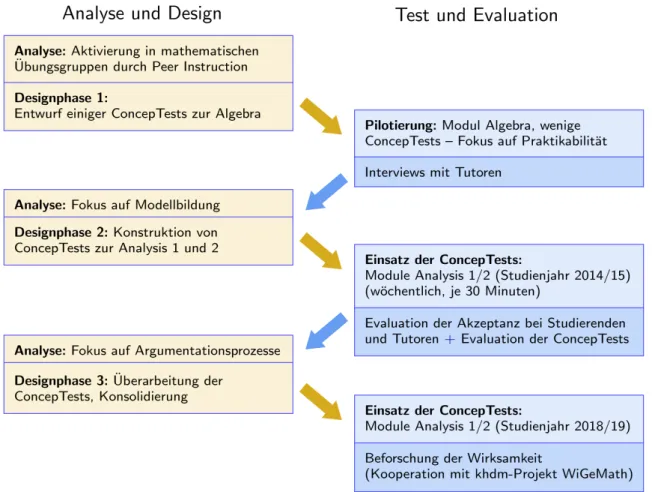

Design von Aufgaben für Peer Instruction zum Einsatz in Übungsgruppen zur Analysis

Bauer, Thomas

11

Volltext

1

Abbildung

ÄHNLICHE DOKUMENTE

Wurde Wohngeld gewährt, so richtete sich der erzielbare Betrag nach der berücksichtigungsfähigen Miete, dem Familieneinkom- men und der Zahl der Familienmitglieder (§§ 2, 7 i.V.m.

Auch Projekte der deutschen Entwicklungszusammenarbeit, insbesondere im Bereich der Regierungsführung (Governance), berücksichtigen den loka- len Kontext oftmals nicht

Participation has become one of the most important buzzwords in the international development discourse since at least the middle of the 1990s.

Dies zeigt auch eine vom Deutschen Institut für Entwicklungspolitik (DIE) und Bonn International Center for Conversion (BICC) durchgeführte Forschung zur lokalen

Um eine SDG-sensitive Kooperation zu gewähr- leisten, soll nicht nur die Vergabe von öffentlichen Entwick- lungsgeldern (Official Development Assistance, ODA) an die Anforderungen

Doch auch hier muss man sagen, dass 800 Millionen € in den vergangenen Jahren zwar ein schöner Erfolg sind, angesichts der Summen, über die wir hier sprechen wird aber schnell

) und einigen fabrizierten Mülls (Bitte neu formulieren. Klingt ned postiv, was magst du damit eigl. dem Leser damit sagen?), war es doch ein ge- lungener Abend.. Dass

Da die Folien nur Wort für Wort Vorgelesen werden und es dieses Semester ohne hin schon mehr als genug zu tun gibt, kann ich mich freitagsfrühs auch mit meinem Kaffee vor den Pc