Quantitatives Risikomanagement

Korrelation und Abhängigkeit im Risikomanagement:

Eigenschaften und Irrtümer

von

Jan Hahne und Wolfgang Tischer

Bergische Universität Wuppertal Dozent: M.Sc. Brice Hakwa

21. August 2011

Inhaltsverzeichnis

1 Einleitung 1

2 Copula 2

2.1 Definition der Copula . . . 2

2.2 Der Satz von Sklar . . . 3

2.3 Invarianz unter streng monoton steigenden Transformationen . . . 5

2.4 Beispiele für Copulas . . . 5

2.4.1 Die Gauß-Copula . . . 5

2.4.2 Die Gumbel-Copula . . . 6

3 Konzepte der Abhängigkeitsmodellierung 7 3.1 Lineare Korrelation . . . 7

3.1.1 Definition der linearen Korrelation . . . 7

3.1.2 Vor- und Nachteile der linearen Korrelation . . . 7

Exkurs: Sphärische und elliptische Verteilungen . . . 9

E.1 Sphärische Verteilungen . . . 9

E.2 Elliptische Verteilungen . . . 10

E.3 Korrelation und Kovarianz als natürliche Abhängigkeitsmaße in der Welt elliptischer Verteilungen . . . 11

E.4 Kovarianz und elliptische Verteilungen im Risikomanagement . . . 12

3.2 Alternative Abhängigkeitsmaße . . . 14

3.2.1 Komonotonie . . . 14

3.2.1.1 Fundamentale Copulas . . . 15

3.2.1.2 Die Schranken von Fréchet . . . 15

3.2.2 Rangkorrelation . . . 16

3.2.3 Tail Abhängigkeit . . . 17

3.2.3.1 Definition der Tail Abhängigkeit . . . 18

3.2.3.2 Tail-Abhängigkeitskoeffizienten für Beispiel-Copulas . . . 20

3.2.4 Konkordanz . . . 21

4 Irrtümer bzgl. Korrelation und Abhängigkeit 23 4.1 Irrtum 1 . . . 23

4.2 Irrtum 2 . . . 24

4.3 Irrtum 3 . . . 25

5 Fazit 26

Literaturverzeichnis 27

1 Einleitung

Diese Ausarbeitung thematisiert die Modellierung von Abhängigkeiten in Anlehnung an die Ar- beit „Correlation And Depedency In Risk Management: Properties And Pitfalls“ von Embrechts, McNeil und Straumann.

Die Modellierung von Abhängigkeiten zwischen Zufallsvariablen gehört zu den grundlegenden Aufgabenstellungen in wirtschaftsmathematischen Anwendungsbereichen. Mathematische Model- le finden dabei heutzutage nicht nur in der Finanz- und Versicherungsbranche Anwendung. Sie gewinnen auch in Industrie-Unternehmen mit integriertem Risikomanagement immer größere Be- deutung, da Risiken durch Zufallsvariablen beschrieben werden können und mithilfe von Abhän- gigkeitsmaßen das Zusammenspiel verschiedener solcher Risiken modelliert werden kann.

Typischerweise wird zur Modellierung von Abhängigkeiten das Maß der linearen Korrelation her- angezogen. Im Verlauf dieser Arbeit wird sich zeigen, dass mit der Verwendung der linearen Kor- relation zur Beschreibung von Abhängigkeiten durchaus einige Vorteile einhergehen. Besonders im Hinblick auf bestimmte Verteilungsklassen erweist sie sich als sehr geeignet. Wie diese Ausar- beitung jedoch auch aufzeigt, ist bei der Verwendung der linearen Korrelation Vorsicht geboten.

Es werden verschiedene Nachteile dieses Abhängigkeitsmaßes aufgezeigt, welche deutlich machen, dass andere Arten solcher Maße für bestimmte Anwendungsgebiete sinnvoller sein können.

Einige alternative Abhängigkeitsmaße lassen sich mit Kenntnissen über sogenannte Copulas her- leiten, weshalb in Kapitel 2 zunächst die Grundlagen dieses Themas angeführt werden. In dieser Ausarbeitung werden speziell vier solcher alternativer Maße vorgestellt; es handelt sich um:

• Komonotonie

• Rangkorrelation

• Tail Abhängigkeit

• Konkordanz

Abschließend werden drei klassische Irrtümer bezüglich linearer Korrelation und der Abhängigkeit zwischen Zufallsvariablen präsentiert, die in der Arbeit von Embrechts, McNeil und Straumann zum Ausdruck kommen.

2 Copula

Zu Beginn dieser Ausarbeitung sollen zunächst einmal wichtige Grundlagen geschaffen werden, die für das Verständnis der späteren Ausführungen von großer Bedeutung sind. Verschiedenste Maße zur Modellierung von Abhängigkeiten zwischen Zufallsvariablen lassen sich mithilfe von Copulas formulieren. Aus diesem Grund werden die wichtigsten Aspekte der Copulas in diesem Abschnitt angeführt.

2.1 Definition der Copula

Gegeben seien n ZufallsvariablenX1, . . . , Xn. Die Abhängigkeit zwischen diesen Zufallsvariablen wird bekanntermaßen vollständig durch ihre gemeinsame VerteilungsfunktionF beschrieben.1

F(x1, . . . , xn) =P(X1 ≤x1, . . . , Xn≤xn)

Geht man beispielsweise davon aus, dass mit den Zufallsvariablen X1, X2 zwei Risiken modelliert werden sollen, so lässt sich mithilfe der gemeinsamen VerteilungsfunktionFz.B. die wichtige Frage klären, „wie hoch die Wahrscheinlichkeit ist, gleichzeitig sowohl beim Risiko X1 einen Verlust von höchstens x1 als auch beim Risiko X2 einen Verlust von höchstens x2 zu erleiden“.2 Die grundsätzliche Idee ist es also, die Modellierung der Abhängigkeit zwischen Zufallsvariablen in geeigneter Weise auf die gemeinsame Verteilungsfunktion zurückzuführen. Dafür wird zunächst der folgende Satz benötigt.

Satz 2.1. 3 SeiX eine Zufallsvariable mit zugehöriger Verteilungsfunktion F. Sei weiterhinF−1 die Quantilfunktion zu F, also

F−1(α) =inf{x|F(x)≥α}, wobei α∈(0,1). Dann gilt

1. Für jede standard-gleichverteilte ZufallsvariableU ∼U(0,1)ist F−1(U)∼F.

2. Wenn F stetig ist, so ist die Zufallsvariable F(X) standard-gleichverteilt, also F(X) ∼ U(0,1).

Unter der Voraussetzung, dass die X1, . . . , Xn stetige RandverteilungsfunktionenF1, . . . , Fn be- sitzen, kann man den Vektor X = (X1, . . . , Xn)0 mithilfe des Punktes zwei aus dem obigen Satz derart transformieren, dass jede Komponente eine standard-gleichverteilte Randverteilung besitzt.

Benötigt wird hierfür eine TransformationT :Rn→Rn, die das Tupel (x1, . . . , xn)0 abbildet auf (F1(x1), . . . , Fn(xn))0. Dann gilt:

F(x1, . . . , xn) =P(F1(X1)≤F1(x1), . . . , Fn(Xn)≤Fn(xn)) =C(F1(x1), . . . , Fn(xn)).

Dabei stelltCdie gemeinsame Verteilungsfunktion des transformierten Vektors(F1(X1), . . . , Fn(Xn))0 dar. Man nennt C die Copula des Zufallsvektors(X1, . . . , Xn)0.4

1Vgl. [2] S. 4

2[1] S. 265

3Vgl. [2] S. 4

4Vgl. [2] S. 4

Definition 2.1. 5 Einen-dimensionale Copula ist eine Verteilungsfunktion eines Zufallsvektors X∈Rn, deren Randverteilungen alle (0,1)-gleichverteilt sind.

Bemerkung 2.1. Äquivalent zur obigen Definition kann eine Copula definiert werden als Funk- tion C: [0,1]n→[0,1]mit drei Eigenschaften:

1. C(x1, . . . , xn) ist monoton steigend in jeder Komponentexi. 2. C(1, . . . ,1, xi,1, . . . ,1) =xi ∀i∈ {1, . . . , n}, xi ∈[0,1].

3. Für alle(a1, . . . , an), (b1, . . . , bn)∈[0,1]n, mitai ≤bi gilt:

2

P

i1=1

. . .

2

P

in=1

(−1)i1+...+inC(x1i1, . . . , xnin)≥0, mit xj1 =aj undxj2 =bj ∀j∈ {1, . . . , n}.

Diese Summe kann interpretiert werden als:

P(a1 ≤X1≤b1, . . . , an≤Xn≤bn)≥0.

Es kann also festgehalten werden, dass die Idee bei Verwendung einer Copula ist, die gemeinsame VerteilungsfunktionF, welche die Abhängigkeitsstrutktur vollständig wiederspiegelt, in zwei Kom- ponenten aufzuteilen. Die Copula ermöglicht eine sehr flexible Modellierung da hier die Verteilung der einzelnen Zufallsvariablen über die eindimensionalen Randverteilungen festgelegt werden kann, während der Copula einzig die Rolle zukommt, die Abhängigkeit zwischen den Zufallsvariablen zu definieren.

2.2 Der Satz von Sklar

Der Satz von Sklar ist der wohl bedeutendste Satz in Bezug auf Copulas. Seine Bedeutung für die Abhängigkeitsmodellierung mittels Copulas soll in diesem Abschnitt verdeutlicht werden.

Satz 2.2. 6

1. Sei F eine multivariate Verteilungsfunktion mit Randverteilungsfunktionen F1, . . . , Fn. So existiert eine CopulaC : [0,1]n→[0,1], sodass für alle x1, . . . , xn∈Rgilt

F(x1, . . . , xn) =C(F1(x1), . . . , Fn(xn)).

Die Herleitung hierfür wurde bereits in Abschnitt 2.1 erläutert.

Falls F1, . . . , Fn stetig sind, so ist die Copula C sogar eindeutig bestimmt.

2. Seien nun umgekehrt eine CopulaC sowie die eindimensionalen Verteilungsfunktionen F1, . . . , Fn gegeben, dann ist die durch

F(x1, . . . , xn) =C(F1(x1), . . . , Fn(xn)).

definierte Verteilungsfunktion eine multivariate Verteilung mit den vorgegebenen Randver- teilungen F1, . . . , Fn.

Im Folgenden sollen die beiden zentralen Aussagen dieses Satzes erläutert werden.7

5Vgl. [2] S. 4

6Vgl. [1] S. 266

7Vgl. [1] S. 266

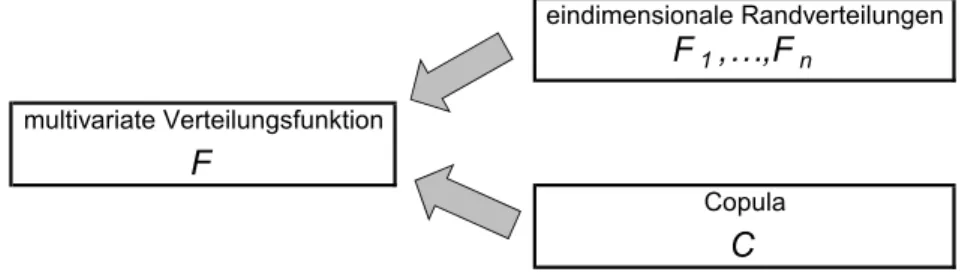

Der erste Teil des Satzes gibt an, dass es möglich ist eine beliebige multivariate Verteilung in ihre Randverteilungen einerseits und in eine Copula andererseits aufzuteilen.

eindimensionale Randverteilungen

F1,…,Fn

multivariate Verteilungsfunktion

F

Copula

C

Abbildung 2.1: Visualisierung des Satzes von Sklar (1.)

Der Satz von Sklar gibt jedoch lediglich an, dass die oben dargestellte Überführung möglich ist. Wie dies umgesetzt werden kann, wird hingegen nicht deutlich. Es ist jedoch klar, dass bei gegebener multivariater Verteilungsfunktionen die eindimensionalen Randverteilungen be- stimmt werden können. Um bei bekannter multivariater Verteilung F, sowie der Randverteilun- genF1, . . . , Fnzu einer CopulaC zu gelangen, sind folgende Überlegungen möglich. Sind nämlich Zufallsvariablen X1, . . . , Xn mit zugehörigen Verteilungsfunktionen F1, . . . , Fn gegeben und sei ui =P(Xi ≤xi) =Fi(xi) und daherui∈[0,1]für alle i∈ {1, . . . , n}, so folgt:

C(u1, . . . , un) =F(F1−1(u1), . . . , Fn−1(un)).

Der zweite Teil des Satzes stellt quasi eine Umkehrung des ersten Teiles dar. Hier bietet der Satz von Sklar eine Möglichkeit, aus n gegebenen einzelnen Verteilungen und einer Copula eine gemeinsame Verteilungsfunktion zu konstruieren.8

Dies kann einfach umgesetzt werden, indem man die einzelnen Verteilungsfunktionen F1, . . . , Fn

in die gegebene CopulaC einsetzt. Die dadurch erhaltene Funktion F ist dann eine gemeinsame Verteilungsfunktion, die tatsächlich dieF1, . . . , Fn als Randverteilungen besitzt.

eindimensionale Randverteilungen

F1,…,Fn

multivariate Verteilungsfunktion

F

Copula

C

Abbildung 2.2: Visualisierung des Satzes von Sklar (2.)

„Aus Sicht des Risikomanagements ist die Aussage 2. einer der Hauptgründe, die für den Einsatz von Copulas sprechen, denn sie gestattet es, die Modellierung des gemeinsamen Risikos [modelliert durch Zufallsvariablen] in zwei getrennte Schritte aufzuteilen:

• Modellierung der Einzelrisiken, d.h. der Verteilungen F1, . . . , Fn

• Wahl eines geeigneten Copula-Modells C, das alle Informationen über die Abhängigkeiten zwischen den Einzelrisiken enthält.“9

8Vgl. [1] S. 266

9[1] S. 266-267

Fasst man dabei die Risiken mithilfe von Copulas zusammen, geht keinerlei Information über die Einzelrisiken verloren, da die Einzelverteilungen gemäß Satz 2.2 als Randverteilungen erhalten bleiben.10

2.3 Invarianz unter streng monoton steigenden Transformationen

Copulas besitzen eine Eigenschaft, die für praktische Anwendungen sehr nützlich ist. Die Abhän- gigkeitsstruktur, welche durch eine Copula ausgedrückt wird, ist invariant unter streng monoton steigenden, stetigen TransformationenT :R→R der Randverteilungen.11

Satz 2.3. 12 Sei C die Copula zu (X1, . . . , Xn)0. Dann ist C für alle streng monoton steigenden, stetigen Transformationen T1, . . . , Tn ebenfalls die Copula zu(T1(X1), . . . , Tn(Xn))0.

Bemerkung 2.2. 13 Falls sämtliche Randverteilungen von X stetig sind, kann im obigen Satz auf die Stetigkeit der Transformationen verzichtet werden.

Diese Eigenschaft der Copulas bietet - besonders im Hinblick auf die Modellierung von Risiken - enorme Vorteile. Hat man z.B. die Abhängigkeit von Verlusten mehrerer Einzelrisiken mittels einer Copula modelliert und verwendet dabei absolute Euro-Beträge, so kann bei dem Übergang zu einem Modell in Dollar-Beträgen weiterhin dieselbe Copula verwendet werden. Die Randver- teilungen, die die Verteilungen der Einzelrisiken modellieren, müssen hingegen in der Regel an die neuen Skalen angepasst werden.14

2.4 Beispiele für Copulas

In diesem Abschnitt sollen zwei klassische Beispiele für häufig verwendete Copulas vorgestellt werden.15Zur Vereinfachung werden dabei ausschließlich zweidimensionale Copulas betrachtet.16 Sind also zwei Zufallsvariablen X und Y mit zugehörigen Verteilungsfunktionen F1 und F2 ge- geben. Sei u1 = P(X ≤ x) = F1(x) und u2 = P(Y ≤ y) = F2(y), also u1, u2 ∈ [0,1]. Wie in Abschnitt 2.2 gezeigt wurde gilt dementsprechend:

C(u1, u2) =F(F1−1(u1), F2−1(u2)).

2.4.1 Die Gauß-Copula

Bei der Gauß-Copula sind die Randverteilungen F1 und F2 als univariate Normalverteilungen vorgegeben. Die gemeinsame Verteilung F, stellt hier die bivariate Normalverteilung dar.

Definition 2.2. Sei Φρdie Verteilungsfunktion der bivariaten Normalverteilung N2(0,Ψ), wobei Ψ =

1 ρ ρ 1

10Vgl. [1] S. 267

11Vgl. [2] S. 6

12Vgl. [2] S. 6

13Vgl. [2] S. 6

14Vgl. [2] S. 267

15Für weitere Beispiele verweisen wir auf [1].

16Vgl. [1] S. 268-271

die Korrelationsmatrix mit Korrelationskoeffizienten ρ=ρ(X, Y) = √ Cov(X,Y)

Var(X)·Var(Y) darstellt.

Es bezeichne weiterhin Φ die Verteilungsfunktion der univariaten Normalverteilung. Dann ergibt sich die Gauß-Copula gemäß (*) als:

CρGa(u1, u2) = Φρ(Φ−1(u1),Φ−1(u2)).

Dies lässt sich formulieren als:

CρGa(u1, u2) =RΦ−1(u1)

−∞

RΦ−1(u2)

−∞

1 2π√

1−ρ2exp −(s2

1−2ρs1s2+s22) 2(1−ρ2)

ds1ds2.

Die Darstellung der Gauß-Copula in einer geschlossenen Form ist also nicht möglich. Zur Berech- nung bedarf es daher Methoden der numerischen Integration.

Sind anders herum die Gauß-Copula sowie zwei normalverteilte RisikenX undY mit den Vertei- lungsfunktionen F1 undF2 und Korrelationskoeffizient ρ gegeben, so ergibt sich:

F(x, y) =CρGa(F1(x), F2(y)).

Dabei stellt F nun die multivariate Normalverteilung dar. „Das heißt, die Gauß-Copula ist genau diejenige Copula, die mehrere univariate Normalverteilungen zu einer multivariaten Normalver- teilung zusammenführt.“17Das heißt:

Φρ(x, y) =CρGa(Φ(x),Φ(y)).

2.4.2 Die Gumbel-Copula

Ein weiteres oft verwendetes Beispiel für eine Copula ist die sogenannte Gumbel-Copula.

Definition 2.3. 18 Für einen ParameterΘ∈(0,1]ist die Gumbel-Copula definiert durch:

CΘGu(u1, u2) =exp

−

(−logu1)Θ1 + (−logu2)Θ1)Θ .

Im Gegensatz zu der im vorigen Abschnitt vorgestellten Gauß-Copula existiert für die Gumbel- Copula also eine explizite Darstellungsweise, welche die Berechnung ohne Einsatz aufwändiger numerischer Integrationsmethoden ermöglicht.

Wird die Abhängigkeit zwischen Zufallsvariablen mittels der Gumbel-Copula modelliert, ist es mithilfe des Parameters Θ möglich, sämtliche positiven Abhängigkeitsstrutkturen zwischen Un- abhängigkeit (Θ = 1) und perfekter Abhängigkeit (Θ→0) abzudecken.

17[1] S. 269

18Vgl. [2] S. 5

3 Konzepte der Abhängigkeitsmodellierung

In diesem Hauptkapitel werden verschiedene Konzepte der Abhängigkeitsmodellierung zwischen Zufallsvariablen vorgestellt. Dabei werden für jedes Maß zunächst die nötigen Definitionen so- wie wichtige Eigenschaften angeführt, um anschließend wesentliche Unterschiede zwischen den verschiedenen Abhängigkeitsmaßen sowie deren jeweilige Vor- und Nachteile deutlich zu machen.

3.1 Lineare Korrelation

Das wohl am häufigsten verwendete Maß zur Modellierung von Abhängigkeiten zwischen Zufalls- variablen stellt die Korrelation dar. Die Idee dieses Maßes ist es, die Stärke des linearen Zusam- menhangs zwischen zwei Zufallsvariablen in Form einer Maßzahl - dem Korrelationskoeffizienten - auszudrücken.

3.1.1 Definition der linearen Korrelation

Definition 3.1. Der Pearsonsche bzw. lineare Korrelationskoeffizient zweier Zufallsvariablen X und Y (mit 0 < Var(X)<∞ und 0 < Var(Y)<∞), ist definiert als:

ρ(X, Y) = Cov(X, Y) pVar(X)·Var(Y)

„Die Korrelation ist also die durch das Produkt der Standardabweichungen normierte Kovarianz;

es gilt stetsρ(X, Y)∈[−1,1].“19

In Abhängigkeit des Korrelationskoeffizienten werden drei spezielle Fälle unterschieden:

• Ist ρ(X, Y) = 0, so spricht man von unkorrelierten Zufallsvariablen. Es besteht also kein linearer Zusammenhang zwischen X und Y.

• Im Fall ρ(X, Y) = +1handelt es sich um perfekte lineare Abhängigkeit im positiven Sinn.

• Gilt hingegenρ(X, Y) =−1, so liegt perfekte lineare Abhängigkeit im negativen Sinn vor.

Bemerkung 3.1. Um von dem Fall zweier ZufallsvariablenX undY auf den allgemeineren Fall von n Zufallsvariablen X = (X1, . . . , Xn)0 überzugehen, werden zwei Matrizen eingeführt. Die Kovarianzmatrix Cov(X) bzw. die Korrelationsmatrixρ(X) enthält an Position(i, j) den Eintrag Cov(Xi, Xj) bzw. ρ(Xi, Xj).

3.1.2 Vor- und Nachteile der linearen Korrelation

Die Tatsache, dass die lineare Korrelation derart häufig als Abhängigkeitsmaß eingesetzt wird, hat mehrere Gründe.20 Zunächst einmal kann festgehalten werden, dass der Korrelationskoeffizient in der Regel sehr einfach zu bestimmen ist, da die Berechnung der zweiten Momente für viele bivariate Verteilungen sehr einfach ist. Dahingegen ist die Bestimmung vieler der im weiteren Verlauf der Ausarbeitung vorgestellten Maße komplizierter.

19[1] S. 250

20Vgl. [2] S. 7

Zudem kann die Bestimmung der Korrelation von linear transformierten Zufallsvariablen sehr elegant erfolgen, wie folgende Ausführungen zeigen.21

Seien a, c∈R\ {0} und b, d∈R. Dann ist

Cov(aX+b, cY +d) =ac·Cov(X, Y) und daher

ρ(aX +b, cY +d) = a

|a|· c

|c|·ρ(X, Y)

Das bedeutet insbesondere, dass die Korrelation invariant unter positiven affinen Transformatio- nen ist, da im Fallea, c >0 gilt:ρ(aX+b, cY +d) =ρ(X, Y).

Ein weiterer Grund für die Beliebtheit der Korrelation ist, dass für multivariate sphärische und el- liptische Verteilungen die gesamte Abhängigkeitsstruktur zweier Zufallsvariablen vollständig durch die Korrelation beschrieben werden kann.22Insbesondere gilt für eine elliptisch verteilte Zufallsva- riableX also, dass sie endliche Varianz besitzt - alsoV ar(X)<∞ - sodass der lineare Korrelati- onskoeffizient für elliptische Verteilungen wohldefiniert ist. Zu dieser Klasse von Verteilungen zählt unter anderem die multivariate Normalverteilung, die aufgrund ihrer vielseitigen Anwendungsbe- reiche den Einsatz des Korrelationskoeffizienten als Abhängigkeitsmaß oftmals sehr sinnvoll macht.

Wie man zu dieser zentralen Aussage gelangt wird in dem nachfolgenden Exkurs verdeutlicht.

Jedoch gehen mit der Verwendung der Korrelation als Abhängigkeitsmaß auch einige Probleme und Irrtümer einher.23 Besitzt eine Zufallsvariable X eine Verteilung, bei der die Varianz nicht endlich ist, wie es z.B. bei den „heavy-tailed“ Verteilungen der Fall ist, so ist der Korrelations- koeffizient nicht definiert. Diese Eigenschaft schränkt die Anwendbarkeit der Korrelation als Ab- hängigkeitsmaß ein und verursacht beispielsweise dann Probleme, wenn Verteilungen mit hohen Wahrscheinlichkeiten für extreme Ereignisse vorliegen.

Ein großer Nachteil der Korrelation ist, dass diese lediglich den linearen Zusammenhang zwischen Zufallsvariablen misst, sodass nichtlineare Abhängigkeiten nicht erkannt werden. Dies hat zur Folge, dass ρ(X, Y) = 0 nicht unbedingt bedeutet, dass die beiden Zufallsvariablen X und Y unabhängig sind, jedoch kann ein linearer Zusammenhang ausgeschlossen werden. SindX und Y hingegen unabhängig, so besteht überhaupt kein Zusammenhang zwischen diesen beiden Zufalls- variablen, also auch kein linearer. Es ist klar, dass dann stetsρ(X, Y) = 0gilt. Der einzige Fall, in dem Unkorreliertheit mit Unabhängigkeit einhergeht ist, falls sowohl die gemeinsame Verteilung, als auch die Randverteilungen normalverteilt sind.

Des Weiteren ist anzumerken, dass die Korrelation, wie oben gezeigt, zwar invariant unter po- sitiven affinen Transformationen ist, jedoch nicht unter nichtlinearen streng monoton steigenden Transformationen T :R→ R. Das bedeutet, dass i.A. ρ(T(X), T(Y))6=ρ(X, Y) ist. In Kapitel 2.2 wurde bereits gezeigt, dass diese Eigenschaft für Copulas hingegen sehr wohl gilt.

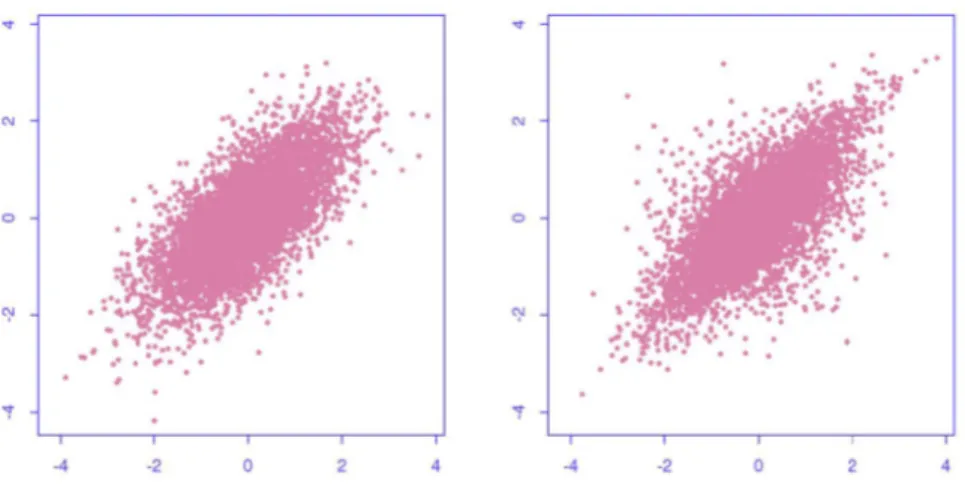

Die nachfolgende Abbildung 3.1 fasst das bedeutendste Problem in Bezug auf die Verwendung der Korrelation als Abhängigkeitsmaß zusammen. Obwohl sowohl dem linken, als auch dem rech- ten Plot die selben Randverteilungen und die gleiche Korrelation zugrunde liegen, ist deutlich zu erkennen, dass sich die Abhängigkeitsstrukturen unterscheiden. Dies bedeutet, dass es für zwei Zufallsvariablen X undY, deren Verteilungen und Korrelationskoeffizient bekannt sind i.A., eine Vielzahl von Verteilungsmodellen gibt, die die geforderten Randverteilungen sowie die vorgegebe- ne Korrelation erfüllen.24 Unter Verwendung der Korrelation allein, kann also die Abhängigkeit zwischen Zufallsvariablen i.A. also nicht exakt beschrieben werden.

21Vgl. [1] S. 254

22Vgl. [1] S. 254

23Vgl. [2] S. 7-8 und [1] S. 254

24Vgl. [1] S. 254

Abbildung 3.1: Realisationen zweier Zufallsvariablen mit identischer Randverteilung und gleicher Korrelation, aber unterschiedlicher Abhängigkeitsstruktur.25

Exkurs: Sphärische und elliptische Verteilungen

Wie in Abschnitt 3.1.2 bereits angesprochen, ist es für den Spezialfall sphärisch bzw. elliptisch verteilter Zufallsvariablen möglich, die komplette Abhängigkeitsstruktur mittels der linearen Kor- relation auszudrücken. Um deutlich zu machen, warum die Korrelation für diese Verteilungen ein sinnvolles Maß zur Modellierung von Abhängigkeiten zwischen Zufallsvariablen bietet, ist es erforderlich diese näher zu betrachten.

E.1 Sphärische Verteilungen

Sphärische Verteilungen stellen eine Erweiterung der multivariaten Normalverteilung Nn(0, I) dar. Sie bilden also eine Klasse symmetrischer Verteilungen für unkorrelierte Zufallsvariablen (Kovarianzmatrix entspricht Einheitsmatrix) mit Mittelwert null.26

Definition 3.2. 27 Ein ZufallsvektorX = (X1, . . . , Xn)0 hat eine sphärische Verteilung, wenn für jede orthogonale Matrix U ∈Rn×n (also U0U =U U0 =In×n) die folgende Gleichung erfüllt ist.

U X=d X2

Bemerkung 3.2. A=d B bedeutet dabei „A besitzt dieselbe Verteilung wie B“.

Definition 3.3. 28 Für alle t ∈ Rn ist die charakteristische Funktion ψ : Rn → C einer n- dimensionalen Zufallsvariablen X definiert als:

ψX(t) =E(exp(it0X))

Die charakteristische Funktion sphärischer Verteilungen nimmt eine sehr einfache Form an, denn

25Quelle: [3] S.16

26Vgl. [2] S. 8

27Vgl. [2] S. 8

28Vgl. [2] S. 8

es existiert eine Funktion γ :R+0 →R+0, sodass ψ(t) =γ(t0t) =γ(t21+. . .+t2n).Die Funktionγ wird auch als charakteristischer Generator der sphärischen Verteilung bezeichnet.29 Man schreibt daher auch:

X∼Sn(γ).

Bemerkung 3.3. 30

• Es gilt zu beachten, dass sphärische Verteilungen i.A. Verteilungen unkorrelierter - nicht jedoch unabhängigier - Zufallsvariablen darstellen.

• Die multivariate Normalverteilung ist die einzgie Verteilung unter den sphärischen Vertei- lungen, bei der die Zufallsvariablen auch unabhängig sind.

• X∼Sn(γ)ist äquivalent zu X=d RU, wobeiU auf der EinheitskugelSn−1={x∈R|x0x= 1}gleichverteilt ist und R≥0eine von U unabhängige Zufallsvariable darstellt. Sphärische Verteilungen können also interpretiert werden als n-dimensionale Gleichverteilungen auf Umgebungen mit verschiedenen Radien.

E.2 Elliptische Verteilungen

Elliptische Verteilungen stellen eine Erweiterung der multivariaten Normalverteilung Nn(µ,P ) dar. Mathematisch gesehen ergeben sich die elliptischen Verteilungen als affine Transformationen sphärischer Verteilungen im Rn.31 Sie bilden also eine Klasse symmetrischer Verteilungen mit Mittelwert µund KovarianzmatrixP

.

Definition 3.4. 32 Sei eine affine TransformationT :Rn→Rn, x7→Ax+µ, A∈Rn×n, µ∈Rn gegeben. Ein Zufallsvektor X ∈ Rn hat eine elliptische Verteilung, falls X = T(Y), wobei Y ∼ Sn(γ).

Die charakteristische Funktion ist gegeben als:

ψ(t) =E(exp(it0X)) =E(exp(it0(AY +µ)) =exp(it0µ)exp(i(A0t)0Y) =exp(it0µ)γ(t0P t), mit P

=AA0. Dass ein Zufallsvektor X eine elliptische Verteilung besitzt, wird folgendermaßen ausgedrückt:

X∼En(µ,P , γ).

Bemerkung 3.4. 33

• Die Kenntnis über die Verteilung vonX bestimmt lediglich den Parameterµ in eindeutiger Weise. P

und γ sind hingegen lediglich bis auf eine positive Konstante bestimmt.

• Es ist möglich P

so zu wählen, dass sie die Kovarianzmatrix von X darstellt. Sei dazu X∼En(µ,P

, γ), sodassX=d AY +µ, mit P

=AA0 undY ∼Sn(γ). Laut Bemerkung 2.3 gilt daher Y =d RU, wobei U auf der Einheitskugel Sn−1 gleichverteilt ist und R ≥0 eine von U unabhängige Zufallsvariable darstellt. Falls E(R2)<∞, so ist:

29Vgl. [2] S. 8

30Vgl. [2] S. 9

31Vgl. [2] S. 9

32Vgl. [2] S. 9

33Vgl. [2] S. 9

∗ E(X) =µ

∗ Cov(X) = AA0E(Rn 2) =

PE(R2)

n , daCov(U) = In×nn . Durch Wahl vonγ˜=γ(n/E(Ru 2)) gewährleistet manCov(X) =P

.

• Das bedeutet, dass eine elliptische Verteilung eindeutig definiert wird durch Kenntnis des Mittelwerts, der Kovarianzmatrix und des charakteristischen Generators. Dies heißt insbe- sondere, dass die Varianz einer elliptisch verteilten ZufallsvariableXendlich ist. Aus diesem Grund ist der lineare Korrelationskoeffizient für elliptische Verteilungen wohldefiniert.

E.3 Korrelation und Kovarianz als natürliche Abhängigkeitsmaße in der Welt elliptischer Ver- teilungen

In diesem Abschnitt werden einige Gründe angeführt, die deutlich machen, dass die Korrelation und die Kovarianz in gewisser Hinsicht „natürliche Abhängigkeitsmaße“ in der Welt elliptischer Verteilungen sind.34

Eine sehr nützliche Eigenschaft der elliptischen Verteilungen ist, dass bei Kenntnis des Mittel- werts, der Kovarianzmatrix und des charakteristischen Generators einer elliptisch verteilten Zu- fallsvariablen X die entsprechenden Parameter für Linearkombinationen, die Randverteilungen und bedingte Verteilungen von X leicht zu bestimmen sind. Die folgenden Eigenschaften fassen dies zusammen:35

• Jede Linearkombination eines elliptisch verteilten Zufallsvektors ist selbst wieder elliptisch verteilt und besitzt dabei sogar den selben charakteristischen Generator. Sei dafür X ∼ En(µ,P

, γ),B ∈Rm×n undb∈Rm, so ist BX+b∼Em(Bµ+b, BP B0, γ).

Die X1, . . . , Xn sind alle symmetrisch verteilte Zufallsvariablen des selben Typs. Letzteres bedeutetXi=d aXj+bmit a >0 undb∈R.

• Die Randverteilungen elliptischer Verteilungen sind ebenfalls elliptisch und auch sie besitzen den selben charakteristischen Generator. Sei also X =

X1

X2

∼En(µ,P

, γ), mitX1 ∈Rp und X2 ∈ Rq, wobei p+q = n ist. Sei weiterhin E(X) = µ =

µ1

µ2

, mit µ1 ∈ Rp und µ2∈RqundP

= P

11

P

12

P

21

P

22

. Dann istX1 ∼Ep(µ1,P

11, γ)sowieX2 ∼Eq(µ2,P

22, γ).

• Sei die KovarianzmatrixP

als positiv definit vorausgesetzt. Dann ist die bedingte Verteilung X1unterX2auch elliptisch verteilt - im Gegensatz zu den beiden oberen Punkten allerdings i.A. mit einem anderen charakteristischen Generator: X1|X2 ∼Ep(µ1.2,P

11.2,γ). Dabei ist˜ µ1.2=µ1+P

12

P−1

22(X2−µ2) und P

11.2 =P

11−P

12

P−1 22

P

21.

Lediglich für den Spezialfall der multivariaten Normalverteilung, bei der Unkorreliertheit der Unabhängigkeit entspricht, bleibt der Generator auch hier gleich.

Da sämtliche Randverteilungen vom selben Typ sind, wird eine elliptische Verteilung in eindeutiger Weise durch den Mittelwert, die Kovarianzmatrix sowie die Kenntnis über den Verteilungstyp bestimmt. Oder anders ausgedrückt: die gesamte Abhängigkeitsstruktur einer stetigen, elliptischen Verteilung ist eindeutig festgelegt durch die Korrelationsmatrix und den Verteilungstypen.36 Das bedeutet, dass für stetige und elliptisch verteilte Zufallsvariablen jegliche Form von Abhängigkeit zwischen diesen Zufallsvariablen komplett über die Korrelation beschrieben werden kann. Diese

34Vgl. [2] S. 10

35Vgl. [2] S. 10

36Vgl. [2] S. 11

zentrale Folgerung macht die besondere Stellung der Korrelation in der Welt der elliptischen Verteilungen deutlich - sie stellt hier das ideale Abhängigkeitsmaß dar.

E.4 Kovarianz und elliptische Verteilungen im Risikomanagement

Ein weiterer bedeutender Aspekt elliptischer Verteilungen ist, dass diese die Umsetzung vieler mathematischer Standard-Modelle zulassen. Neben dem Einsatz in der Finanzmathematik macht man sich diese Eigenschaft auch im Bereich des Risikomanagements zu nutzen, da elliptische Verteilungen den Einsatz des Value-at-Risk als Risikomaß ebenso unterstützen, wie beispielsweise die Portfoliooptimierung nach Markowitz.37

Um zu veranschaulichen warum die Verwendung des Value-at-Risk in der Welt elliptischer Ver- teilungen sehr sinnvoll ist, betrachten wir im Folgenden einen elliptisch verteilten Zufallsvektor X = (X1, . . . , Xn)0, wobei Xi für ein Risiko i steht. Es ist nun möglich eine Menge linearer Portfolios Z aus diesen Risiken zusammenzustellen:

{Z =

n

P

i=1

λiXi|λi ∈R}.

Die Verteilungsfunktion von PortfolioZ ist gegeben durchFZ und der Value-at-Risk dieses Port- folios lässt sich zu vorgegebener Wahrscheinlichkeit α bekanntermaßen berechnen als:

V aRα(Z) =FZ−1(α) =inf{z∈R|FZ(z)≥α}.

Für die weiteren Überlegungen sind zunächst zwei Definitionen nötig.

Definition 3.5. 38 Ein Risikomaß ist eine Funktionζ mit:

X7→ζ(X).

Das heißt ein Risikomaß ordnet jedem RisikoX eine reelle Zahl zu.

Definition 3.6. 39 Ein kohärentes Risikomaßζ (nach Artzner, Delbaen, Eber und Heath) ist ein Risikomaß mit folgenden Eigenschaften:

1. Positivität: Für jede positive Zufallsvariable X ≥0 gilt: ζ(X)≥0.

Einem Risiko, welches niemals zu Gewinnen führt, wird immer ein nichtnegativer Wert zugeordnet.

2. Subadditivität: Für zwei Zufallsvariablen X und Y gilt: ζ(X+Y)≤ζ(X) +ζ(Y).

Fasst man zwei Risiken zu einem Portfolio aus ebendiesen Risiken zusammen, so entsteht niemals zusätzliches Risiko. Durch den Diversifikationseffekt vermindert sich das Risiko des Portfolios potentiell.

3. Positive Homogenität: Für jedesλ≥0 ist: ζ(λX) =λζ(X).

Ist ein Verlustλ-mal so groß wie ein anderer Verlust, so wird das Risiko auchλ-mal so stark bewertet.

37Vgl. [2] S. 11

38Vgl. [1] S. 103

39Vgl. [2] S. 13

4. Translationsinvarianz: Für jedes a∈R gilt: ζ(X+a) =ζ(X) +a.

Erhöht (bzw. vermindert) sich der Verlust um einen konstanten Faktor a, so erhöht (bzw.

vermindert) sich der Risikowert um denselben Wert.

Es ist sofort ersichtlich, dass die Eigenschaften kohärenter Risikomaße sehr wünschenswert sind, da sie ein Risikomaß sehr realitätsnah werden lassen.

Nun ist es so, dass der Value-at-Risk i.A. kein kohärentes Risikomaß darstellt, da er die Subadditi- vitätsbedingung nicht erfüllt. Für elliptische Verteilungen ist jedoch auch diese Eigenschaft erfüllt (denn: X und Y elliptisch ⇒ X+Y elliptsch) und der VaR bildet tatsächlich ein kohärentes Risikomaß mit den wünschenswerten Eigenschaften aus Definition 3.6.40 Der Beweis hierfür kann [2] entnommen werden. Es ist klar, dass man nur dann einen möglichst genauen und realistischen Wert für den Value-at-Risk erhält, wenn man in der Lage ist die Abhängigkeiten der Realität auch im Modell möglichst genau zu beschreiben. Dies ist - wie gezeigt wurde - mit dem linearen Kor- relationskoeffizienten als Abhängigkeitsmaß jedoch nur für elliptische Verteilungen gegeben. Die Verwendung des Value-at-Risk als Risikomaß für das oben definierte PortfolioZ ist in der Welt el- liptisch verteilter Risiken also äußerst sinnvoll.41Zur Abhängigkeitsmodellierung nicht-elliptischer Verteilungen sollte der lineare Korrelationskoeffizient jedoch nicht verwendet werden.

40Vgl. [1] S. 104

41Vgl. [2] S. 12

3.2 Alternative Abhängigkeitsmaße

Im Abschnitt zur linearen Korrelation wurde deutlich, dass sich Abhängigkeiten zwischen elliptisch verteilten Zufallsvariablen in idealer Weise unter Verwendung des linearen Korrelationskoeffizien- ten beschreiben lassen. In diesem Fall ist es also (beispielsweise mit einer Monte-Carlo-Simulation) möglich den Value-at-Risk zuverlässig anhand der Randverteilungen und der Korrelation zu be- stimmen.

Im Allgemeinen hat man es aber nicht mit elliptisch verteilten Zufallsvariablen zu tun. Gesucht sind also weitere Maße, die es erlauben die tatsächliche Abhängigkeitstruktur zwischen Zufallsva- riablen genauer zu beschreiben. Diese anderen Maße lassen sich in unterschiedlicher Art und Weise mithilfe von Copulas formulieren. Der Value-at-Risk kann dann ebenfalls mithilfe einer Monte- Carlo-Simulation bestimmt werden und zwar anhand der Randverteilungen und der zugehörigen Copula.

Auswirkungen auf den Value-at-Risk

Für den Value-at-Risk bedeutet das zunächst, dass dann auch Abhängigkeiten Beachtung fin- den, die durch den linearen Korrelationskoeffizienten nicht erfasst wurden. Die rein intuitive Folge daraus: Gegenüber einer Berechnung mit der linearen Korrelation verstärken sich positive Abhän- gigkeiten und negative Abhängigkeiten schwächen sich noch weiter ab. Der Value-at-Risk wird also bei positiven Abhängigkeiten größer, weil in dem Wert nun auch noch das Risiko beachtet wird, was der lineare Korrelationskoeffizient nicht erfasst hat. Das ist also durchaus wünschenswert, wenn man an einem möglichst realitätsnahen Modell interessiert ist um nicht von unerkannten Risiken überrascht zu werden.

Im Folgenden werden einige solche alternative Abhängigkeitsmaße vorgestellt.

3.2.1 Komonotonie

Zunächst wird mit der Komonotonie ein sehr allgemeines Maß für perfekte Abhängigkeit betrach- tet.

Definition 3.7. Zwei RisikenX undY werden komonoton genannt, wenn es eine Zufallsvariable Z und zwei monoton steigende Funktionen f1 und f2 gibt, sodass

X=f1(Z) und Y =f2(Z)

gilt. Wenn f1 eine monoton steigende Funktion ist und f2 monoton fällt, so spricht man von kontramonotonen Zufallsvariablen.

Konkret bedeutet dies, dass die Entwicklung der beiden Risiken komplett von einem einzigen gemeinsamen Faktor abhängt. Im Fall der Komonotonie können sich diese Risiken also niemals ausgleichen, so dass man dies als „extremste“ Form der positiven Abhängigkeit bezeichnen kann.42 Steigt hingegen das eine Risiko bei zwei kontramonotonen Risiken, so fällt das andere, so dass man hier von extremster negativer Abhängigkeit sprechen kann.

Bemerkung 3.5. Sind X und Y komonotone Zufallsvariablen, dann gilt V aRα(X + Y) = V aRα(X) +V aRα(Y).43

42Vgl. [1] S. 102

43Vgl. [2] S. 27

3.2.1.1 Fundamentale Copulas

Komonotonie und Kontramonotonie lassen sich - zumindest im zweidimensionalen Fall - durch bestimmte Copulas modellieren. Zusammen mit der Unabhängigkeits-Copula bilden diese zwei Copulas die Gruppe der fundamentalen Copulas. Im Folgenden werden die fundamentalen zwei- dimensionalen Copulas vorgestellt.

Definition 3.8. Die Komonotonie-CopulaCo wird für alle (u1, u2)∈[0,1]2 definiert durch:

Co(u1, u2) =min(u1, u2).

Definition 3.9. Die Kontramonotonie-CopulaCu wird für alle (u1, u2)∈[0,1]2 definiert durch:

Cu(u1, u2) =max(u1+u2−1,0).

Die Richtigkeit der beiden Copulas garantiert uns der nachfolgende Satz, für dessen Beweis wir auf [2] verweisen.

Satz 3.1. 44

Sei Cu (bzw. Co) eine zu dem Zufallsvektor (X1, X2)0 gehörige Copula. Dann existieren zwei monotone Funktionen f1 und f2 und eine Zufallsvariable Z, so dass

(X1, X2)0 = (f1(Z), f2(Z))0 mit f1 steigend und f2 fallend (bzw.f1 und f2 beide steigend).

Wie man unschwer erkennt, entspricht dies genau unserer Definition von Komonotonie und Kon- tramonotonie. Die Copulas erzeugen also wirklich diese Abhängigkeitsstrukturen.

Definition 3.10. Die Unabhängigkeits-Copula Cid wird für alle (u1, u2)∈[0,1]2 definiert durch:

Cid(u1, u2) =u1·u2.

Für stochastisch unabhängige ZufallsvariablenX1 undX2 ist dies wirklich die richtige Copula, da nach dem Satz von Sklar

Cid(u1, u2) =Cid(F1(x1), F2(x2)) =F(x1, x2)

gilt und außerdem für zwei unabhängige ZufallsvariabelnX1 und X2 bekanntermaßen F(x1, x2) =F1(x1)·F2(x2) =u1·u2.

gilt.

3.2.1.2 Die Schranken von Fréchet

Mit Hilfe dieser drei Copulas lassen sich also die drei Extremfälle der Abhängigkeitsmodellierung (komplette negative Abhängigkeit, Unabhängigkeit und komplette positive Abhängigkeit) darstel- len. Dadurch stehen sie zu vielen anderen Copulas in einer interessanten Beziehung. Als Beispiel hierfür sei die Beziehung zur Gumbel-Copula aus Abschnitt 2.4.2 genannt, die gewissermaßen zwischen der UnabhängigkeitscopulaCid und der Komonotonie-CopulaCo interpoliert.45

44[2] S. 14

45Vgl. [1] S. 270

Eine wichtige weitere solche Beziehung liefern die Fréchet Schranken. Diese werden hier zunächst wieder allgemein (d.h. nicht nur für den zweidimensionalen Fall) definiert.

Satz 3.2. Für jede n-dimensionale Copula C(u1, ..., un) gilt

max{u1+...+un+ 1−n , 0} ≤C(u1, ..., un)≤min{u1, ..., un}

Bemerkung 3.6. Im zweidimensionalen Fall gilt also genauCu ≤C(u1, u2)≤Co, d.h. dass alle anderen Copulas zwischen der Kontramonotonie-Copula und der Komonotonie-Copula liegen. Für höhere Dimensionen sind die Schranken ähnlich zu interpretieren, jedoch ist die untere Schranke keine Copula mehr - die obere Schranke hingegen schon.46

Zusammenfassend ist Komonotonie bzw. Kontramonotonie ein Abhängigkeitsmaß, das sehr viel allgemeiner definiert ist als z.B. die Korrelation und damit nicht nur lineare sondern jede Form von (perfekter) Abhängigkeit erkennt. Das Maß ist zudem kompatibel mit der Copula-Theorie, so dass es möglich ist die gemeinsame Verteilungsfunktion von zwei (oder mehreren) komonotonen Risiken mit bekannten Randverteilungen zu berechnen.

3.2.2 Rangkorrelation

Ein weiteres Abhängigkeitsmaß ist die Rangkorrelation. Wie diese genau definiert ist und welche Vorteile sie gegenüber der linearen Korrelation bietet, soll in diesem Abschnitt kurz erläutert werden.

Definition 3.11. Seien X und Y Zufallsvariablen mit den VerteilungsfunktionenF1 undF2 und F ihre gemeinsame Verteilungsfunktion. Der Spearmansche Rangkorrelationskoeffizient vonX und Y ergibt sich als

ρS(X, Y) =ρ(F1(X), F2(Y))

wobei ρ den linearen Korrelationskoeffizienten bezeichnet.

Neben dem Spearmanschen Rangkorrelationskoeffizienten existiert der Kendallsche Rangkorrela- tionskoeffizient. Beide haben - wie wir später sehen werden - ähnliche Eigenschaften.

Definition 3.12. Seien (X1, Y1)0 und(X2, Y2)0 zwei unabhängige Paare von Zufallsvariablen und F jeweils ihre gemeinsame Verteilungsfunktion. Der Kendallsche Rangkorrelationskoeffizient ergibt sich dann als

ρτ(X, Y) =P[(X1−X2)(Y1−Y2)>0]−P[(X1−X2)(Y1−Y2)<0].

Bemerkung 3.7.

• Wennn >2Zufallsvariablen betrachtet werden sollen, werden die paarweisen Korrelationen - genau wie bei der linearen Korrelation - in eine n×n-Matrix geschrieben.

• Während die lineare Korrelation den Grad linearer Abhängigkeit zwischen Zufallsvariablen misst, sind sowohl der Kendallsche als auch der Spearmansche Rangkorrelationskoeffizient in der Lage, den Grad monotoner Abhängigkeiten zu messen.

46Vgl. [3] S.20

Der folgende Satz liefert die wichtigsten Eigenschaften der Rangkorrelation und verdeutlicht die Unterschiede zur linearen Korrelation.

Satz 3.3. 47

Seien X und Y Zufallsvariablen mit den Randverteilungen F1 und F2, gemeinsamer Verteilungs- funktion F und Copula C. Dann gilt:

1. ρS(X, Y) =ρS(Y, X) und ρτ(X, Y) =ρτ(Y, X) 2. X und Y unabhängig ⇒ ρS(X, Y) =ρτ(X, Y) = 0 3. −1≤ρS(X, Y), ρτ(X, Y)≤+1

4. ρS(X, Y) = 12·R1 0

R1

0(C(x, y)−x·y)dxdy 5. ρτ(X, Y) = 4·R1

0

R1

0 C(u, v)dC(u, v)−1

6. ρS undρτ sind invariant unter streng monotonen Transformationen T :R→R, d.h.

δ(T(X), Y) =

(δ(X, Y) falls T steigend

−δ(X, Y) falls T fallend δ ∈ {ρS, ρτ} 7. ρS(X, Y) =ρτ(X, Y) = 1 ⇔ C =Co

8. ρS(X, Y) =ρτ(X, Y) =−1 ⇔ C =Cu

Die Punkte 1, 2 und 3 sind Eigenschaften, die wir bereits von dem linearen Korrelationskoeffizien- ten kennen. Interessant sind daher vor allen Dingen die übrigen Punkte, die allesamt wünschens- werte Eigenschaften an ein Abhängigkeitsmaß darstellen, welche der lineare Korrelationskoeffizi- ent nicht erfüllen kann. Der größte Vorteil der Rangkorrelation gegenüber der linearen Korrelation ist, dass die beiden Rangkorrelationskoeffizienten ausschließlich von der zu den Zufallsvariablen gehörigen Copula abhängen (Eigenschaft 4 bzw. 5) und daher auch sie invariant unter streng mo- notonen Transformationen sind. Des Weiteren ermöglichen die Eigenschaften 7 und 8 eine elegante Messung perfekter Abhängigkeit. Der größte Nachteil ist, dass es sich im Gegensatz zur linearen Korrelation, die unmittelbar von der Varianz und der Kovarianz abhängt, bei den Rangkorrelati- onskoeffizienten nicht um eine momentbasierte Korrelation handelt.

3.2.3 Tail Abhängigkeit

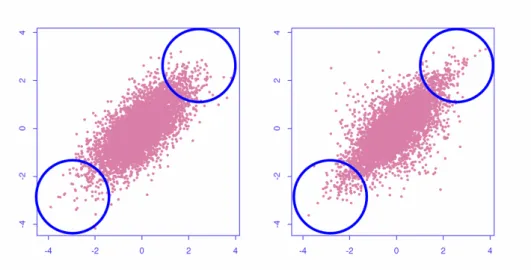

Eine Fragestellung, die im Risikomanagement von großer Bedeutung ist, beschäftigt sich damit, die Wahrscheinlichkeit für das gleichzeitige Eintreten mehrerer extremer Ereignisse anzugeben. Anders als bei den bisher vorgestellten Maßzahlen, bei denen das Ziel war die gesamte Abhängigkeit zwischen zwei ZufallsvariablenX undY auszudrücken, geht es im Rahmen der Tail Abhängigkeit vielmehr darum Maßzahlen für die Abhängigkeit von extremen Ereignissen zu bestimmen.48Wie Abbildung 3.2 verdeutlicht, geht es also um die Frage, wie die Abhängigkeitsstruktur in den Randbereichen einer Verteilung in Form einer geeigneten Maßzahl formuliert werden kann.

47[2] S. 16

48Vgl. [1] S. 280

Abbildung 3.2: Realisationen zweier Zufallsvariablen mit identischer Randverteilung und gleicher Korrelation, aber unterschiedlicher Abhängigkeitsstruktur. Die Tails sind anhand der Kreise zu erkennen.49

3.2.3.1 Definition der Tail Abhängigkeit

Seien im Folgenden also zwei Zufallsvariablen X und Y (die beispielsweise Risiken modellieren) sowie deren stetige Randverteilungen F1 und F2 gegeben. Man interessiert sich für die bedingte WahrscheinlichkeitP(X≤a|Y ≤b), dass RisikoX höchstens zu einem Verlust vonaführt, unter der Bedingung, dass Risiko Y höchstens einen Verlust von b erleidet.50 Das kann bekanntlich folgendermaßen formuliert werden:

P(X≤a|Y ≤b) = P(X≤a, Y ≤b) P(Y ≤b) .

Bei bekannter CopulaC von X undY ist es nach dem Satz von Sklar möglich, eine gemeinsame Verteilungsfunktion F zu finden, dieF1 und F2 als Randverteilungen besitzt:

P(X ≤a|Y ≤b) = C(F1(a), F2(b)) F2(b) .

O.B.d.A. treten die EreignisseX ≤abzw.Y ≤b mit derselben Wahrscheinlichkeitα ein d.h.:

α=P(X ≤a) =F1(a) und α=P(Y ≤b) =F2(b).

Aufgrund der Stetigkeit der Randverteilungen folgt damit:

a=F1−1(α)und b=F2−1(α).

Es gilt also:

P(X≤a|Y ≤b) = C(F1(F1−1(α)), F2(F2−1(α)))

F2(F2−1(α)) = C(α, α)

α .

Wird nun der Grenzwert für α →0 gebildet (falls dieser existiert), so ergibt sich ergibt sich der untere Tail-Abhängigkeitskoeffizient als Grenzwert.

49Quelle: [3] S.4

50Vgl. [1] S. 280

Definition 3.13. 51 Seien X und Y zwei stetige Zufallsvariablen. Bei bekannter Copula C ergibt sich der untere Tail-Abhängigkeitskoeffizient als:

λL= lim

α→0

C(α, α)

α ,

wenn der Grenzwert existiert und λL∈[0,1] ist.

Mit Hilfe des unteren Tail-Abhängigkeitskoeffizienten können nun Aussagen über die Wahrschein- lichkeit gemacht werden, dass RisikoX höchstens zu einem Verlust von aführt, unter der Bedin- gung, dass RisikoY höchstens einen Verlust vonberleidet. Ist es hingegen das Ziel, Aussagen über die Wahrscheinlichkeit zu erhalten, dass das RisikoX einen sehr hohen Verlust erleidet (X > a) unter der Bedingung, dass auch RisikoY einen hohen Verlust verursacht hat (Y > b), so wird der obere Tail-Abhängigkeitskoeffizient benötigt. Dieser kann sehr ähnlich hergeleitet werden. Jedoch wird zunächst einmal die Aussage des folgenden Satzes benötigt.

Satz 3.4. 52 Seien zwei Zufallsvariablen X undY gegeben. Dann gilt:

P(X > a|Y > b) = 1−P(X≤a)−P(Y ≤b) +P(X≤a, Y ≤b).

Damit folgt unmittelbar:

P(X > a|Y > b) = P(X > a, Y > b)

P(Y > b) = 1−P(X≤a)−P(Y ≤b) +P(X≤a, Y ≤b)

1−P(Y ≤b) .

Äquivalent zu den obigen Ausführungen ist dann wieder:

α=P(X ≤a) =F1(a) und α=P(Y ≤b) =F2(b).

und aufgrund der Stetigkeit der Randverteilungen somit:

a=F1−1(α)und b=F2−1(α).

Also in Copula-Schreibweise:

1−P(X≤a)

| {z }

α

−P(Y ≤b)

| {z }

α

+P(X≤a, Y ≤b)

| {z }

C(α,α)

1−P(Y ≤b)

| {z }

α

.

Wird der Grenzwert fürα →1 gebildet (falls dieser existiert), so ergibt sich ergibt sich der obere Tail-Abhängigkeitskoeffizient als Grenzwert.

Definition 3.14. 53 Seien X und Y zwei stetige Zufallsvariablen. Bei bekannter Copula C ergibt sich der obere Tail-Abhängigkeitskoeffizient als:

λU = lim

α→1

1−2α+C(α, α)

1−α ,

falls der Grenzwert existiert und λU ∈[0,1] ist.

51Vgl. [1] S. 281

52Vgl. [1] S. 283

53Vgl. [1] S. 281

Bemerkung 3.8. 54

• λL= 0 bedeutet asymptotische Unabhängigkeit im unteren Tail.

• λU = 0 bedeutet asymptotische Unabhängigkeit im oberen Tail.

• λL∈(0,1]weist auf Abhängigkeit im unteren Tail hin.

• λU ∈(0,1]weist auf Abhängigkeit im oberen Tail hin.

• Je größerλL(bzw.λU) ist, desto größer ist die Abhängigkeit im unteren (bzw. oberen) Tail.

Bemerkung 3.9. 55

• Die Tail Abhängigkeit hängt ausschließlich von der Copula ab. Die Invarianz unter streng monoton steigenden Transformationen überträgt sich daher, genau wie bei der Rangkorre- lation, von der Copula auf die Tail Abhängigkeit.

• Die Abhängigkeiten in den Tails werden durch verschiedene Copulas in unterschiedlicher Art und Weise modelliert. So existieren beispielsweise Copulas, welche Abhängigkeit im unteren Tail besitzen und solche, die im unteren Tail asymptotische Unabhängigkeit modellieren.

Bei der Wahl eines geeigneten Copula-Modells ist das Tail-Verhalten der entsprechenden Copula ein entscheidender Auswahlfaktor, insbesondere dann, wenn die Wahrscheinlichkeit für gemeinsam auftretende extreme Ereignisse relativ groß ist.

3.2.3.2 Tail-Abhängigkeitskoeffizienten für Beispiel-Copulas

Wie in Bemerkung 3.9 beschrieben wurde, kann die Tail-Abhängigkeit für verschiedene Copulas sehr unterschiedlich ausfallen. In diesem Abschnitt sollen einige Tail-Abhängigkeitskoeffizienten beispielhaft dargestellt werden.56Die Unterschiede in der Modellierung der Tails bei den verschie- denen Copulas werden dadurch ersichtlich.

Unabhängigkeits-Copula: Für die Unabhängigkeits-Copula gilt:

λL= 0 und λU = 0.

Dies ist nicht weiter verwunderlich, da es bedeutet, dass die Unabhängigkeits-Copula auch asym- ptotische Unabhängigkeit in den Tails modelliert.

Komonotonie-Copula: Für die Komonotonie-Copula gilt:

λL= 1 und λU = 1.

Auch dies ist logisch, da es bedeutet, dass die Komonotonie-Copula auch asymptotisch totale Abhängigkeit erzeugt.

Kontramonotonie-Copula: Für die Kontramonotonie-Copula gilt:

λL= 0 und λU = 0.

Sie modelliert also asymptotische Unabhängigkeit.

54Vgl. [1] S. 281

55Vgl. [4] S. 48

56Vgl. [1] S. 281 und [2] S. 18-19

Gauß-Copula: Ist der Korrelationskoeffizientρ6=|1|, so gilt für die Gauß-Copula:

λL= 0 und λU = 0.

Das bedeutet aber, dass selbst dann, wenn zwei Risiken durch die Gauß-Copula mit extrem starker Korrelation (aber ρ 6= |1|) gekoppelt sind, extreme Verluste nahezu unabhängig in den beiden Risiken eintreten. „Insofern eignet sich die Gauß-Copula nicht zur Modellierung von Risiken, die eine Tail-Abhängigkeit besitzen.“57

Gumbel-Copula: Für die Gumbel-Copula mit ParameterΘ∈(0,1]gilt:

λL= 0 undλU = 2−2Θ.

Während im unteren Tail also asymptotische Unabhängigkeit vorliegt, liegt im oberen Tail für Θ<1asymptotische Abhängigkeit vor. FürΘ→0strebt der obere Tail-Abhängigkeitskoeffizient gegen 1.

3.2.4 Konkordanz

Die Konkordanz zeichnet sich durch eine etwas andere Sichtweise auf Abhängigkeiten zwischen ZufallsvariablenX undY aus als es bei den bisher vorgestellten Maßen der Fall war. Hier geht es nicht darum die Stärke der Abhängigkeit festzustellen, sondern einzig und allein darum anzugeben ob die Abhängigkeit zwischen X und Y positiv oder negativ ist. Im Falle positiver Abhängigkeit spricht man von Konkordanz, bei negativer Abhängigkeit hingegen von Diskordanz.58

Grundsätzlich stellt sich an dieser Stelle die Frage, wie eine positive (bzw. negative) Abhängigkeit überhaupt definiert werden kann. Aus den bisherigen Ausführungen dieser Arbeit könnte man sich vorstellen, dass beispielsweise positive Abhängigkeit genau dann vorliegt, wennρ(X, Y)>0(oder ρS(X, Y) > 0 bzw. ρτ(X, Y) > 0) ist. In der Regel wird positive (bzw. negative) Abhängigkeit jedoch anders definiert. Zwei solcher Konzepte werden im Folgenden vorgestellt.59

Definition 3.15. 60 Zwei Zufallsvariablen X und Y werden positiv quadrant abhängig (PQA) genannt, wenn für alle x, y∈R gilt:

P(X≤x, Y ≤y)≥P(X≤x)·P(Y ≤y).

Bemerkung 3.10. 61

• Positive quadrant Abhängigkeit ist ein geeignetes Konzept um positive Abhängigkeit zwi- schen ZufallsvariablenXundY auszudrücken, daX undY mit höherer Wahrscheinlichkeit beide große (bzw. kleine) Werte annehmen als im Falle der Unabhängigkeit zwischenX und Y.

• Wird die Ungleichung in Definition 3.15 umgekehrt, so spricht man von negativ quadrant abhängigen Zufallsvariablen.

57[1] S. 281

58Vgl. [2] S. 20

59Vgl. [2] S. 20

60Vgl. [2] S. 20

61Vgl. [5] S. 145

Definition 3.16. 62 Zwei Zufallsvariablen X und Y werden positiv assoziiert (PA) genannt, wenn für alle reellwertigen, messbaren Funktionen g1 und g2, die monoton steigend in beiden Komponenten sind und für die die nachfolgenden Erwartungswerte definiert sind, gilt:

E(g1(X, Y)·g2(X, Y))≥E(g1(X, Y))·E(g2(X, Y)).

Bemerkung 3.11. 63

• Die obige Definition für (PA) ist äquivalent zu:

Cov(g1(X, Y), g2(X, Y))≥0.

Dies macht deutlich, dass auch die Positive Assoziation ein geeignetes Konzept darstellt, um positive Abhängigkeit zwischen ZufallsvariablenX und Y zu beschreiben.

• Wird die Ungleichung in Definition 3.16 umgekehrt, so spricht man von negativ assoziierten Zufallsvariablen.

Bemerkung 3.12. 64

• Sowohl (PQA), als auch (PA) sind, genau wie die Rangkorrelation und die Tail Abhängigkeit, invariant unter monoton steigenden Transformationen.

• (PQA) und (PA) sind stärkere Bedingungen an die Abhängigkeit zwischen Zufallsvaria- blen als die bereits bekannten Korrelationskoeffizienten. Dies wird auch durch die folgende Darstellung geschildert, die ebenfalls ausdrückt, dass Komonotonie die stärkste Form von Konkordanz bzw. positiver Abhängigkeit ist:

Komonotonie ⇒ (PA)⇒(PQA)⇒ ρ(X, Y)≥0, ρS(X, Y)≥0, ρτ(X, Y)≥0

62Vgl. [2] S. 20

63Vgl. [5] S. 144

64Vgl. [2] S. 21

4 Irrtümer bzgl. Korrelation und Abhängigkeit

Abschließend sollen in diesem Kapitel drei bekannte Irrtümer bzgl. Korrelation und Abhängigkeit klargestellt werden. Dazu wird - mit Hilfe des Wissens aus den vorherigen Kapiteln - zu jedem dieser Irrtümern ein Gegenbeispiel konstruiert. Hierbei werden immer zwei ZufallsvariablenXund Y mit RandverteilungenF1 undF2 und gemeinsamer Verteilungsfunktion F betrachtet.

4.1 Irrtum 1

„Die gemeinsame Verteilungsfunktion F kann mithilfe der Randverteilungen F1 und F2 und der Korrelation zwischen den ZufallsvariablenX und Y bestimmt werden.“

Betrachtet man bloß elliptische Verteilungen oder die multivariate Normalverteilung so stellt man fest, dass diese Aussage hier durchaus gilt. Problematisch wird es aber wenn man diese spezielle Gruppe von Verteilungen verlässt. Wie Abbildung 3.1 schon zeigen konnte ist es möglich zwei Paare von Zufallsvariablen mit identischen Randverteilung und gleicher Korrelation zu entwerfen, deren Abhängigkeitsstruktur sich unterscheidet.

Ein konkretes Beispiel hierfür ist das folgende.

Beispiel 4.1. 65

Wir betrachten hierfür zwei verschiedene gemeinsame Verteilungen mit Gamma(3,1)-Randverteilungen (G3,1) und derselben Korrelation ρ= 0,7. Diese Eigenschaften können wir sowohl mit der Gauß- als auch mit der Gumbel-Copula erreichen, wenn wir die Parameter ρbzw.θ(Vgl. Abschnitt 2.4) geeignet wählen. So erhalten wir

FGa(x, y) =CGaρ (G3,1(x), G3,1(y)) FGu(x, y) =CθGu(G3,1(x), G3,1(y))

mit ρ = 0,71 und θ = 0,54. Diese Werte kann man anhand einer stochastischen Simulation errechnen.66

Aus Abschnitt 3.2.3.2 wissen wir, dass die beiden Copulas unterschiedliche Tail-Abhängigkeiten besitzen. Während die Gauß-Copula keine Tail-Abhängigkeiten aufweist, ist die Gumbel-Copula für θ < 1 asymptotisch abhängig. Um das zu verdeutlichen betrachten wir die bedingte Wahr- scheinlichkeitP[X > u|Y > u]mitu=V aR0,99(X) =V aR0,99(Y) =G−13,1(0,99)unter den beiden Modellen.

Nach einer empirischen Schätzung gilt ungefähr

PFGa[X > u|Y > u] = 1/3 PFGu[X > u|Y > u] = 3/4.

Es zeigt sich also, dass es im Gumbel-Modell deutlich wahrscheinlicher ist, dass auch das zweite Risiko die Schwelleu überschreitet, wenn sie vom ersten Risiko überschritten wurde. Es gibt also weniger Diversifikation im Gumbel-Modell.67

65Vgl. [2] S. 22

66[2] S. 22

67[2] S. 23

Analytisch eine Aussage über den VaR der Summe X+Y unter den beiden Modellen zu treffen ist schwierig, aber anhand von Simulationen lässt sich belegen, dass das Gumbel-Modell eine höhere Anzahl an großen Resultaten für den VaR liefert.68Gerade wenn es um die Einschätzung von extremen Verlusten geht, gibt es also einen entscheidenden Unterschied zwischen den beiden Modellen, der sich in den Randverteilungen und der Korrelation nicht bemerkbar macht.

4.2 Irrtum 2

„Seien F1 undF2 gegeben. Die lineare Korrelation zwischen X undY kann - bei einer geeigneten Spezifikation von F - alle Korrelationen zwischen -1 und 1 annehmen.“

Diese Aussage ist nicht wahr, wie das folgende Gegenbeispiel beweist.

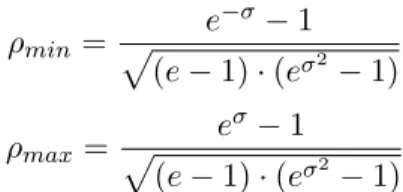

Beispiel 4.2. 69

Sei X ∼ LN(0,1) und Y ∼ LN(0, σ2) mit σ > 0. Wir sind nun an dem minimalen Wert ρmin

und dem maximalen Wert ρmax interessiert, den die Korrelation unter diesen Randverteilungen annehmen kann.

Da ρmin = ρ(eZ, e−σZ) und ρmax = ρ(eZ, eσZ) mit Z ∼ N(0,1) gilt, lassen sich diese Werte analytisch bestimmen als:

ρmin = e−σ−1 p(e−1)·(eσ2 −1)

ρmax = eσ−1 p(e−1)·(eσ2 −1)

Die folgende Grafik zeigt die Werte vonρmin und ρmax für verschiedeneσ-Werte.

-1 -0,8 -0,6 -0,4 -0,2 0 0,2 0,4 0,6 0,8 1

1 2 3 4 5

Korrelation

sigma

minimale Korrelation maximale Korrelation

Abbildung 4.1: ρmin und ρmax für verschiedene σ-Werte.70

68[2] S. 23

69Vgl. [2] S. 24

70Vgl. [2] S. 25