2. Workshop

Unbemannte autonom fliegende Systeme (UAS) in der Landwirtschaft

6. – 7. Mai 2013, Berlin

Bornimer Agrartechnische Berichte

Heft 81

19. Workshop Computer-Bildanalyse in der Landwirtschaft

2. Workshop Unbemannte autonom fliegende Systeme (UAS) in der

Landwirtschaft

6. – 7. Mai 2013, Berlin

Bornimer Agrartechnische Berichte Heft 81

Potsdam-Bornim / Berlin 2013

Herausgeber:

Leibniz-Institut für Agrartechnik Potsdam-Bornim e.V.

Max-Eyth-Allee 100 14469 Potsdam-Bornim

(0331)-5699-0 Fax.: (0331)-5699-849 E-mail: atb@atb-potsdam.de Internet: http://www.atb-potsdam.de

April 2013

Redaktion:

Prof. Dr. habil. Manuela Zude

Typografische Gestaltung:

Andrea Gabbert

Herausgegeben vom Leibniz-Institut für Agrartechnik Potsdam-Bornim e.V. (ATB) mit Förderung durch den Bund (Bundesministerium für Ernährung, Landwirtschaft und Verbraucherschutz BMELV), das Land Brandenburg (Ministerium für Wissenschaft, Forschung und Kultur MWFK).

Für den Inhalt der Beiträge zeichnen die Autoren verantwortlich.

Eine Weiterveröffentlichung von Teilen ist unter Quellenangabe und mit Zustimmung des Leibniz- Instituts für Agrartechnik Potsdam-Bornim e.V. möglich.

ISSN 0947-7314

© Leibniz-Institut für Agrartechnik Potsdam-Bornim e.V., 2013

Bornimer Agrartechnische Berichte Heft 81

Vorwort

Der methodologische und anwendungsorientierte Austausch zur Computergestützten Bildverarbeitung in der Agrarwirtschaft (CBA) war 1995 das Ziel, als die CBA- Workshop-Reihe von der Ressortforschung des Bundes ins Leben gerufen wurde.

Gastgeber waren wechselnde Forschungsinstitutionen in Deutschland. Die Themen umfassten landwirtschaftliche Fragestellungen von der molekularen und mikroskopi- schen Ebene bis zur räumlichen Analyse großer Landschaftsgebiete.

Durch diese große thematische Bandbreite gab und gibt es Überschneidungen zu ande- ren Arbeitsbereichen. Daher zählt es zur Tradition des CBA-Workshop Veranstaltung zusammen mit andern Arbeitskreisen durchzuführen. Beispielsweise wurde 2007 der 13. CBA-Workshop zusammen mit dem 4. Workshop Precision Farming gemeinsam in Hohenheim abgehalten. Ein gemeinsamer Workshop mit internationalen Arbeitsgruppen fand 2009 statt, als der 15. CBA-Workshop mit dem 1. Workshop der CIGR-Working Group Image Analysis for Agricultural Processes and Products (www2.atb- potsdam.de/CIGR-ImageAnalysis/) am ATB in Potsdam durchgeführt wurde. Und auch in diesem Jahr freuen wir uns auf eine gemeinsame Veranstaltung – mit den Arbeits- gruppen zum Einsatz von unbemannten Flugsystemen in der Landwirtschaft. Der Work- shop zum Einsatz von Unmanned Aerial Systems (UAS) in der Landwirtschaft ist ver- gleichsweise jung. Er wurde erstmals 2012 von der Humboldt-Universität zu Berlin und dem ATB ausgerichtet. Die Veranstaltung fand großen Zuspruch aus dem deutschspra- chigen Raum. Da bei der Datengewinnung durch UAS überwiegend optische Sensoren zum Einsatz kommen, lag es nahe, den CBA- und den UAS-Workshop zu verbinden.

In 2013 wird der 19. CBA-Workshop und 2. UAS-Workshop gemeinsam von dem Leib- niz-Institut für Agrartechnik Potsdam-Bornim e.V. (ATB) und der Beuth Hochschule für Technik Berlin (Beuth HS) ausgerichtet. Zum Organisations-Komitee gehören Professor Michael Breuer, Harald Herda, Professor Dr. Karl-Heinz Strauch, Dr. Robin Gebbers, Andrea Gabbert, Professor Dr. Manuela Zude. Die Nutzung der Bildverarbeitung für die Steuerung und Datenerhebung sowie die radiometrische Auswertung wird wie schon in der Vergangenheit einen Schwerpunkt einnehmen. Phänotyping ist ein weiterer Schwerpunkt. Besonders gespannt sehen wir den Firmenpräsentationen entgegen, die einen Innenhof der Beuth HS für Flugvorführungen nutzen werden.

Robin Gebbers Manuela Zude

Potsdam, den 22.04.2013

- - -

CiS GmbHHansestr. 21 18182 Bentwisch

bei Rostock

Telefon:

Fax:

Email:

Internet:

0381 /6302 700 0381 /6302 730 info@cis-rostock.de www.cis-rostock.de

CiS GmbH - DAS UNTERNEHMEN

Die CiS GmbH kann auf eine über 30-jährige Tradition bei der Arbeit mit graphischen und geographischen Informationssystemen verweisen.

Das Unternehmen mit seinen 20 Mitarbeitern konzentriert sich auf die Konzeption, Entwick- lung und Realisierung von

• Geographischen Informationssystemen - GIS

• Informationssystemen für Leitungsnetze - NIS

• Betriebsmittelinformationssystemen BIS sowie den dazugehörigen Dienstleistungen

UAS - KOMPLETT-SYSTEM aus TECHNIK und SOFTWARE

Flächenflieger Oktokopter

mit CiS - Autopilot, ... mit Fuji Finepix F600 EXR

'

Applikationskarte

• Befliegung mit gesteuerter Bildaufnahme zur Fernerkundung größerer Flächen

• Schadensdokumentation und Biomassekartierung in der Landwirtschaft

• Monitoring in der Forstwirtschaft

• Zustandsermittlung und Inspektion von technischen Anlagen und Gebäuden, z.B. Fern- wärmeleitungen

• Baustellenplanung und Fortschrittskontrolle

UAS - LEISTUNGSSPEKTRUM im AGRARBEREICH

• Anfertigung und Lieferung kompletter Flugplattformen inkl. kalibrierter Farb- und Infra- rotkameras und sämtlichem Zubehör

• individuelle Anpassung an spezielle Einsatzmöglichkeiten

• Software UAV mobile und UAV GIS

• weiterführende Software: Agrar-Managementsystem ADAM inkl. Applikationskarten- erstellung, Gerätesteuerungs- und Protokollierung ANVINA

• Befliegung und Biomassekartierung in Dienstleistung

• 2-tägige Fluglehrgänge

a

100,- EUR pro Teilnehmer• praktische Demonstration von Befliegungen mit Flächenflieger bei Interesse auch individuell im Anschluss an den Workshop

HE XAlP llOlf$

DIE VIEDEO F LUG SPEZIALISTEN

VIDEO / PHOTO HIGHSPEED

INSPEl<TION

DOl<UMENrATION

THERMOGRAFIE SENSORII<

l<LIMATOLOGIE METEOROLOGIE

ÜBERWACHUNG SCHADENAUFNAHME

www.hexapilots.de

c __

c

by conquering sky

Mit der md4-1000 bietet die microdrones GmbH eine zukunftsweisende Technologie für die Vermessung und Kartierung aus der Luft. Unsere intelligenten GIS UAV-Plattformen fi nden Einsatz in allen Bereichen der Geodäsie, Geoinformatik und der Fotogrammetrie. Mit bis zu 88 Minuten Flugzeit ist die md4-1000 Ihr leistungsstarker und präziser Assistent – zu 100% verlässlich.

md4-1000. Hat Ausdauer.

www.microdrones.com

md4-1000 fl iegt länger

▶ Automatische GPS Wegpunkt Navigation

▶ Auto-Start / Auto-Landing / Auto-Homing

▶ Flexibles Nutzlastkonzept: Multi- oder Hyperspektral, Thermal u.v.m.

▶ Wetterfest, Geräuscharm, Umweltfreundlich

WWW.OCEANOPTICS.EU

Handthermometer

Hochwertige tragbare Infrarot-Thermometer mit integrierter USB-Schnittstelle

Infrarotkameras

Kompakte Wärmebildkameras für schnelle Onlineanwendungen, inklusive Linescanner Einsatz in beengten sowie heißen Umgebungen Leistung sowie Doppellaser

Marktneuheit: optris PI LightWeight

Erstmals ist es möglich, radiometrische Infrarot-Videos in hoher Qualität aus der Luft aufzunehmen und zu bearbeiten.

Flug-Video und weitere Informationen unter

www.optris.de/pi-lightweight

Kompakte Wärmebildkameras für schnelle Onlineanwendungen, inklusive Linescanner

Marktneuheit: optris PI LightWeight

Erstmals ist es möglich, radiometrische Infrarot-Videos in hoher Qualität aus der Luft aufzunehmen und zu bearbeiten.

Erstmals ist es möglich, radiometrische

Infrarot-Videos in hoher Qualität aus der

Luft aufzunehmen und zu bearbeiten.

Programm

19. CBA-Workshop und 2. UAS–Workshop, 6.–7. Mai 2013, Berlin

Montag, 06. Mai 2013

10:00 – 11:00 Registrierung

Willkommen (Manuela Zude)

11:00 – 11:10 Prof. Dr. Karl-Heinz Strauch, Dekan FB5, Beuth Hochschule Prof. Michael Breuer, FB3, Beuth Hochschule

Dr. Robin Gebbers, Forschungskoordinator FP1, Leibniz-Institut für Agrar- technik Potsdam-Bornim (ATB)

Moderation Michael Breuer

11:10 – 11:30 UAS zur hochgenauen und flächenhaften Bestimmung der Bestandshöhe bzw. Biomasse

Görres Grenzdörffer

11:30 – 11:50 Kombinierte Pfad- und Trajektorienplanung für autonome mobile Roboter Janko Petereit, Thomas Emter

11:50 – 12:10 Volumenbestimmung von Hühnereiern aus Kameraaufnahmen im Stall Bernhard Lang, Jürgen Biermann

12:10 – 12:30 Mensch-Maschine-Schnittstelle zur Bildverarbeitung im Remote Farming Wolfram Strothmann, Arnd Kielhorn, Fabian Sellmann, Kim Möller, Martin Hänsel, Dieter Trautz, Arno Ruckelshausen

12:30 – 13:30 Mittagspause Moderation Robin Gebbers

13:30 – 13:50 Einsatz von Multikoptertechnik in Forschung und Wissenschaft Axel Weckschmied, Andreas Thomas

13:50 – 14:10 Agricopter – Micro UAV basiertes System zur Erstellung von georeferenzier- ten orthofotos in VIS+NIR

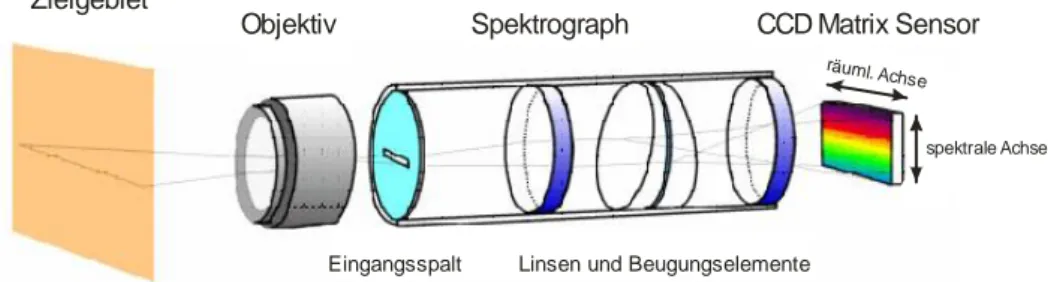

Ferry Bachmann, Ruprecht Herbst, Robin Gebbers, Verena V. Hafner 14:10 – 14:30 Von multispektraler zu hyperspektraler Fernerkundung mit dem UAS „Stutt-

garter Adler“

Axel Büttner, Hans-Peter Röser 14:30 – 15:00 Kaffeepause / Poster

Moderation Görres Grenzdörffer

15:00 – 15:20 Gut geplant ist halb geflogen - UAV Flugplanung, Navigation und Postpro- cessing

Hansjörg Ragg, Hannes Kleindienst

15:20 – 15:40 Rehkitzrettung mit dem Fliegenden Wildretter: Erfahrungen der ersten Feld- einsätze

Tilman Wimmer, Martin Israel, Peter Haschberger, Anita Weimann

Bornimer Agrartechnische Berichte Heft 81

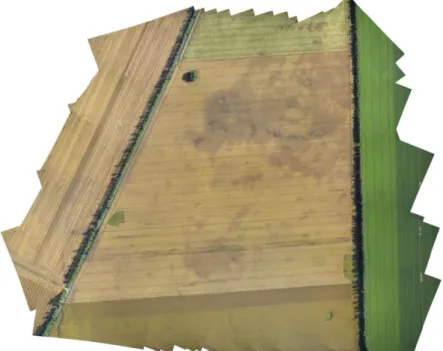

15:40 – 16:00 Erstellung von RGB-Luftbildern mit einer Drohne für die Standort- spezifische Landbewirtschaftung (Precision Farming)

Eike Stefan Dobers

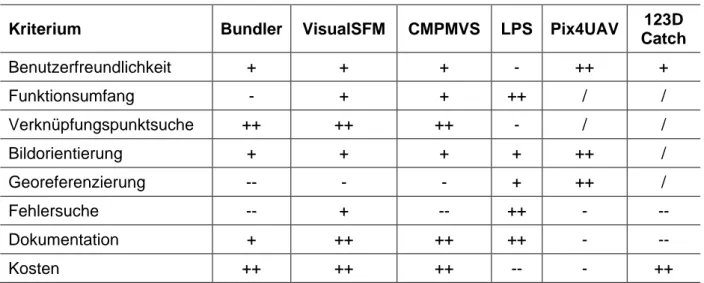

16:00 – 16:20 Auswerteoptionen für Drohnenluftbilder - Versuch einer Bewertung Harald Herda, Michael Breuer

16:20 – 16:50 Kaffeepause Moderation Andreas Linz

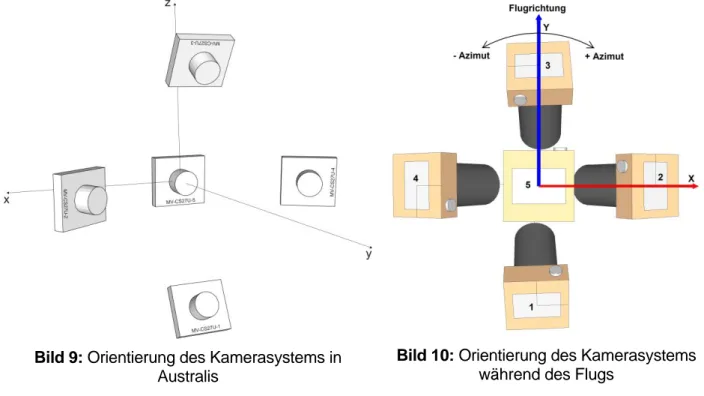

16:50 – 17:10 Konzept und Kalibrierung eines Mehrkamerasystems mit schrägblickenden Kameras für den UAS-Einsatz

Frank Niemeyer, Robert Schima, Arne Neiser

17:10 – 17:30 Geometrische Abbildungsqualität von UAV geeigneten Sensoren im Bereich des nahen Infrarots

Ralf Gehrke, Ansgar Greiwe

17:30 – 17:50 Re-Identifikation von oberflächlichen sowie sub-epidermalen Lasermarkie- rungen von Pflanzen und Früchten

Christian Marx, Michael Schultz, Karolina Schymik, Thomas Rath

17:50 – 18:40 CiS GmbH, Bentwisch bei Rostock GRID-IT, Innsbruck, Österreich HEXAPILOTS, Dresden

microdrones, Siegen

Ocean Optics, Duiven, Niederlande Optris, Berlin

19:00 – 21:00 Abendessen

Dienstag, 07. Mai 2013

Moderation Martin Kähler

09:00 – 09:20 Erfassung des Stickstoffgehalts von Weizen aus bodengestützt erhobenen hyperspektralen Bilddaten

Bastian Siegmann, Thomas Jarmer, Holger Lilienthal, Nicole Richter, Thomas Selige, Bernhard Höfle

09:20 – 09:40 Nicht-scannende hyperspektrale Kamera für UAS Plattformen András Jung, René Michels, Rainer Graser

09:40 – 10:00 Hyperspectral reflectance measurements over agricultural crops by an UAV based ultra-light weight microspectrometer

Andreas Burkart, Sergio Cogliati, Uwe Rascher

10:00 – 10:20 Hyperspectral image analysis for automatic detection of plant diseases Anne-Katrin Mahlein, Mirwaes Wahabzada, Kristian Kersting, Ulrike Steiner, Erich-Christian Oerke

10:20 – 10:40 Tetracam Multispektralkameras – Funktion, Möglichkeiten und Einsatz Martin Herkommer, Christoph Schimmer

10:40 – 11:00 Kaffeepause

Moderation Thomas Rath

11:00 – 11:20 Chlorophyllfluoreszenz-basierte Bildanalyse zur Erkennung resistenter Sa- latsorten bei Bremia lactucae

Elke Bauriegel, Hanna Brabandt, Ute Gärber, Werner B. Herppich

11:20 – 11:40 Analyse der Gutentmischung auf dem Vorbereitungsboden im Mähdrescher mittels Hochgeschwindigkeitsaufnahmen

Martin Weis, Michael Schwarz, Stefan Böttinger

11:40 – 12:00 Semantische Objekterkennung mit Methoden des Maschinellen Lernens Falk Schmidsberger, Frieder Stolzenburg

12:00 – 12:20 Prozessierung, Katalogisierung und Verteilung von UAS-Bildern in Nah- Echtzeit

Irmi Runkel 12:20 – 13:20 Mittagspause Moderation Werner B. Herppich

13:20 – 13:40 Leistungsfähigkeit von Low-Cost RTK GNSS-Systemen zur genauen Positi- onsbestimmung von UAV-Anwendungen eventuell:

Werner Stempfhuber

13:40 – 14:00 Quantifizierung von Bodenfeuchte mittels hyperspektraler Fernerkundungs- daten

Daniel Spengler, Theres Kuester,Annett Frick, Sibylle Itzerott, Hermann Kaufmann

14:00 – 14:20 The Potential for UAV Technology to Assist in Sheep Herding in the Scottish Highlands

Marc-Alexandre Favier, Richard Green, Andreas Linz 14:20 – 14:50 Kaffeepause

Moderation Manuela Zude

14:50 – 15:10 Identification of maturation stages of coffee fruits in real time

Paula J. Ramos-Giraldo, Juan R. Sanz-Uribe, Carlos E. Oliveros-Tascón 15:10 – 15:30 PlantEye a novel 3D sensor platform for automated plant screening and

plant phenotyping

Grégoire Hummel, Maximiliano Pin, Nico Wagnitz, Uladzimir Zhokhavets 15:30 – 15:50 Automatische Parameterextraktion aus hochauflösenden Laserscans – ein

wichtiger Schritt bei der Phänotypisierung

Stefan Paulus,Jan Dupuis, Henrik Schumann, Heiner Kuhlmann 15:50 Abschlussdiskussion / Ende der Workshops

Bornimer Agrartechnische Berichte Heft 81

Poster

Entwicklung von Sensorsystemen zur Detektion von Rehkitzen in dichten Grasbeständen Nicole Berger, Hilmar Ingensand, Henri Eisenbeis, Pascal Theiler, Daniel Bäni, Daniel Lanz, Daniel Lüdi, Bernhard Streit

Analyse der potentiellen Photosyntheseaktivität als Grundlage einer objektiven Bremia lac- tucae-Resistenz-Bonitierung in der Salatzüchtung

Hanna Brabandt, Elke Bauriegel, Werner B. Herppich, Ute Gärber Multirotor- und Flächen-UAVs im Vergleich

Hannes Kleindienst, Hansjörg Ragg

Detailgetreue Oberflächenmodelle aus UAV-Daten Hansjörg Ragg, Hannes Kleindienst

Vergleich der Bestandstemperatur und des Ertrags von acht Winterweizensorten unter Tro- ckenstress: Ergebnisse eines Versuchsjahres

Martin Kraft, Heiko Neeland, Angela Riedel

Ein neues computergesteuertes Minirhizotron-System zur Erfassung von Wurzeln Maik Veste, Hans-Peter Schäfer, Rüdiger Harms, Gerhard Kast

Analysing vibration problems in drone copter based plant detection Maryam Fadami, Thomas Rath

Aufbau und Messtechnik des „Thüno-Copters“ zur berührungslosen Inspektion von Pflanzen- beständen: Erste Messungen mit einem Low-Cost-Computer-Bild-Analyse-System

Heiko Neeland, Martin Kraft

Automatische Erkennung von Wurzeln in Minirhizotron-Bildern: Anwendung von helligkeits- und texturbasierten Verfahren

Daniel Sachse, Danny Krüger, Martin Weigert, Gerhard Kast, Maik Veste

Frühe Erkennung von P. digitatum Infektion bei C. sinensis Früchten mit bildgebender multi- spektraler Rückstreumessung

Delia Lorente, José Blasco, Christian Regen, Manuela Zude

Zusammenhang von Thermografie-Bildern der Kronenoberfläche mit Ertragsparametern in einer Prunus domestica Produktionsanlage

Jana Käthner, Jörn Selbeck, Werner B. Herppich, Rolf Adamek, Manuela Zude Temperaturgrenzwerte für den CWSI unter Glas ermitteln

Markus Richter, Joshua Andres

UAS zur hochgenauen und flächenhaften Bestimmung der Bestandshöhe bzw. Biomasse

Görres Grenzdörffer

Universität Rostock, Professur für Geodäsie und Geoinformatik, J.-v. Liebig Weg 6, 18059 Rostock

Email: goerres.grenzdoerffer@uni-rostock.de

Zusammenfassung: Flächenhafte Informationen über die Wuchshöhe landwirtschaftli- cher Kulturen können für verschiedene Precision Farming Anwendungen und zur Er- tragsvorhersage eine wichtige Informationsquelle sein. 3D-Punktwolken hochauflösen- der UAS-Aufnahmen können diese Lücke vielleicht schließen. Es werden zwei ver- schiedene Methoden der Bestandshöhenermittlung methodisch erläutert und anhand praktischer Beispiele vorgestellt.

Deskriptoren: Bestandshöhe, UAS, Photogrammetrie, 3D-Punktwolke, Geostatistik

Summary: The accurate determination of the height of agricultural crops helps to pre- dict corn yield at early development stages. However there is no cost efficient and au- tomatic system for the determination of the crop height available. 3D-point clouds gen- erated from high resolution UAS imagery offer a new alternative. Two different ap- proaches for crop height determination are presented.

Keywords: crop height, UAS, Photogrammetry, 3D-point cloud geo statistics

1 Einleitung

Die Bestimmung der Wuchshöhe landwirtschaftlicher Kulturen ist in mehrerer Hinsicht von großer Bedeutung. Zum Beispiel lässt die Entwicklung der Wuchshöhe von Mais sehr gute Rückschlüsse auf die kommenden Ernteerträge zu, z.B. SAMMIS et al. 2008, YIN et al. 2011. Ähnliche, wenn auch weniger eindeutige Beziehungen ist für Winterge- treide beobachtet worden, z.B. GIRMA et al. 2006. Grundsätzlich bestehen statistisch enge Beziehungen zwischen der Wuchshöhe und der Biomasse, z.B. EHLERT et al.

2009, SHRESTHA et al. 2002. Diese Zusammenhänge sind nicht für den Pflanzenbau sondern auch bei der Grünlandbewirtschaftung von großer Bedeutung. Leider geschieht die Messung der Bestandshöhe oftmals noch visuell, manuell, bzw. teilautomatisiert.

Zur Messung der Bestandshöhe mit Hilfe eines Fahrzeuges (Traktor) sind verschiedene Technologien ausprobiert worden, z.B. Ultraschall, Radarentfernungsmesser, Stereo- kamerasysteme und Laserscanner. Unabhängig von der eingesetzten Sensorik sind die Anforderungen an traktorbasierte Technologien hoch. So sollte die Bestandshöhe mit einer Genauigkeit von ca. 1 cm und am besten unabhängig von den äußeren Bedin-

Bornimer Agrartechnische Berichte Heft 81

gungen, d.h. Staub, Vibrationen und Sonnenstand bestimmt werden können. EHLERT et al. 2009 haben grundsätzlich gezeigt, dass z.B. Laserscanner in der Lage sind, diese Anforderungen zu erfüllen. Für die Grünlandbewirtschaftung ist das PastureMeter1 kommerziell verfügbar. Jedoch sind traktorbasierte Systeme nur in der Lage innerhalb bzw. eng umgrenzt um die Fahrgassen die Bestandshöhe zu messen und damit lassen sich leider flächenhaften Aussagen nur über Interpolation für den gesamten Bestand treffen. Dies ist vor allem unter dem Gesichtspunkt der immer größerer werdenden Fahrgassenabständen kritisch zu sehen. Aufgrund der ungleichmäßigen Punktvertei- lung entlang der Fahrgassen fallen einfache Interpolationsansätze, wie z.B. Nearest Neighbor oder Inverse Distance aus. Vielmehr sind geostatistische Ansätze gefragt.

Aus geostatistischen Überlegungen heraus reicht die hohe Punktmessgenauigkeit von 1 cm in der Fahrgasse bei hügeligem Gelände und Fahrgassenabständen von 18 – 24 m in der Fläche nur für Genauigkeiten von 10 - 15 cm, vgl. z.B. SCHMIDT 2003.

2 Photogrammetrische Höhenbestimmung

Die Bestimmung eines Oberflächenmodells mit Hilfe photogrammetrischer Methoden hat sich in den letzten Jahren drastisch verbessert. Durch die so genannte "Dense Mat- ching" Verfahren kann aus Luftbildern quasi für jedes Pixel ein Koordinatentriplet be- rechnet werden, z.B. STRECHA 2011. Die Punktwolke besteht aus (farbigen) Punkten mit X, Y, Z Koordinaten, die zusammen die Oberfläche des Objektes beschreiben.

Aus der klassischen Photogrammetrie gibt es Faustwerte von 0,015 - 0,02% der Flug- höhe für die Höhengenauigkeit photogrammetrischer Punktbestimmungen. Dieser Wert beruht auf der Verwendung hochgenauer weitwinkeliger Kameras und Senkrechtauf- nahmen mit einer Längsüberlappung von 60% (Standardnormalfall). Allerdings schätzt KRAUS (2000) die übliche Faustformel für die Höhengenauigkeit (Standardabweichung) auf „0,015% der Flughöhe“ als „optimistisch“ für große Bildmaßstäbe ein, da viele natür- liche Oberflächen nicht eindeutig sind, wie z.B. Vegetationsoberflächen. Unabhängig von den genannten Bedenken ergibt sich bei Flughöhen von 50 - 100 m eine theoreti- sche Messgenauigkeit der Photogrammetrie von 7,5 - 15 mm. Diese ist jedoch in der Praxis mit UAS-Bildflügen nicht immer zu erreichen. Warum ist das so ?

Die absolute Genauigkeit der 3D-Punktwolke hängt von der Anzahl der Bilder und der Schnittgeometrie sowie der Genauigkeit der Äußeren und Inneren Orientierung ab. Sie liegt bei der Verwendung handelsüblicher Digitalkameras in der Regel bei 0.5 - 2 Pixel.

Das bedeutet bei einer Flughöhe von 50 - 100 m und der Verwendung weitwinkliger Objektive theoretische Genauigkeiten von 6 - 50 mm. Dabei ist jedoch zu beachten, dass die für die photogrammetrische Prozessierung notwendigen Passpunkte in der Regel mit RTK-GNSS und damit kaum besser als 10 - 25 mm eingemessen und schlussendlich im Bild bestimmt werden können. Deshalb liegen die praktisch erzielba- ren absoluten Höhengenauigkeiten von UAS-Bildflügen oftmals bei 15 - 30 mm.

1 http://www.pasturemeter.co.nz/

Grundsätzlich ist zu beachten, dass 3D-Punkte nicht für bewegte oder strukturlose Ob- jekte berechnet werden können.

2.1 Photogrammetrische Höhenbestimmung von Vegetationsoberflächen Im Falle einer Vegetationsoberfläche sind noch zwei Besonderheiten zu beachten:

1. Wie an obiger Stelle erwähnt ist es für erfolgreiches Matching bzw. eine hochgenaue Positionsbestimmung unabdingbar, dass sich die betrachteten Objekte während der Bildaufnahme nicht bewegen. Das kann bei landwirtschaftlichen Flächen nicht aus- geschlossen werden. Gerade bei reiferem Getreide reicht schon wenig Wind, um Probleme zu verursachen.

2. Während die Vegetationsoberfläche bei gröber aufgelösten Daten relativ homogen erscheint, weil innerhalb eines Pixels mehrere Pflanzen und der durch sie geworfene Schatten zu einem Signal verschmelzen (Canopy Level), wird bei Bodenauflösungen von wenigen cm die einzelne Pflanze, der durch sie geworfene Schatten und der Bo- den dazwischen aufgelöst (Leaf Level). Dadurch wird es prinzipiell möglich die Höhe eines Bestandes mit Hilfe der 3D-Punktwolke zu erfassen. Allerdings nur dann, wenn der Bewuchs nicht zu dicht ist, bzw. der Blattflächenindex gering ist. Nichtsdestotrotz sind die Schnittbedingungen von Bodenpunkten ungünstig und dadurch auch fehler- anfällig. Das kann durchaus auch dazu führen dass Bodenpixel zu niedrig geschätzt werden können. Deshalb ist eine sorgfältige Filterung der 3D-Punktwolke notwendig.

Bild 1: Genauigkeiten und Probleme bei der UAS-gestützten photogrammetrischen Erfassung von Vegetationsoberflächen

Zwischenfazit: Aufgrund der variablen Punktdichte und der nahezu beliebigen Anzahl von „Standpunkten“, die sichttote Bereiche minimieren, sowie der hohen Genauigkeit

LAI < 1

Unkraut

LAI 1-2

- Windanfälligkeit - keine Bodenpunkte

Boden LAI > 2

Trennung

Boden – Veg. + Viele Bodenpunkte - Mindesthöhe Vegetation

+ eindeutige Veg.oberfläche - wenige, bzw. ungenaue Boden

punkte

Bornimer Agrartechnische Berichte Heft 81

sind UAS-Punktwolken prinzipiell also für die Bestandshöhenmessung prädestiniert, da sie die notwendige Bodenauflösung realisieren können und im Gegensatz zur her- kömmlichen flugzeug- oder satellitengetragenen Fernerkundung sehr flexibel einsetzbar und weniger wetteranfällig sind.

3 Material und Methoden

Im nachfolgenden sollen zwei verschiedene Ansätze der Bestandshöhenbestimmung mit Hilfe von UAS-Daten vorgestellt und exemplarisch untersucht werden:

1. Bestimmung der Bestandshöhe durch Bildung der Differenz zwischen einem aktuel- len UAS-Oberflächenmodell und einem bereits vorhandenen digitalen Geländemo- dell, dass z.B. durch ein Parallelfahrsystem gewonnen wurde. Der Vorteil dieses Ver- fahrens ist, dass die Referenzfläche immer gleich ist und die Höhenmessung der Be- standsoberfläche, wie an obiger Stelle erläutert, genau und zuverlässig während der gesamten Vegetationsperiode funktioniert. Voraussetzung ist allerdings, dass das Referenz-DGM entsprechend genau ist.

2. Bestimmung der Bestandshöhe durch eine statistische Analyse der 3D-Punktwolke.

Dabei wird diese erst in Boden- und Vegetationspunkte gefiltert und anschließend die Höhe der Vegetationspunkte über dem Boden ermittelt. Somit wird kein zusätzliches DGM aus einer anderen Datenquelle benötigt, was sicherlich der größte Vorteil die- ses Ansatzes ist. Bei dichten und hohen Pflanzenbeständen kann es sein, dass nur wenige Punkte, z.B. in den Fahrgassen oder auch teilweise unzuverlässige Boden- punkte ermittelt werden können, was sich nachteilig auf die Höhenbestimmung aus- wirken kann.

3.1 Differenzmethode UAS-DOM GNSS-DGM

Entgegen der ursprünglichen Planungen bezieht sich der nachfolgend geschilderte Ver- such leider nicht auf einen Pflanzenbestand, denn zum Zeitpunkt des Bildfluges des Untersuchungsgebiets am 28. November 2012 war kein repräsentativer Pflanzenbe- stand auf dem Versuchsfeld mehr vorhanden. Primär geht es nun darum, die Genauig- keit der 3D-Punktwolke von Boden- und Rasenoberflächen mit UAV-gestützter Photo- grammetrie zu ermitteln und den generellen Workflow zu demonstrieren.

Das Untersuchungsgebiet ist ein Teil des Versuchsfelds der Agrar- und Umweltwissen- schaftlichen Fakultät der Universität Rostock, (Bild 4). Vor der Befliegung wurden 14 luftbildsichtbare Passpunkte ausgelegt und mit Hilfe eines RTK-DGNSS eingemessen.

Der UAS-Bildflug wurde mit einer md4-1000 der Firma microdrones durchgeführt. Das Gebiet wurde mit einer Längs- und Querüberlappung von 80% / 60% mit drei Flugstrei- fen abgedeckt. Die Flughöhe betrug ca. 70 Metern, was einem GSD von ca. 1.8 cm pro Pixel entspricht. Insgesamt wurden 45 Bilder gemacht, von denen im weiteren 39 aus- gewertet wurden. Die Witterungsverhältnisse am Tag der Aufnahmen waren alles ande-

re als optimal, da teilweise starker Nebel über dem Versuchsfeld lag. Das Versuchsfeld selbst war frisch gepflügt und daher unbewachsen. Die Tiefe der Pflugfurchen (zwi- schen 10 und 20 cm) wurde zusätzlich gemessen, um die Oberflächenrauhigkeit zu be- stimmen.

Als Referenz liegt ein digitales Geländemodells (DGM) dieser Fläche aus Jahr 2010 vor, das im Rahmen einer Bachelor-Arbeit erstellt wurde, KORN, 2010. Grundlage für das DGM ist eine hochgenaue Rastervermessung mit einer Gitterweite von 10 m und ergänzenden Messungen an Bruchkanten und Feldrändern mit einem RTK-GNSS. Die Genauigkeit der geostatistischen Interpolation variiert geringfügig, liegt aber im Mittel bei etwa 6 cm, vgl. Bild 2 und 3.

Bild 2: Referenz-DGM Bild 3: Standardisierter Vorhersagefehler des Referenz-DGM

Für das Referenz-DGM eignen sich natürlich auch Parallelfahrsysteme landwirtschaftli- cher Traktoren die heutzutage vielfach mit hochgenauen GNSS-Empfängern ausgestat- tet sind. Die Genauigkeit dieser GNSS-Empfänger liegt unter statischen Bedingungen bei etwa ± 1cm. Unter dynamischen landwirtschaftlichen Bedingungen sowie der Be- rücksichtigung mehrerer zusätzliche Fehlerquellen wie der Geländerauhigkeit, die Auf- hängung eines Fahrzeugs etc., ist eine tatsächliche Positionsgenauigkeit von 2 - 10 cm realistisch, GRENZDÖRFFER & DONATH, 2008. Beim Übertragen der gemessenen Werte entlang der Fahrgassen auf die Fläche sind noch die eingangs genannten Interpolati- onsungenauigkeiten zu berücksichtigen, so dass die Absolutgenauigkeiten des Refe- renz-DGM in der Regel nicht besser als 10 cm sind.

3.1.1 Aufbereitung der UAS-Bilddaten

Da die Aufnahmen teilweise durch den Nebel beeinträchtigt waren, wurde zunächst mit dem Bildbearbeitungsprogramm Phase One der Kontrast nachbearbeitet. Die photo

Bornimer Agrartechnische Berichte Heft 81

grammetrische Prozessierung der Bilddaten erfolgte mit der Software Photoscan von Agisoft2, vgl. Bild 4.

Bild 4: Passpunkte und Bilder in Agisoft (Fähnchen 1-14 zeigen die Passpunkte, geneigte blaue Flächen stellen die Lage und Neigung der Bilder dar)

Die Residuen an den Passpunkten lagen bei ca. 2 cm in der Lage und 3.2 cm in der Höhe. Der mittlere Fehler betrug 0,55 Pixel. Die entstandene Punktwolke wurde im ASC-Dateiformat als DOM mit einer Rasterweite von 0.5 m zur weiteren Verwendung in ArcGIS exportiert.

Anschließend ist die Differenz zwischen dem DOM und dem geostatistisch ermittelten DGM berechnet worden. Um sicherzustellen, dass keine systematischen Offsets zwi- schen dem DOM und dem DGM bestehen, wurde die mittlere Abweichung an den Passpunkten ermittelt. Die Passpunkte sind auf flachem Gras ausgelegt worden. Die Abweichung lag bei nur 2 mm, so dass die beiden Geländedaten als vergleichbar gelten können.

3.1.2 Ergebnisse Differenzmethode

Die Differenzkarte (Bild 6) zeigt mehrere signifikante Bereiche von Höhendifferenzen.

In der Zone 1, der Ackerfläche liegt das DOM zwischen 2 - 8 cm tiefer als das DGM. In der Zone 2, einem Vertikal verlaufenden Streifen in der Feldmitte sowie einem Streifen am oberen Feldrand ist das DOM sogar zwischen 8 - 15 cm tiefer als das DGM. In der Zone 3, einem genau 6 m breiten Streifen ist das DOM um 2 - 6 cm über dem DGM. In der Zone 4, dem Grünstreifen um das Feld liegt das DOM geringfügig über oder unter dem DGM (± 5 cm). Die wenn auch kleinen Unterschiede in Zone 1 und 2 sind darauf zurückzuführen, dass in dem 2-jährigen Zeitintervall zwischen den Aufnahmen des DGMs und des DOMs Parzellen und Wege angelegt und wieder entfernt wurden, wie

2 http://www.agisoft.ru

das auf dem Luftbild vom April 2010 verdeutlicht. Durch die herbstliche Bodenbearbei- tung liegt der Boden insgesamt stärker verdichtet und tiefer als während der GNSS- Messung 2010. Interessant in diesem Zusammenhang ist die Zone 3, in der die Boden- bearbeitung offensichtlich mit anderen Einstellungen (Pflugtiefe ?) durchgeführt wurde.

Das Gras zwischen den gepflügten Feldern ist etwas höher als die Passpunkte und so- mit erklären sich die Abweichungen. Im südöstlichen Bereich des Untersuchungsge- biets (Zone 5) ist zu beobachten, dass die Abweichungen zum Rand hin größer werden (bis + 15 cm). Das kann auf fehlende Passpunkte hindeuten oder andere Ursachen ha- ben.

Bild 5: Stover Acker auf Luftbild vom April 2010

Bild 6: Differenzkarte

Eine Ursache für geringfügige Abweichungen sind Interpolationsungenauigkeiten des DGM, die mit der Entfernung zu einem gemessenen Punkt zunehmen. Um diesen Ein- fluss empirisch zu überprüfen, wurden an den Passpunkten die Differenzen zum inter- polierten DGM ermittelt und der Entfernung zu dem nächsten DGM-Messpunkt von 2010 gegenüber gestellt. Wie in Bild 7 klar ersichtlich, ist eine, wenn auch kleine Zu- nahme der Abweichungen mit größer werdendem Abstand zum nächsten Messpunkt zu erkennen.

1 3 2

4

5

Bornimer Agrartechnische Berichte Heft 81

Bild 7: Differenz zwischen gemessener und berechneter Höhe im Verhältnis zum Abstand zwi- schen DGM-Messpunkten und Passpunkten

3.2 3D-Punktwolkenanalyse

Im Zuge einer Untersuchung zur Analyse von Grünlandqualitäten von extensiv genutz- ten Flächen mit Hilfe von UAS-Daten wurde am 25.6.2011 ein Bildflug einer ca. 4 ha großen Weidefläche mit einem Falcon 8 System der Firma Ascending Technologies in der Nähe von Demmin durchgeführt. Die Weidefläche wurde von den Kühen unter- schiedlich intensiv abgeweidet. Die Aufwuchshöhe des Grases variiert teilweise klein- räumig zwischen quasi abgenagt (1 - 3 cm) und hohem Gras von ca. 40 - 60 cm, das von den Kühen aus verschiedenen Gründen (noch) nicht gefressen wurde. Die Flughö- he betrug ca. 60 m (GSD = 1.9 cm). Als Längs- und Querüberlappung wurde 70 / 40%

gewählt. Die photogrammetrische Datenauswertung erfolgte mit der Software Pix4D3. Die Residuen an den 11 Passpunkten lagen bei 1,5 cm in der Lage und 4,2 cm in der Höhe. Die innere Genauigkeit des Photogrammetrischen Blocks lag bei 0.55 Pixel. Die 3D-Punktwolke mit 3.15 Mio. Punkten, weist eine relativ geringe Punktdichte von ca. 75 Punkten pro m² auf.

Der erste Schritt der Datenanalyse, die mit den LAS-Tools4 durchgeführt wurde, ist eine Filterung der Punkte in Boden- und Vegetationspunkte. Dabei werden diejenigen Punk- te als Vegetationspunkte identifiziert, die sich in der Höhe stark von ihren Nachbarn ab- heben. Die Wirkungsweise der Filterung wird anhand eines Profils in Bild 8. verdeut- licht.

3 http://www.pix4d.com

4 http://www.rapidlasso.com

Bild 8: Trennung von Boden (Violett) - und Vegetationspunkten (Gelb) entlang eines 20 m lan- gen und 2 m breiten Profils

Da die Software eigentlich für die Analyse von Airborne Laserscanning Daten entwickelt wurde, müssen geeignete Parameter iterativ bestimmt werden. Anschließend werden die Höhenwerte der einzelnen Punkte gegenüber einer Grundoberfläche berechnet.

Dabei kann vorgegeben werden, ob innerhalb eines Rasters, von z.B. 0.5 m die nied- rigsten und höchsten Punkte verwendet werden sollen oder bestimmte Perzentile. Auf- grund der systembedingten Ungenauigkeiten bei der Berechnung der lokalen Minima wurde das 5% Perzentil als minimale Fläche angenommen und das 95% Perzentil als Maximum, damit nicht einzelne Ausreißerpflanzen die Höhe einer Rasterzelle bestim- men, vgl. Bild 9. Das Ergebnis der Grashöhenbestimmung ist in Bild 10 dargestellt.

Das Ergebnis stimmt räumlich hervorragend mit den erwarteten Werten überein. Auch die sehr kleinräumige Variabilität der Wuchshöhenunterschiede in dem beweideten Grünland konnte herausgearbeitet werden. Bei landwirtschaftlichen Kulturen sind si- cherlich größere Rasterweiten sinnvoll, die statistisch gesehen ein höheres Maß an Zu- verlässigkeit gewähren.

Bild 9: Aufwuchshöhe der 3D-Punktwolke Min. - Max.

Bild 10: Aufwuchshöhe der 3D-Punktwolke 5 - 95 Perzentil

4 Diskussion und Ausblick

In dem Beitrag konnte gezeigt werden, dass es zwei Verfahrenswege zu Bestimmung der Vegetationshöhe (Differenzmethode und 3D-Punktwolkenmethode) gibt, die beide

Bornimer Agrartechnische Berichte Heft 81

riode abgearbeitet werden, sollen wichtige Fragen im Hinblick auf das Einsatzspektrum sowie die erzielbaren Genauigkeiten und Zuverlässigkeiten der beiden Methoden be- antworten. Unter anderem wird die Frage zu klären sein, bis zu welchem LAI die 3D- Punktwolkenmethode einsetzbar ist.

Literaturverzeichnis

EHLERT D.,ADAMEK R.,HORN H.-J.(2009): Laser rangefinder-based measuring of crop biomass under field conditions.- Precision Agriculture 10: 395–408

GIRMA,K., MARTIN K.L., ANDERSON R.H.,ARNALL D.B.,BRIXEY K.D.,CASILLAS M.A., CHUNG B., DOBEY B.C.,KAMENIDOU S.K.,KARIUKI S.K.,KATSALIROU E.E.,MORRIS J.C.,MOSS J.Q.ROHLA

C.T.,SUDBURY B.J.,TUBANA B.S.,RAUN W.R.(2006): Mid-Season Prediction of Wheat-Grain Yield Potential Using Plant, Soil, and Sensor Measurements.- Journal of Plant Nutrition 29: 873 – 897

GRENZDÖRFFER G.,DONATH C.(2008):Generation and analysis of digital terrain models with paral- lel guidance systems for precision agriculture.- Proceedings of the 1st International conference on Machine Control & Guidance.- 24.-26.6,2008, ETH Zürich: 141-150

KORN G.(2010): Aufbau einer Geodateninfrastruktur für das Versuchsfeld der Universität Rostock.- unveröff. Bachelorarbeit. 36 S

KRAUS K. (2000): Photogrammetrie. Band 3: Topographische Informationssysteme. Dümmler.

Bonn. 419 S

SAMMIS,T.W.SMEAL,D.WILLIAMS,S.(1988): Predicting Corn Yield Under Limited Irrigation Using Plant Height.- Transactions of the ASABE. 31: 0830-0837

SCHMIDT F.(2003): Hochgenaue Digitale Geländemodelle - Untersuchung zu Erfassung und Ana- lyse am Beispiel Precision Agriculture. Dissertation. Universität Rostock

SHRESTHA D.S.,STEWARD B.L.,KASPAR T.C.(2002): Determination of early stage corn plant height using stereo-vision.- 13. S. Proceedings of the 6th Int'l. Conf. on Precision Agriculture, Hrsg.

P.C. Robert, R. H. Rust und W. E. Larson, Madison WI: ASA- CSSA-SSSA

STRECHA C.(2011):The Accuracy of Automatic Photogrammetric Techniques on Ultra-Light UAV Imagery.- In: Fritsch, D. [Hrsg.]: Photogrammetric Week 2011.- 289 - 294. Wichmann Verlag YIN X., MCCLURE M.A., JAJA N., TYLER D.D., HAYES R.M. (2011): In-Season Prediction of Corn

Yield Using Plant Height under Major Production Systems.- Agronomy Journal 103: 923-929

Kombinierte Pfad- und Trajektorienplanung für autonome mobile Roboter

Janko Petereit, Thomas Emter

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB Email: janko.petereit@iosb.fraunhofer.de

Zusammenfassung: Es wird ein Verfahren zur effizienten Bewegungsplanung für mobile Roboter in der Gegenwart dynamischer Hindernisse vorgestellt. Das Planungsergebnis ist von hybrider Natur: In der nahen Zukunft wird eine volldimensionale Trajektorie geplant, in der fernen Zukunft nur noch ein einfacher Pfad. Die sukzessive Reduktion der Planungs- güte findet unter Verwendung einer gitterförmigen Zustandsraumstruktur (state × time lat- tice) statt.

Deskriptoren: Bewegungsplanung für mobile Roboter, Planung mit hybrider Dimensiona- lität, State-Lattice-Planer

Summary: In this paper, we present an algorithm for efficient mobile robot motion plan- ning in the presence of dynamic obstacles. It computes hybrid solutions which are part trajectory (for the close future) and part path (for the far future). This gradual fidelity reduc- tion is performed using the concept of planning in a state × time lattice structure.

Keywords: mobile robot motion planning, hybrid-dimensional planning, state lattice planner

1 Einleitung

Autonome mobile Roboter finden in immer mehr Bereichen Einsatz. Je nach Umgebung müssen die verwendeten Algorithmen unterschiedlich komplexe Aufgaben bewältigen können. So ist die Navigation in einer klar strukturierten Umgebung, wie sie z. B. Innen- räume von Produktionsstätten darstellen, deutlich einfacher als in einer völlig unstrukturier- ten Umgebung, wie man sie z. B. nach einer Naturkatastrophe oder einem Industrieunfall vorfindet. Die Komplexität der Umgebung, mit der ein Agrarroboter konfrontiert wird, liegt in der Regel irgendwo dazwischen, da sie sowohl strukturierte als auch unstrukturierte Elemente enthält.

Allen mobilen Robotern ist gemeinsam, dass sie neben einer möglichst exakten Wahr- nehmung der Umgebung über effiziente Algorithmen zur Bewegungsplanung verfügen müssen, um so ihren Auftrag letztendlich erfolgreich ausführen zu können. Die Bewe- gungsplanung lässt sich in zwei Aufgabenstellungen unterteilen: Zum einen muss ein glo- baler Plan entwickelt werden, auf welchem Weg der Roboter am sinnvollsten zu seinem

Bornimer Agrartechnische Berichte Heft 81

entsprechende Stellgrößen für die Aktorik bestimmt werden. Letzteres setzt neben der Berücksichtigung der Roboterkinematik auch ein Miteinbeziehen der dynamischen Platt- formeigenschaften voraus.

Je nach Anwendungsgebiet werden an die globale Pfadplanung unterschiedliche Anforde- rungen gestellt. Für eine möglichst schnelle Exploration eines unbekannten Gebietes wird derjenige Pfad gesucht, welcher einen maximalen Informationszugewinn für die Kartener- stellung erwarten lässt. Ist hingegen ein konkretes Ziel für den Roboter bekannt, so be- steht die Aufgabe darin, einen unter verschiedenen Randbedingungen möglichst optima- len Pfad zu bestimmen. Hierbei kann eine Vielzahl von Optimierungskriterien einfließen, wie z. B. ein möglichst kurzer Pfad, ein möglichst energieeffizienter Pfad unter Ausnutzung der Geländebeschaffenheit oder die Minimierung des Kollisionsrisikos.

Die lokale Bewegungsplanung (oft auch reaktive Bewegungsplanung genannt) hat hinge- gen eine ganz andere Aufgabe. Im einfachsten Fall sorgt sie dafür, dass der Roboter dem global geplanten Pfad folgt. Hierfür muss die lokale Pfadplanung geeignete Roboterge- schwindigkeiten und Lenkbewegungen bestimmen, welche sie anschließend an die unter- lagerte Hardware-Treiber-Schicht weitergibt. Zusätzlich muss die lokale Bewegungspla- nung aber auch in der Lage sein, schnell auf sich verändernde Bedingungen zu reagieren (z. B. beim unerwarteten Auftauchen eines Hindernisses), um entsprechende Aktionen hieraus abzuleiten. Gerade unter diesem letztgenannten Sicherheitsaspekt ist es unab- dinglich, dass die Algorithmen zur Berechnung der zukünftigen Roboterbewegung mit ei- ner hohen Taktrate laufen.

Diese Anforderung an die Ausführungsrate erklärt auch die gewöhnliche Trennung von globaler Pfadplanung und lokaler Hindernisvermeidung bzw. Trajektorienplanung. Wäh- rend erstere häufig mit einer Taktrate im Sekundenbereich arbeitet, muss die Taktrate der Trajektorienplanung um ein Vielfaches höher liegen. Jedoch hat diese Trennung der bei- den Planungskomponenten auch ihre Nachteile. Die Trajektorienplanung im Nahbereich basiert nur auf begrenzten Informationen und hat das globale Optimierungsziel in der Re- gel nicht im Blick. Dies hat zur Folge, dass nicht vorausschauend geplant wird, sodass durch suboptimale lokale Entscheidungsfindungen auch das globale Navigationsergebnis schlechter ausfällt als nötig wäre.

Ein neuartiges Konzept erlaubt es, die lokale Trajektorienplanung mit der globalen Pfadplanung in einem einheitlichen, konsistenten Ansatz zu kombinieren. Es beruht auf der Idee, dass die Qualitätsanforderung, die an das Ergebnis eines solchen Bewegungs- planers gestellt wird, nicht überall gleich ist. Sowohl im Nahbereich des Roboters als auch in der unmittelbaren Zukunft ist es sinnvoll, eine vollständige Trajektorie zu planen. Diese könnte z. B. aus der Roboterposition, der Ausrichtung, der Geschwindigkeit des Roboters und der Zeit, zu der sich der Roboter in der entsprechenden Konfiguration befindet, beste- hen. Mit zunehmender Entfernung vom Roboter bzw. zunehmender Zeit, wird das dyna- mische Verhalten des Roboters immer unwichtiger, sodass hier zur Planung eines reinen Pfades übergegangen werden kann. Im Beispielfall würde dies bedeuten, dass für den Pfad nur noch die Position und Ausrichtung des Roboters relevant sind. Die Kombination

der Planungsebenen in einem einzigen Algorithmus resultiert in einem Ergebnis mit hybri- der Dimensionalität, nämlich teils Trajektorie und teils Pfad.

2 Hintergrund

Für die Suche der optimalen Trajektorie wird der jeweils betrachtete Zustandsraum auf eine Graphenstruktur abgebildet. Hierfür gibt es hauptsächlich zwei Möglichkeiten:

1. Die Eingangsgrößen werden direkt diskretisiert, was dann zur Folge hat, dass die Menge der erreichbaren Zustände im Allgemeinen kontinuierlich ist. Dies bedeutet, dass der Suchgraph eine Baumstruktur besitzt. Während der Graphensuche müs- sen dann gegebenenfalls weitere Diskretisierungen vorgenommen werden, um die Knotenanzahl aus Rechenzeitgründen möglichst klein zu halten. Ein solches Ver- fahren ist der Hybrid-A*-Algorithmus, welcher von DOLGOV et al. (2010) vorgestellt wurde.

2. Es wird direkt der Zustandsraum diskretisiert. Die Eingangsgrößen werden nun so berechnet, dass sie nur Bewegungen des Systems zwischen den diskreten Punk- ten des Zustandsraums zulassen. Der hierdurch entstehende Suchgraph bildet ei- ne Gitterstruktur ab (engl. state lattice). Im Zusammenhang mit mobilen Robotern wurde dieses Verfahren das erste Mal von PIVTORAIKO et al. (2009) vorgestellt.

Das Verfahren zur Bewegungsplanung mittels state lattices bildet im Folgenden die Basis für die Planung der Roboterbewegung. Der ursprüngliche Ansatz beschränkte sich auf die Planung reiner Pfade (d. h. es wurde lediglich die nichtholonome Bewegung eines Fahr- zeuges auf einen Zustandsraum, welcher die Fahrzeugposition und Ausrichtung enthält, abgebildet). LIKHACHEV &FERGUSON (2009) haben dieses Verfahren dann auf die Planung von Pfaden erweitert, welche auch die Dynamik des Fahrzeuges miteinbeziehen können (z. B. indem der Zustandsraum um die Geschwindigkeit und den Lenkeinschlag erweitert wird).

Um während der Bewegungsplanung dynamische Hindernisse berücksichtigen zu kön- nen, ist eine reine Pfadplanung nicht mehr ausreichend. Vielmehr muss zu einer echten Trajektorienplanung übergegangen werden, was bedeutet, dass der Zustandsraum um eine Zeitdimension erweitert werden muss. Dies hat jedoch zur Folge, dass der Rechen- aufwand für die Bewegungsplanung enorm steigt. Aus diesem Grund haben KUSHLEYEV &

LIKHACHEV (2009) mit dem Time-bounded lattice einen Ansatz vorgestellt, welcher nur bis zu einem bestimmten Zeithorizont die Zeitkomponente während der Planung berücksich- tigt. Danach geht die Planung zu einer simplen Gittersuche über, was dann allerdings zur Folge hat, dass die kinematischen Randbedingungen der mobilen Plattform nicht mehr abgebildet werden können. Ein ebenfalls in diesem Kontext interessantes Verfahren ha- ben GOCHEV et al. (2011) vorgestellt, bei dem ebenfalls mit adaptiver Dimensionalität ge- plant wird. Allerdings handelt es sich bei diesem Verfahren um eine reine Pfadplanung – Trajektorien werden nicht berücksichtigt.

Bornimer Agrartechnische Berichte Heft 81

Im Folgenden wird deswegen ein Konzept vorgestellt, welches nach der Trajektorienpla- nung in einem state × time lattice mit voller Dimensionalität (Position, Ausrichtung, Ge- schwindigkeit, Zeit) zu einer reinen Pfadplanung mit reduzierter Dimensionalität übergeht, welche jedoch immer noch die Roboterkinematik korrekt abbilden kann (also Fahrzeugpo- sition und Ausrichtung beinhaltet).

3 Algorithmus

Der vorgestellte Algorithmus besteht im Wesentlichen aus drei Komponenten, von denen die ersten beiden offline berechnet werden können:

1. Definition eines hochdimensionalen Suchraumes auf Basis von speziell generierten Bewegungsprimitiven.

2. Reduktion der Dimensionalität des Suchraumes.

3. Suche des kürzesten Weges in dem erzeugten Suchgraphen.

Am Anfang steht die Wahl einer geeigneten Diskretisierung des volldimensionalen Zu- standsraums, wodurch die Struktur des state × time lattice festgelegt wird. Anschließend wird das kontinuierliche dynamische Modell des Roboters dazu genutzt, um mit zufälligen Eingangsgrößen die Bewegung des Roboters über einen gegebenen Zeithorizont zu si- mulieren. Liegt der Endpunkt einer solchen Simulation wiederum auf einem Punkt des diskretisierten Zustandsraums, so wird dieses durch die Simulation gewonnene Bewe- gungsprimitiv in die Liste der erlaubten Roboterbewegungen aufgenommen. Dieses Vor- gehen wird so häufig iteriert, bis die Menge der Bewegungsprimitive alle erlaubten Robo- terbewegungen hinreichend gut abbildet.

Der state × time lattice und mit ihm die zugehörige Bewegungsprimitivmenge ist aus- schließlich „translationsinvariant“ bezüglich der Positions- und Zeitkomponenten. Das be- deutet, dass das oben beschriebene Vorgehen zur Erzeugung der Bewegungsprimitive für alle Kombinationen von erlaubten Fahrzeugausrichtungen und Geschwindigkeiten durch- geführt werden muss. Da das Erzeugen der Bewegungsprimitive jedoch offline erfolgt, ist die benötigte Rechenzeit hier unkritisch.

Die Bewegungsprimitivmenge kann nun genutzt werden, um einen Graphen aufzuspan- nen, der die erlaubten Übergänge zwischen den Zuständen abbildet. Die Suche der opti- malen Trajektorie lässt sich somit auf eine Suche des kürzesten Weges in diesem Gra- phen von der Start- zur Zielkonfiguration zurückführen.

Da es für die Bewegungsplanung essentiell ist, dass diese in Echtzeit erfolgen kann, und die Rechenkapazität somit beschränkt ist, ist es nicht sinnvoll, über den gesamten Pla- nungshorizont hinweg eine echte Trajektorie zu planen. Aus diesem Grund wird eine wei- tere Bewegungsprimitivmenge erzeugt. Sie wird durch die Projektion der zu Beginn er- zeugten volldimensionalen Bewegungsprimitivmenge auf einen Unterraum gewonnen. Im obigen Beispielfall bedeutet dies, dass durch Projektion auf den Raum der Roboterpositio-

nen und -ausrichtungen die Geschwindigkeits- und Zeitdimension eliminiert werden.

Bild 1 zeigt ein Beispiel dieser neuen Bewegungsprimitivmenge. Mit dieser zweiten Be- wegungsprimitivmenge kann nun ein weiterer Graph aufgespannt werden, welcher für die reine Pfadplanung genutzt werden kann.

Bild 1: Bewegungsprimitivmenge mit reduzierter Dimensionalität

Die beiden Graphen – der erste beschreibt den Suchraum mit voller Dimensionalität, der zweite den Suchraum mit reduzierter Dimensionalität – können nun zu einem gemeinsa- men Graphen zusammengefügt werden, indem für bestimmte Knoten des ersten Graphen Übergänge in den zweiten Graphen definiert werden, nämlich genau für die Knoten, wel- che sich auf dem Zeithorizont der vollen Trajektorienplanung befinden. In dem so gewon- nenen Graphen kann nun mittels Standardalgorithmen (z. B. A*-Algorithmus) der best- mögliche Weg vom hochdimensionalen Startzustand zur niedrigdimensionalen Zielmenge gesucht werden.

Um die dynamischen Hindernisse korrekt berücksichtigen zu können, muss deren prädi- zierte Position während der Bewegungsplanung explizit miteinbezogen werden. Dies ge- schieht in Form eines geschätzten Kollisionsrisikos mit dem jeweiligen Hindernis (PE-

TEREIT et al. (2013)). Um das Kollisionsrisiko zu bestimmen, wird die prädizierte Aufent- haltswahrscheinlichkeit des Hindernisses über der Grundfläche des Roboters integriert, wobei diese der Einfachheit halber als kreisförmig angenommen wird (Bild 2).

Bornimer Agrartechnische Berichte Heft 81

Bild 2: Berechnung der Kollisionswahrscheinlichkeit mit dynamischem Hindernis

4 Ergebnisse

Das vorgestellte Verfahren wurde mittels aufgezeichneter Kartendaten evaluiert. Bild 3 zeigt ein beispielhaftes Planungsergebnis: Der Roboter steht zu Beginn einem entgegen- kommenden Hindernis gegenüber, welches durch die Unsicherheitsellipsen der Prädiktion dargestellt ist. Er plant ein Ausweichmanöver, lässt das Hindernis passieren und fährt dann weiter in Richtung Ziel. Die grünen Kacheln beschreiben den Teil des Planungser- gebnisses, welcher der volldimensionalen Trajektorie entspricht (also eine Positions-, Aus- richtungs-, Geschwindigkeits- und Zeitinformation besitzt). Ab dem Zeitpunkt t0 geht das Ergebnis in eine reine Pfadplanung über (helle Kacheln), welche nur noch eine Aussage über Roboterposition und -ausrichtung treffen kann.

Mit dem beschriebenen Verfahren lässt sich die Bewegungsplanung in weniger als 100 ms berechnen, was einem möglichen Echtzeitbetrieb mit 10 Hz entspricht.

Bild 3: Hybrides Planungsergebnis (teils Trajektorie, teils Pfad)

5 Schlussfolgerung

Es wurde ein Verfahren zur Bewegungsplanung für mobile Roboter vorgestellt, welches es erlaubt, sehr effizient kombinierte Trajektorien/Pfade zu generieren. Dies ermöglicht dem Roboter eine schnelle Reaktion auf unvorhergesehene Ereignisse, ohne hierbei die globa- le Optimalität der Bewegung aus dem Auge zu verlieren. Der Ansatz verwendet soge- nannte state × time lattices mit einer hybriden Dimensionalität, um die zukünftige Bewe- gung des Roboters zu planen. Das Planungsergebnis besteht hierbei aus einer Trajektorie mit voller Dimensionalität für die nahe Zukunft des Roboters und einem kinematisch zu- lässigen Pfad mit reduzierter Dimensionalität für die ferne Zukunft.

Literaturverzeichnis

DOLGOV D.,THRUN S.,MONTEMERLO M.,DIEBEL J.(2010):Path planning for autonomous vehicles in unknown semi-structured environments. The International Journal of Robotics Research 29:

485-501

GOCHEV K., COHEN B., BUTZKE J. et al. (2011): Path planning with adaptive dimensionality.

Proceedings of the Symposium on Combinatorial Search

KUSHLEYEV A., LIKHACHEV M. (2009): Time-bounded lattice for efficient planning in dynamic environments. Proceedings of the IEEE International Conference on Robotics and Automation LIKHACHEV M., FERGUSON D. (2009): Planning long dynamically feasible maneuvers for auto-

nomous vehicles. The International Journal of Robotics Research 28: 933-945

PETEREIT J., EMTER T., FREY C.W. (2013): Safe mobile robot motion planning for waypoint sequences in a dynamic environment. Proceedings of the IEEE International Conference on Industrial Technology

PIVTORAIKO M., KNEPPER R.A., KELLY A. (2009): Differentially constrained mobile robot motion planning in state lattices. Journal of Field Robotics 26: 308-333

Bornimer Agrartechnische Berichte Heft 81

Volumenbestimmung von Hühnereiern aus Kameraaufnahmen im Stall

Bernhard Lang, Jürgen Biermann

Hochschule Osnabrück, Fakultät für Ingenieurwissenschaften und Informatik, Albrechtstraße 30, 49076 Osnabrück

Email: B.Lang@hs-osnabrueck.de, J.Biermann@hs-osnabrueck.de

Zusammenfassung: In modernen Hühnerställen werden Eier mit kamerabasierten Sys- temen gezählt. Mit dem vorliegenden Beitrag wird dargelegt, wie mithilfe verfügbarer Ka- meraaufnahmen auch das Volumen und damit das Gewichte der Eier bestimmt werden kann.

Zur Ermittlung des Volumens muss einmal vorab eine Kalibrierung der verwendeten Ka- meras erfolgen. Mit kalibrierten Aufnahmen werden die Konturen der Eier auf Basis ver- schiedener Modelle ermittelt und das Volumen als Rotationskörper der modellierten Kon- tur bestimmt.

Zur Bewertung des Vorgehens werden für gleiche Eier die Volumen mit den verschiede- nen Modellen und an verschiedenen Positionen im Bild ermittelt und verglichen.

Deskriptoren: Berechnung Eivolumen, Bildverarbeitung, Kamerakalibrierung, Modellie- rung Ei-Kontur und Ei-Volumen.

1 Einleitung

Für das Zählen von Eiern auf Förderbändern in modernen Hühnerställen werden Kamera- basierte Systeme eingesetzt. Ein Wunsch ist es nun, diese Systeme zur Ermittlung weite- rer Parameter zu nutzen. Zielsetzung dieser Arbeit ist es darzulegen, wie mithilfe der Ka- meraaufnahmen auch die Volumen und damit die Gewichte der Eier bestimmt werden können.

Dazu muss zunächst eine Kalibrierung der Aufnahmen vorgenommen werden, welche die reale Verzerrung der Optik entfernt. Weiter werden die Aufnahmen so korrigiert, als wären sie mit einer exakt senkrecht zum Förderband ausgerichteten Kamera aufgenommen. Die Kontur von Eiern lässt sich durch verschiedene Modelle beschreiben. Im vorliegenden Beitrag werden zwei unterschiedliche Modelle untersucht. Das erste Modell beschreibt die Ei-Kontur mit Hilfe eines Polynoms 3. Grades, das zweite Modell verwendet zwei Ellipsen zur Modellierung.

Aus den kalibrierten Aufnahmen der Kamera werden die realen Konturen der Eier be- stimmt und daraus alternativ die Parameter beider Modelle geschätzt. Das Eivolumen wird dann schließlich als Rotationskörper der modellierten Kontur bestimmt. Mit einem Ver- gleich von Aufnahmen gleicher Eier an verschiedenen Positionen im Bild wird die Genau-

igkeit aufgezeigt, mit der das Volumen mit dem vorgestellten Verfahren und den unter- suchten Modellen ermittelt werden kann.

2 Kamerakalibrierung

Vor Verwendung von Kameras für Messaufgaben müssen diese zunächst kalibriert und deren Bezug zur umgebenden Welt hergestellt werden (HARTLEY &ZISSERMAN 2004).

Bild 1: Links Originalaufnahme und rechts entzerrte Aufnahme eines Eies

Die Notwendigkeit zur Kalibrierung wird im Bild 1 deutlich. Das linke Bild zeigt die Originalaufnahme eines Transportbands mit einem darauf liegenden Ei. Durch Verwendung einer Optik mit kurzer Brennweite entsteht eine Verzerrung, welche in erheblichem Maße eine Messung des Eivolumens verfälschen würde. Im rechten Bild ist die unter Verwendung der Kalibrierparameter entzerrte Aufnahme gezeigt.

Zur Kalibrierung werden einer Kamera hinreichend viele Punkte mit exakt bekannten Positionen in einem 3-dimensionalen Weltkoordinatensystem präsentiert und deren Positionen im Kamerabild, also in einem 2-dimensionalen Sensorkoordinatensystem, ermittelt. Aus diesen Positionen werden folgende Parameter ermittelt:

Extrinsische Parameter: Die Rotationsmatrix und der Translationvektor ⃗ beschreiben den Bezug zwischen der Position eines Punkts im Weltkoordinaten- system und seiner Position in einem Kamerakoordinatensystem mit Ursprung im Brennpunkt der Kamera:

⃗ (1)

Verzerrungsparameter: In einer normierten Bildebene mit Bildweite wird die radiale und tangentiale Verzerrung mit den Parametern und modelliert.

Zunächst erfolgt Projektion des Punkts in die normierte Bildebene auf den Bildpunkt .

In der normierte Bildebene wird die Verzerrung modelliert, welche den Punkt nach verschiebt. In den nachfolgenden Gleichungen gilt :

( ) (2)

Bornimer Agrartechnische Berichte Heft 81

( ) (3) Intrinsische Parameter: Die Bildweiten und die Verschiebungsparameter bestimmen schließlich die Abbildung des verzerrten Bildpunkts auf die Position der Sensorbildebene:

Die ermittelten Parameter bleiben gültig, solange die mechanische Ausrichtung der Kame- ra und deren Einstellung der Optik (Zoom, Schärfe) nicht verändert werden.

Bild 2: Target mit Schachbrettmuster zur Kamerakalibrierung

Zur Kalibrierung und damit zur Ermittlung der genannten Parameter ist das Verfahren von Zhang aktuell (ZHANG 2000), bei dem die Kreuzungspunkte eines Schachbrettmusters bekannter Größe die Punkte bilden (Bild 2). Dieses Target wird der Kamera in verschie- denen Ansichten präsentiert. Jeder Ansicht wird dabei ein eigenes Weltkoordinatensystem zugeordnet. Wird bei einer Ansicht das Target flach auf dem Transportband platziert, kann mit deren extrinsischen Parametern jede Aufnahme so umgerechnet werden, als sei sie mit einer exakt senkrecht zum Transportband ausgerichteten Kamera aufgenommen.

3 Ermittlung der entzerrten Ei-Kontur

Die Ermittlung der Ei-Kontur kann mittels Bildverarbeitung im verzerrten oder entzerrten Bild erfolgen. Im ersten Fall müssen die Konturpunkte aus der verzerrten in die unverzerr- te Darstellung überführt werden. Im zweiten Fall muss das gesamte Bild entzerrt werden, man erhält dann aber die Konturpunkte bereits in der entzerrten Darstellung.

Bei den wenigen Punkten der Ei-Kontur ist das erste Vorgehen weniger rechenintensiv, auch wenn die inversen Verzerrungen zu den Gleichungen 2, 3 berechnet werden müs- sen. Dieses Vorgehen wird im Folgenden erläutert.

Zunächst wird ein im aufgenommenen Bild und damit in der Sensorbildebene ermittelter, verzerrter Konturpunkt in die normierte Bildebene abgebildet:

(4)