DHd 2018

Kritik der digitalen Vernunft

Konferenzabstracts

Universität zu Köln

26. Februar bis 2. März 2018

DHConvalidators in eine TEI konforme XML-Datei konvertiert.

Herausgeber: Georg Vogeler Korrektur der Auszeichnungen:

Dana Persch, Claes Neuefeind, Patrick Helling Konvertierung TEI nach PDF: Claes Neuefeind https://github.com/GVogeler/DHd2018

unter Verwendung der Konversionsskripte von Karin Dalziel https://github.com/karindalziel/TEI-to-PDF

und der bearbeiteten Version von Aramís Concepción Durán https://github.com/aramiscd/dhd2016-boa.git

Konferenz-Logo: Anja Neuefeind

Online verfügbar: http://dhd2018.uni-koeln.de/

ISBN 978-3-946275-02-2

Vorwort

Das „Book of Abstracts“ war in der jungen Tradition der DHd zunächst eher ein Nebenprodukt des Bewerbungsprozesses. Die Professionalisierung unserer Disziplin hat nun dazu geführt, dass für die DHd 2018 in Köln die Ansprüche an die Qualität der Beiträge gestiegen sind. Damit geht einher, dass die Vorschläge immer mehr ihre guten Ideen mit den üblichen Argumentationsmustern und äußeren For- men wissenschaftlichen Arbeitens entwickeln, also die Standards einer wissenschaftlichen Publikation erfüllen. Das „Book of Abstracts“ wird so klassischen „Conference Proceedings“ immer ähnlicher. Das ist eine zu begrüßende Entwicklung. Sie trägt hoffentlich auch dazu bei, die auf der DHd 2018 vorgestellten Forschungsergebnisse im weiteren wissenschaftlichen Diskurs aufzugreifen und zu referenzieren.

Für die Qualität der Beiträge sind natürlich die Autoren verantwortlich. Ihrem Bemühen, auch dem der vielen, die wir leider ablehnen mussten, gebührt das erste Dankeschön. Dazu beigetragen haben dann die vielen Gutachterinnen und Gutachter, die es ertragen mussten, von mir immer wieder daran erinnert zu werden, doch bitte ihre Expertise in den Dienst der Tagung zu stellen. Auch Ihnen/euch al- len: Danke! Es blieben dann trotz dieser Expertise immer noch einige Nüsse zu knacken, die wir im Pro- grammkomitee so sachlich, konstruktiv und wohlwollend diskutieren konnten, wie ich mir es für eine Tagung nur wünschen kann: Danke an Mareike König als meine Stellvertreterin, Andreas Münzmay, Claudine Moulin, Christof Schöch, Anne Baillot, Peter Gietz, Walter Scholger, Lisa Dieckmann, Andreas Henrich, Petra Gehring, Lars Wieneke und als Vertreter der lokalen Organisation Andreas Witt. Ebenso ein Danke an die übrigen lokalen Organisatorinnen und Organisatoren für die produktive Zusammen- arbeit bei der Vorbereitung des Tagungsprogramms.

Die Konferenz – und damit auch diese Publikation – wäre natürlich nicht möglich, wenn es nicht Ein- richtungen gäbe, die sie finanziell unterstützen. Sie sind auf der Rückseite des Titelblatts aufgelistet. Ich hoffe, das Ergebnis macht sie zufrieden. Wir bedanken uns auf jeden Fall für die Unterstützung!

Der Status einer wissenschaftlich nutzbaren Publikation hat auch etwas mit einer gründlichen Redak- tion der Texte zu tun. Diese haben die Kölner Patrick Helling, Claes Neuefeind und Dana Persch geleistet.

Sie haben die Vielfalt der TEI-Kodierungen, die der DHconvalidator aus der Vielfalt der eingereichten Dateiformatierungen erzeugte, angeglichen und daraus ein PDF erzeugt. Für die technische Abwicklung konnten Sie auf die Vorarbeiten der Leipziger Kolleginnen und Kollegen aufbauen. Ihrer aller Arbeit ist in diesem Band und in einem github-Repository ( https://github.com/GVogeler/DHd2018 ) dokumentiert.

Ihnen gebührt deshalb ganz ausdrücklicher Dank!

Graz, Februar 2018 Georg Vogeler

Vorsitzender des Programmkomitees

Keynotes

Der ‚Stachel des Digitalen‘ - ein Anreiz zur Selbstreflexion in den Geisteswissenschaften?

Krämer, Sybille ... 17 Kritik der digitalen Vernunft

Sperberg-McQueen, C. Michael ... 17

Workshops

Annotation and beyond – Using ATHEN Annotation and Text Highlighting Environment

Krug, Markus; Tu, Ngoc Duyen Tanja; Weimer, Lukas; Reger, Isabella; Konle,

Leonard; Jannidis, Fotis; Puppe, Frank ... 19 Audio Mining für die Geistes- und Kulturwissenschaften: Nutzungsszenarien und Herausforderungen

Köhler, Joachim; Leh, Almut; Himmelmann, Nikolaus; Rau, Felix ... 21 Automatic Text Recognition: Mit Transkribus Texterkennung trainieren und

anwenden

Hodel, Tobias; Strauß, Tobias; Diem, Markus ... 24 CorpusExplorer v2.0 - Seminartauglich in einem halben Tag

Rüdiger, Jan Oliver ... 28 Digitale Bildrepositorien – wirkliche Arbeitserleichterung oder zeitraubend?

Friedrichs, Kristina; Münster, Sander; Niebling, Florian; Maiwald, Ferdinand;

Bruschke, Jonas; Barthel, Kristina ... 30 Digitale Sammlungserschließung mit WissKI und CIDOC CRM

Scholz, Martin; Wagner, Sarah ... 33 Embedded Humanities

Jannidis, Fotis; Kestemont, Mike ... 36 Maschinelles Lernen lernen: Ein CRETA-Hackatorial zur reflektierten

automatischen Textanalyse

Reiter, Nils; Ketschik, Nora; Kremer, Gerhard; Schulz, Sarah ... 39 Modellathon „Digitale 3D-Rekonstruktion"

Münster, Sander; Christen, Jonas; Pfarr-Harfst, Mieke ... 42 Nutzerunterstützung und neueste Entwicklungen in Forschungsdatenreposi-

torien für audiovisuelle (Sprach-)Daten

Blumtritt, Jonathan; Rau, Felix ... 46 Rechtsfragen in DH-Projekten: Alles, was man wissen muss

Hannesschläger, Vanessa; Kamocki, Pawel; Scholger, Walter ... 49 Reisewege in Raum und Zeit

Aschauer, Anna; Büchler, Marco; Gradl, Tobias; Henrich, Andreas ... 53 Research Software Engineering und Digital Humanities. Reflexion, Kartierung,

Organisation.

Schrade, Torsten; Czmiel, Alexander; Druskat, Stephan ... 56 Suche und Visualisierung von Annotationen historischer Korpora mit ANNIS.

Kritik der korpuslinguistischen Analysemethoden in einem erweiterten Nutzungskontext

Odebrecht, Carolin; Krause, Thomas; Guescini, Rolf; Kühnlenz, Frank; Lüdeling, Anke; Dreyer, Malte ... 59

Müller-Birn, Claudia; Schelbert, Georg; Raspe, Martin; Wübbena, Thorsten ... 63 Workshop eComparatio: Textvergleich und digitaler Apparat

Schubert, Charlotte; Kahl, Hannes; Meins, Friedrich; Bräckel, Oliver ... 67 Zur Zukunft der Digitalen Briefedition – kooperative Lösungen im

kulturwissenschaftlichen Forschungsdaten-management

Strobel, Jochen; Bürger, Thomas ... 70

Panels

Abgrenzung oder Entgrenzung? Zum Spannungsverhältnis zwischen Historischen Hilfswissenschaften und Digital Humanities

Schulz, Daniela; Vogeler, Georg ... 75 Alles ist im Fluss - Ressourcen und Rezensionen in den Digital Humanities.

Neuber, Frederike; Henny-Krahmer, Ulrike; Sahle, Patrick; Fischer, Franz ... 78 Computergestützte Film- und Videoanalyse

Burghardt, Manuel; Heftberger, Adelheid; Müller-Birn, Claudia; Pause,

Johannes; Walkowski, Niels-Oliver; Zeppelzauer, Matthias ... 82 Der ferne Blick. Bildkorpora und Computer Vision in den Geistes- und

Kulturwissenschaften - Stand - Visionen - Implikationen

Donig, Simon; Handschuh, Siegfried; Radisch, Erik; Rehbein, Malte; Hastik,

Canan; Kohle, Hubertus; Ommer, Björn ... 86 Die Summe geisteswissenschaftlicher Methoden? Fachspezifisches

Datenmanagement als Voraussetzung zukunftsorientierten Forschens

Moeller, Katrin; Ďurčo, Matej; Ebert, Barbara; Lemaire, Marina; Rosenthaler, Lukas; Sahle, Patrick; Wuttke, Ulrike; Wettlaufer, Jörg ... 89 Gute Forschungsdaten, bessere Forschung: wie Forschung durch

Forschungsdaten-management unterstützt wird

Mache, Beata; Trippel, Thorsten; Effinger, Maria; Gradl, Tobias; Haaf, Susanne;

Hinrichs, Erhard; Horstmann, Wolfram; Müller, Lydia; Schrade, Torsten; Teich, Elke ... 94 musilonline - integral lösen. Dialogfeld Digitale Edition

Bosse, Anke; Fanta, Walter; Godler, Katharina; Brüning, Gerrit; Boelderl, Artur 98

„Storied Collections“? Ein kritischer Blick auf die Arbeit an digitalen (Musik)- Editionen

Stadler, Peter; Kepper, Johannes; Capelle, Irmlind; Oberhoff, Andreas ... 100

Vorträge

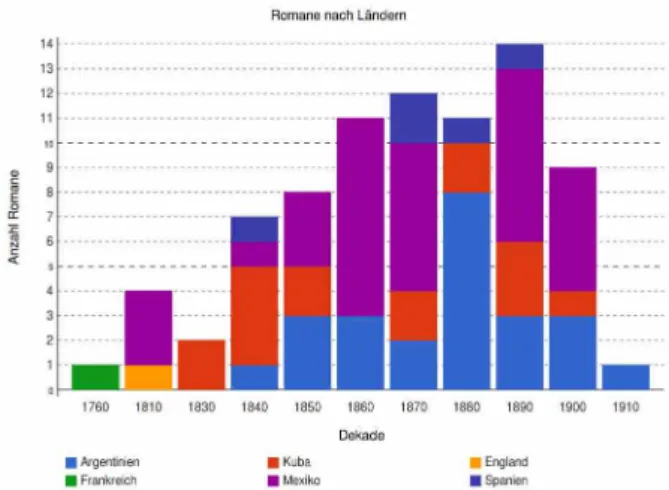

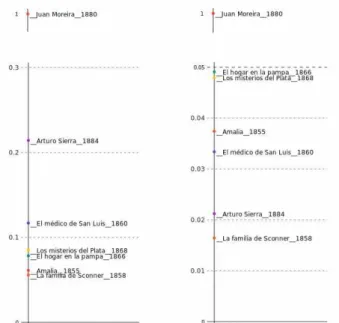

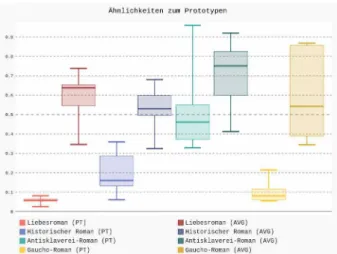

Alternative Gattungstheorien: Das Prototypenmodell am Beispiel hispanoamerikanischer Romane

Henny-Krahmer, Ulrike; Betz, Katrin; Schlör, Daniel; Hotho, Andreas ... 105 Ambiguität und Annotation: Herausforderungen von Automatisierung und

Digitalität

Zirker, Angelika ... 112 Analysing Direct Speech in German Novels

Jannidis, Fotis; Konle, Leonard; Zehe, Albin; Hotho, Andreas; Krug, Markus ... 114 An den Grenzen der Interoperabilität: Eine kritische Reflexion über digitale

Forschungsdaten und -anwendungen in der Online-Edition des Projekts "Die Schule von Salamanca"

Wagner, Andreas; Glück, David ... 119

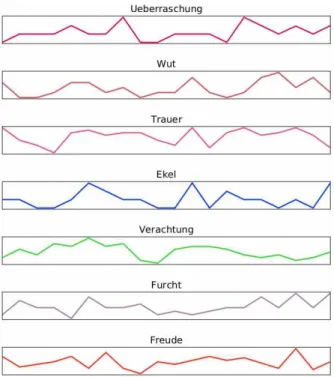

Barth, Florian; Kim, Evgeny; Murr, Sandra; Klinger, Roman ... 123 Auf der Suche nach der verlorenen Materialität. Kodikologie und

Restaurierungswissen-schaft im Zeitalter der (Massen-) Digitalisierung.

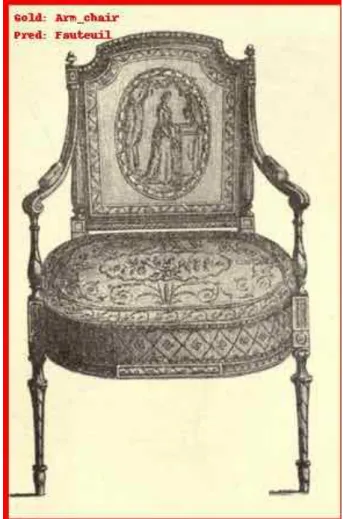

Busch, Hannah; Bös, Eva ... 127 Bildanalyse durch Distant Viewing - zur Identifizierung von klassizistischem

Mobiliar in Interieurdarstellungen.

Donig, Simon; Christoforaki, Maria; Bermeitinger, Bernhard; Handschuh,

Siegfried ... 130 Burrows Zeta: Varianten und Evaluation

Schöch, Christof; Zehe, Albin; Calvo Tello, José; Hotho, Andreas ... 138 Computationale Beschreibung visuellen Materials am Beispiel des Graphic

Narrative Corpus

Laubrock, Jochen; Dubray, David; Krügel, André ... 143 Contextualizing Bandera: Ein Distant Watching Ansatz

Bermeitinger, Bernhard; Howanitz, Gernot; Radisch, Erik ... 146 Critical Digital Cultural Studies: Digitale Kulturwissenschaft und die Kritik des

Mem-Begriffs

Ernst, Thomas ... 150 Cäsar Flaischlens „Graphische Litteratur-Tafel“ – digitale Erschließung einer

großformatigen Karte zur Deutschen Literatur

Börner, Ingo; Fischer, Frank; Hechtl, Angelika; Jäschke, Robert; Trilcke, Peer ... 153 Das neue "Gesetz zur Angleichung des Urheberrechts an die aktuellen

Erfordernisse der Wissensgesellschaft" und seine Auswirkungen für Digital Humanities

Kamocki, Pawel; Ketzan, Erik; Wildgans, Julia; Witt, Andreas ... 156 Data models for Digital Editions: Complex XML versus Graph structures

Bruder, Daniel; Teufel, Simone ... 158 Der Sammlung gerecht werden: Kritisch-generative Methoden zur Konzeption

experimenteller Visualisierungen

Dörk, Marian; Glinka, Katrin ... 162 Die Angst vor dem „Elektronengehirn“: Topoi der Kybernetik-Kritik in der

bundesdeutschen Nachkriegsphilosophie

Heßbrüggen-Walter, Stefan ... 166 Die guten ins Töpfchen: Zur Anwendbarkeit von Burrows’ Delta bei kurzen

mittelhochdeutschen Texten nebst eines Attributionstests zu Konrads ‚Halber Birne‘

Dimpel, Friedrich Michael ... 168 Die Ontologie historischer deutschprachiger Berufs- und Amtsbezeichnungen.

Interoperationalität und Berufsklassifizierung durch semantisches Topic Modeling

Nasarek, Robert; Moeller, Katrin ... 173 Digitale Differenz. Luhmanns Zettelkasten als physisch-historisches Objekt und

als vernetzter Navigationsraum

Goedel, Martina; Zimmer, Sebastian; Schmidt, Johannes ... 178 Digitale Methoden sind weder digital noch innovativ

Raunig, Michael; Höfler, Elke ... 181 Digitale Modellierung von Figurenkomplexität am Beispiel des Parzival von

Wolfram von Eschenbach

Braun, Manuel; Klinger, Roman; Padó, Sebastian; Viehhauser, Gabriel ... 184 Digitale Vernunft zwischen Text und Diagramm Digital Mapmaking als

Hilfsmittel zur Erklärung historischer Ereignisse

Frank, Ingo ... 187

Dokumentenarbeit mit hierarchisch strukturierten Texten: Eine historisch vergleichende Analyse von Verfassungen

Knoth, Alexander; Stede, Manfred; Hägert, Erik ... 196 Eine nachhaltige Präsentationsschicht für digitale Editionen

Fechner, Martin ... 203 Endstation Digital?! Herausforderung Metadaten und Nachhaltigkeit in

musikwissenschaftlichen Datenbanken

Blanken, Christine; Rettinghaus, Klaus ... 207 'Exakt Historisch' im Digitalen? Versuch einer Anleihe

Schilz, Andrea ... 209 Fachspezifische Herausforderungen in der Realisierung des webbasierten

digitalen Archivs THESPIS.DIGITAL

Löcker-Herschkowitz, Johannes A.; Wagner, Christian ... 213 Funktionale und deklarative Programmierung-basierte Methode für nachhaltige, reproduzierbare und verifizierbare Datenkuration.

Barabucci, Gioele ... 214 Ground Truth: Grundwahrheit oder Ad-Hoc-Lösung? Wo stehen die Digital

Humanities?

Boenig, Matthias; Federbusch, Maria; Herrmann, Elisa; Neudecker, Clemens;

Würzner, Kay-Michael ... 219 Hinterlistig – schelmisch – treulos – Sentiment Analyse in Texten des 19.

Jahrhunderts: Eine exemplarische Analyse für Länder und Ethnien

Wodausch, David; Fiedler, Maik; Heuwing, Ben; Mandl, Thomas ... 223 Hin zu einer Visuellen Stilometrie: Automatische Genre- und

Autorunterscheidung in graphischen Narrativen

Dunst, Alexander; Hartel, Rita ... 226 Historische Zeitungen kollaborativ erschließen: Die älteste, noch erscheinende

Tageszeitung der Welt “under annotation”

Resch, Claudia; Kampkaspar, Dario; Schopper, Daniel ... 229 Horizontales Lesen: Das "Verdi-Requiem" und die deutsche Kritik

Roeder, Torsten ... 232 Im Netz der Möglichkeiten - Wechselwirkungen in der Entwicklung von Theorie,

Methode und Tools in den Digital Humanities am Beispiel der TEI

Schaßan, Torsten ... 235 Interpretation und Unschärfe bei der semantischen Erschließung von

historischen Quellen

Hamisch, Juliane; Große, Peggy ... 237 Ist kooperativ jetzt umsonst? Die Ausweisung von Datenautorenschaft

als neue Form wissenschaftlicher Reputation zur Förderung offener Forschungsdatenkulturen

Moeller, Katrin ... 240

"Kann man denn auch nicht lachend sehr ernsthaft sein?" – Zum Einsatz von Sentiment Analyse-Verfahren für die quantitative Untersuchung von Lessings Dramen

Schmidt, Thomas; Burghardt, Manuel; Dennerlein, Katrin ... 244 Konsequenzen automatischer Texterkennung – Ein Aufriss zur Texterkennung

mit Machine Learning

Hodel, Tobias ... 249 Kritik der Digitalität (am Beispiel der digitalen Textwissenschaft)

Garcés, Juan; Bräuer, Johannes ... 252 Kulturelle Evolution. Zur Kritik der literaturhistorischen Methode

Lauer, Gerhard ... 254

Liebe und Tod in der Deutschen Nationalbibliothek Der DNB-Katalog als Forschungsobjekt der digitalen Literaturwissenschaft

Fischer, Frank; Jäschke, Robert ... 261 Modellieren durch mediale Transformation: Das Theater Brechts in der

virtuellen Realität

Wieners, Jan; Schubert, Zoe; Eide, Øyvind ... 266 Nachnutzbarmachung von Forschungsdaten und Tools am Beispiel

altäthiopischer Korpora

Druskat, Stephan; Vertan, Cristina ... 270 Neue Wahlverwandtschaften

Althof, Daniel ... 274 Objekte im Netz – Die Digitalisierung der Sammlungen der Universität Erlangen-

Nürnberg als Gegenstand und Methode.

Wagner, Sarah; Scholz, Martin; Andraschke, Udo ... 276 Perspektiven kritischer Interfaces für die Digital Humanities im 3DH-Projekt

Kleymann, Rabea; Meister, Jan Christoph; Stange, Jan-Erik ... 279 Positivistischer Methodenfetischismus als Anathema der digitalen

Geisteswissenschaften

Arnold, Eckhart ... 284 Praktische Tagger-Kritik. Zur Evaluation des POS-Tagging des Deutschen

Textarchivs

Herrmann, J. Berenike ... 287 Principles Aiding in Reading Abbreviations in OldGeorgian and Latin

Hoenen, Armin; Samushia, Lela ... 290 Quantitatives „close reading“? Vier mikroanalytische Methoden der digitalen

Dramenanalyse im Vergleich.

Krautter, Benjamin ... 295 Realität programmieren? Zum Einfluss von Algorithmen auf die Wirklichkeit

Pfeiffer, Jasmin ... 300 SANTA: Systematische Analyse Narrativer Texte durch Annotation

Gius, Evelyn; Reiter, Nils; Strötgen, Jannik; Willand, Marcus ... 302 Sentimentanalyse in unstrukturierten Texten (am Bsp. literaturgeschichtlicher

Rezeptionsanalyse)

Mellmann, Katja; Du, Keli ... 305

„Software Aging“ in den DH: Kritik des reinen Forschungswillen

Bürgermeister, Martina; Schneider, Gerlinde; Makowski, Stephan; Jeller, Daniel;

Bigalke, Jan; Theisen, Christian; Vogeler, Georg ... 308 Sprachliche Variation in der Germanistik: eine n-Gramm-basierte Stilanalyse

Andresen, Melanie ... 311 The 'Tiroler Soldaten-Zeitung' and its Authors. A Computer-Aided Search for

Robert Musil

Salgaro, Massimo; Rebora, Simone; Lauer, Gerhard; Herrmann, J. Berenike ... 315 Vagheit hoch Zweifel plus Kritik! Die Bewertung von Widersprüchen in einer

digitalen Entzifferungsarbeit der Maya-Hieroglyphen

Gronemeyer, Sven; Diehr, Franziska; Prager, Christian; Diederichs, Katja;

Wagner, Elisabeth; Brodhun, Maximilian; Grube, Nikolai ... 320 Wahrnehmung und digitale Mustererkennung am Beispiel antiker

Terrakottastatuetten

Böttger, Lucie; Zeckey, Alexander; Langner, Martin ... 323 Was Lesende denken: Assoziationen zu Büchern in Sozialen Medien

Beck, Jens; Willand, Marcus; Reiter, Nils ... 327

Hellrich, Johannes; Stöger, Alexander; Hahn, Udo ... 331 What do you do with 5 million posts? Versuche zum distant reading religiöser

Online-Foren

Pfahler, Lukas; Elwert, Frederik; Tabti, Samira; Morik, Katharina; Krech,

Volker ... 335 Wissenschaft ohne Geist: Herausforderungen der Digital Humanities am Beispiel der Korpuslinguistik

Bubenhofer, Noah ... 338 Zur Weiterentwicklung des “cognition support”: Sammlungs-visualisierungen als Austragungsort kritisch-kulturwissenschaftlicher Forschung

Windhager, Florian; Glinka, Katrin; Mayr, Eva; Schreder, Günther; Dörk,

Marian ... 341 Zwischen Polysemie und Formalisierung: Mehrstufige Modellierung komplexer

intertextueller Relationen als Annäherung an ein ‚literarisches‘ Semantic Web

Nantke, Julia; Schlupkothen, Frederik ... 345

Poster

Ambraser Heldenbuch: Transkription und wissenschaftliches Datenset

Sojer, Claudia; Tratter, Aaron Rudolf ... 351 Annotationen anhand der Gemeinsamen Normdatei aus einer

anwendungsorientierten Perspektive historischer Forschung

Lordick, Harald; Mache, Beata ... 352 Aufdecken von “versteckten” Einflüssen: Teil-Automatisierte Textgenetische

Prozesse mit Methoden der Computerlinguistik und des Machine Learning

Ullrich, Sabine; Bruder, Daniel; Hadersbeck, Maximilian ... 355 Aus erster Hand – 3000 Jahre Kursivschrift der Pharaonenzeit digital analysiert

Gerhards, Simone; Gülden, Svenja A.; Konrad, Tobias; Leuk, Michael;

Verhoeven-van Elsbergen, Ursula; Rapp, Andrea ... 357 BeWeB-3D – Zur Digitalisierung interaktiver Buchobjekte

Hug, Marius ... 359 Biographik in den Digital Humanities – Kritische Bestandsaufnahme und

quantitative Analysemöglichkeiten am Beispiel des Österreichischen Biographischen Lexikons 1815–1950

Schlögl, Matthias; Bernád, Ágoston; Kaiser, Maximilian; Lejtovicz, Katalin;

Rumpolt, Peter ... 360 Chancen und Grenzen von Digitalen Methoden zur Analyse der politischen

Meinungsbildung in Sozialen Medien

Guhr, Svenja; Pannach, Franziska; Ziehe, Stefan; Knauth, Jürgen; Kauf, Carina;

Sporleder, Caroline ... 363 CLARIN Legal Information Plattformen und Legal Helpdesk

Kamocki, Pawel; Ketzan, Erik; Wildgans, Julia; Witt, Andreas ... 365 Delta vs. N-Gram-Tracing: Wie robust ist die Autorschafts-attribuierung?

Proisl, Thomas; Evert, Stefan ... 366 Denkmalpflege in der DDR. Analoge Netzwerke digital – Chancen und

Möglichkeiten

Klemstein, Franziska ... 369 Deutsche Geschichte-Digital: Ergebnisse der TEI-Konvertierung und Integration

in Pilotprojekten

Hiebert, Matthew; Lässig, Simone; Witt, Andreas ... 371 DH-Toolvergleich im Hinblick auf Texte historischer Sprachstufen

Aehnlich, Barbara; Seidel, Henry ... 373

Koch, Carina ... 374 Die Macht der Daten - vom konsequenten Umgang mit Forschungsdaten

Gálffy, Andreas; Kamphausen, Julian; Kronenwett, Simone; Wieners, Jan G. ... 376 Die Max-Bense-Collection. Digitale Re-Publikation von Erstausgaben mit

erweiterten Plattformfunktionen

Schlesinger, Claus-Michael ... 378 Digital Dylan – Computergestützte Analyse der Liedtexte von Bob Dylan (1962 –

2016)

Sippl, Colin; Fuchs, Florian; Burghardt, Manuel ... 379 Digitale Wissenschaft – Eine Podcastreihe

Loebel, Jens-Martin; Hahn, Carolin ... 383 Digital Medievalist: A Web Community for Medievalists working with Digital

Media

Franzini, Greta; Fischer, Franz; Kestemont, Mike ... 385 Digital vs. Humanities. Didaktische Aufbereitung digitaler Methoden für die

klassischen Geisteswissenschaften im Projekt forTEXT

Jacke, Janina; Horstmann, Jan; Meister, Jan Christoph ... 386 Digitized Inhumanities: Qualitative Inhaltsanalyse von Hexenprozessakten mit

MAXQDA

Müller, Andreas ... 391 DISCO: Diachronic Spanish Sonnet Corpus

Ruiz Fabo, Pablo; Martínez Cantón, Clara; Calvo Tello, José ... 394 Dramenquartett – Eine didaktische Intervention

Fischer, Frank; Kittel, Christopher; Milling, Carsten; Trilcke, Peer; Wolf, Jana ... 397 Ein Brief – zwei Perspektiven. Stellenkommentare in digitalen Briefeditionen

über APIs austauschen

Dumont, Stefan ... 398 Eine Fallstudie zur Annotation von Vagheit in Werken Dimitrie Cantemirs

Vertan, Cristina; von Hahn, Walther ... 400 ELEXIS – Eine europäische Forschungsinfrastruktur für lexikographische Daten

Wissik, Tanja; Krek, Simon; Jakubicek, Milos; Tiberius, Carole; Navigli, Roberto;

McCrae, John; Tasovac, Toma; Varadi, Tamas; Koeva, Svetla; Costa, Rute;

Kernerman, Ilan; Monachini, Monica; Trap-Jensen, Lars; Pedersen, Bolette S.;

Hildenbrandt, Vera; Kallas, Jelena; Porta-Zamorano, Jordi ... 401 Entitäten im Fokus am Beispiel von Captivity Narratives

Kessler, Linda; Braun, Tamara; Preuß, Tanja ... 403 Entwicklungsstand im Projekt 'Digital Plato'

Kath, Roxana; Keilholz, Franz; Pöckelmann, Marcus; Rücker, Michaela;

Wöckener-Gade, Eva; Yu, Xiaozhou ... 405 erschließen - verknüpfen - finden: Forschungsdaten im Digitalen

Wissensspeicher

Czmiel, Alexander; Grabsch, Sascha; Jürgens, Marco; Maiwald, Anke;

Willenborg, Josef ... 407 Formalisierung von Märchen

Declerck, Thierry; Aman, Anastasija; Grünewald, Stefan; Lindemann, Matthias;

Schäfer, Lisa; Skachkova, Natalia ... 409 hermA. Zur Rolle von Annotationen in hermeneutischen Prozessen

Adelmann, Benedikt; Andresen, Melanie; Begerow, Anke; Gaidys, Uta; Gius, Evelyn; Koch, Gertraud; Menzel, Wolfgang; Orth, Dominik; Topp, Sebastian;

Vauth, Michael; Zinsmeister, Heike ... 412 IncipitSearch - Vernetzung musikwissenschaftlicher Vorhaben

Neovesky, Anna; von Vlahovits, Frederic ... 414

Ergebnisse

Romanello, Matteo; Gradl, Tobias ... 416

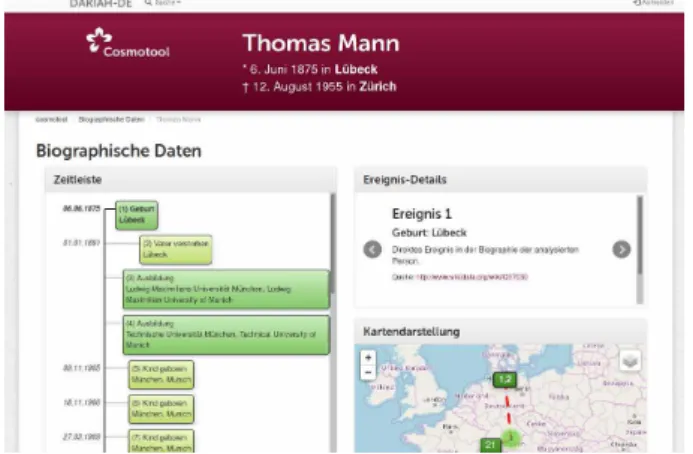

“Kann man da eben mal was eintragen und visualisieren?” Digitaler Praxistest für die DARIAH-DE-Infrastruktur

Klaffki, Lisa; Steyer, Timo ... 421

"Kinder des Buchdrucks" im Digitalen Zeitalter. Ein romanistisches Digital Humanities Modul

Burr, Elisabeth; Fußbahn, Ulrike ... 423 Kleriker des Alten Reiches in der Digitalen Welt. Das Forschungsportal Germania Sacra Online

Kröger, Bärbel; Popp, Christian ... 425 Kollaborativ arbeiten und annotieren – Die Forschungsinfrastruktur des

Spezialforschungs-bereichs Deutsch in Österreich

Seltmann, Melanie; Breuer, Ludwig Maximilian; Heinisch, Barbara ... 426 LDA Topic Modeling über ein graphisches Interface

Simmler, Severin; Vitt, Thorsten; Pielström, Steffen ... 428 MEDEA: Datenkonsistenz mittels Ontologie

Pollin, Christopher; Vogeler, Georg ... 429 Memes produzieren digitale Gefühle: Die Simpsons deuten Trump-Mania(c)

Haas, Gabriele; Koumpis, Adamantios; Handschuh, Siegfried ... 430 Menschen gendern? Einige Gedanken über Datenmodellierung zur Erhebung

von Geschlechterverteilung anhand der TEI2016 Abstracts App

Hannesschläger, Vanessa; Andorfer, Peter ... 435 MeuchelmörderInnen, KindsmörderInnen, DiebInnen und die dazugehörigen

Tatbestände: Erstellung eines Thesaurus für das österreichische Strafrecht des 18. Jahrhunderts zur Erschließung einer Flugblattsammlung

Wissik, Tanja; Resch, Claudia ... 437 Netzwerkanalytischer Blick auf die Dramen Anton Tschechows

Faynberg, Veronika; Fischer, Frank; Lashchuk, Svetlana; Orlova, Tatyana;

Palchikov, German; Shlosman, Evgenia ... 439 NLP meets RegNLP meets Regesta Imperii

Blessing, Andre; Kuczera, Andreas ... 440 Nutzertests an kritischen Editionen - Print oder digital?

Caria, Federico; Mathiak, Brigitte ... 442 Peer-to-Peer statt Client-Server: Der Mehrwert kollegialer Beratung und agiler

DH-Treffen

Steyer, Timo; Dogunke, Swantje; Mayer, Corinna; Neumann, Katrin; Cremer,

Fabian; Wübbena, Thorsten ... 447 Personen- und Figurennetzwerke in Fernando Pessoas Publikationsplänen

Bigalke, Ben; Drach, Sviatoslav; Henny-Krahmer, Ulrike; Sepúlveda, Pedro;

Theisen, Christian ... 448 Perspektiven auf ein Korpus. Kombinationen quantitativ-qualitativer

Analysemethoden zur Ermittlung von Textgliederungsprinzipien

Haaf, Susanne ... 453 Professionalisierung der Ausbildung von Geisteswissenschaftlern in der

Digitalisierung von Texten

Dahnke, Michael ... 455 Projektvorstellung – Redewiedergabe. Eine literatur- und

sprachwissenschaftliche Korpusanalyse

Brunner, Annelen; Engelberg, Stefan; Jannidis, Fotis; Tu, Ngoc Duyen Tanja;

Weimer, Lukas ... 458

Burckhardt, Daniel; Menny, Anna ... 460 Science as a Service? Chancen und Limits von serviceorientierten

Softwarearchitekturen für die Digital Humanities

Hoffmann, Christoph ... 461 Sechs Wege der FRBRisierung von Textverknüpfungen

Helling, Patrick; Mathiak, Brigitte ... 462 Semantische Extraktion auf antiken Schriften am Beispiel von

Keilschriftsprachen mithilfe semantischer Wörterbücher

Homburg, Timo ... 464 Stadtgeschichtliche Forschung und Vermittlung anhand historischer Fotos als

Forschungsgegenstand – Ein Zwischenbericht der Nachwuchsgruppe HistStadt4D Münster, Sander; Barthel, Kristina; Bruschke, Jonas; Friedrichs, Kristina;

Kröber, Cindy; Maywald, Ferdinand; Niebling, Florian ... 466 Strings&Structures

Rolshoven, Jürgen; Etimi, Valmir; Seipel, Peter; Wiehe, Thomas ... 470 SustainLife - Erhalt lebender, digitaler Systeme für die Geisteswissenschaften

Barzen, Johanna; Blumtritt, Jonathan; Breitenbücher, Uwe; Kronenwett,

Simone; Leymann, Frank; Mathiak, Brigitte; Neuefeind, Claes ... 471 Syndred - A Syntax-Driven Editor for Lexical Resources

Mondaca, Francisco; Rolshoven, Jürgen; Schildkamp, Philip; Vogt, Andreas ... 474 TEASys: Kollaboratives digitales Annotieren als Lehr- und Lernprozess

Zirker, Angelika; Bauer, Matthias; Kirchhoff, Leonie; Lahrsow, Miriam ... 475 TEI-Editionswerkstatt Urkunden@UPB.

Schwengelbeck, Isabel; Wahl, Dominik; Foester, Karl; Friedl, Dennis; Fluss, Fabian; Mersch, Isabelle; Voss, Fabian; Dröge, Martin; Stadler, Peter; Voges,

Ramon ... 476 TEIHencer - Enhance your TEI-Documents

Andorfer, Peter; Karner, Stefan ... 478 Text Mining und Computersimulation zur Analyse autobiographischer Texte:

Einflüsse auf das literarische Schaffen Klaus Manns

Hess, Jan; Lebherz, Daniel; Zeyen, Christian ... 480 Universal Morphology zwischen Sprachtechnologie und Sprachwissenschaft:

Sprachressourcen für Kaukasussprachen

Chiarcos, Christian; Donandt, Kathrin; Ionov, Maxim; Rind-Pawlowski, Monika;

Sargsian, Hasmik; Wichers Schreur, Jesse ... 482 VedaWeb – eine webbasierte Plattform für die Erforschung altindischer Texte

Reinöhl, Uta; Kölligan, Daniel; Kiss, Börge; Mondaca, Francisco; Neuefeind,

Claes; Sahle, Patrick ... 485 Verhaltensmuster in Massendiskursen: Ein Opinion Dynamics - Modell

Heckelen, Malte ... 487 Virtuelle Ausstellungen und Rundgänge: digitalisiertes Kulturerbe vermitteln

und präsentieren

Steiner, Elisabeth ... 488 Vom geschützt zugänglichen Datenbankverbund zur offenen Editions- und

Forschungsplattform: kritischer Rückblick auf halber Strecke

Forney, Christian; Rojas Castro, Antonio; Dängeli, Peter ... 490 Von Drupal 8 zur virtuellen Forschungsumgebung - Der WissKI-Ansatz

Fichtner, Mark ... 493

Index der Autorinnen und Autoren ... 495

Keynotes

Der ‚Stachel des Digitalen‘ - ein Anreiz zur

Selbstreflexion in den Geisteswissenschaften?

Krämer, Sybille

sybkram@zedat.fu-berlin.de

Freie Universität Berlin, Deutschland, Institut für Philosophie

Geht es um eine Kritik an der digitalen Vernunft? Oder kann die ‚digitale Vernunft‘ ihrerseits eine kritische Perspektive eröffnen, insofern ‚der Stachel‘ ihrer Praktiken das Selbstverständnis von Geistes- wissenschaften herausfordert? Die leitende Idee ist, dass ein Nachdenken über die ‚strukturentdecken- den ‘, über ‚datengetriebene‘ algorithmische Forschungsverfahren der Digital Humanities die Geistes- und Kulturwissenschaften anregen kann (oder anregen sollte) zu einer Metareflexion, durch welche auch die Verfahrensweisen ‚herkömmlicher‘ geistes- und kulturwissenschaftlicher Forschungsarbeit neu beleuchtet werden. Der dabei eingenommene methodische Gesichtspunkt ist ein praxeologischer:

Was eine Wissenschaft ist, zeigt sich im Insgesamt ihres Forschungs-, Lehr- und Vermittlungshandelns.

Alle Geistes- und Kulturwissenschaften zielen darauf, etwas das Texten, Bildern, Artefakten impli- zit ist, explizit zu machen – ob nun durch traditionelle Interpretation oder algorithmische Datenana- lyse. Doch bereits diese Unterscheidung von ‚Interpretation‘ und ‚Datenanalyse‘ hinkt, denn es gibt we- der rohe Daten noch material- und texturunabhängige Interpretationen. Doch wenn das so ist: Warum sollte eine maschinelle – im Idealfall statistisch-empirische - Auswertung großer Datenbestände die her- kömmlichen geisteswissenschaftlichen Verfahrensweisen in neuem Licht erscheinen lassen?

Kritik der digitalen Vernunft

Sperberg-McQueen, C. Michael

cmsmcq@blackmesatech.com

Black Mesa Technologies LLC, New Mexico

Die Organisatoren der Tagung stellen den Teilnehmern die Frage: "Gibt es im Umgang mit digitalen Medien, in der Modellierung, Operationalisierung und Formalisierung der Arbeit mit Computern im- plizite, stillschweigend akzeptierte Agenden, die einer Reflexion durch einen „Intellectual Criticism“

bedürfen?" Wie sähe ein solcher Intellectual Criticism aus? Worauf könnte er basieren?

In den drei großen Kritiken der reinen Vernunft, der praktischen Vernunft, und der Urteilskraft hat Kant eine 'kopernikanische Revolution' in der Philosophie mit dem Postulat eingeleitet, unsere Erkennt- nis richte sich nicht nach den Dingen, sondern die Dinge richten sich nach unserer Erkenntnis: d.h.

nach den apriorischen Formen der Anschauung und nach den vorgegebenen Begriffen des Verstandes (die Kategorient).

Gibt es apriorische Formen, die den zu bearbeitenden Stoff der digitalen Vernunft bestimmen, ähnlich wie Zeit und Raum die menschliche Anschauung bestimmen? Gibt es vorgegebene Begriffe, die aller digitalen Vernunftarbeit zu Grunde liegen? Wie verhält es sich im digitalen Raum mit der Eigenverant- wortung und der Autonomie, die nach Kant das Wesen der Aufklärung und der Freiheit ausmachen?

Workshops

Annotation and beyond – Using ATHEN Annotation and Text Highlighting Environment

Krug, Markus

markus.krug@uni-wuerzburg.de Universität Würzburg, Deutschland

Tu, Ngoc Duyen Tanja

tu@ids-mannheim.de

Institut für Deutsche Sprache, Deutschland

Weimer, Lukas

lukas.weimer@uni-wuerzburg.de Universität Würzburg, Deutschland

Reger, Isabella

isabella.reger@uni-wuerzburg.de Universität Würzburg, Deutschland

Konle, Leonard

leonard.konle@uni-wuerzburg.de Universität Würzburg, Deutschland

Jannidis, Fotis

fotis.jannidis@uni-wuerzburg.de Universität Würzburg, Deutschland

Puppe, Frank

puppe@informatik.uni-wuerzburg.de Universität Würzburg, Deutschland

Goals of the workshop

The workshop presents ATHEN 1 (Annotation and Text Highlighting Environment), an extensi- ble desktop-based annotation environment which supports more than just regular annotation. Be- sides being a general purpose annotation envi- ronment, ATHEN supports indexing and query- ing support of your data as well as the ability to automatically preprocess your data with Meta in- formation. It is especially suited for those who want to extend existing general purpose annota- tion tools by implementing their own custom fea-

tures, which cannot be fulfilled by other available annotation environments. On the according git- lab, we provide online tutorials, which demons- trate the use of specific features of ATHEN.

Related Work

We compare ATHEN to three web-based and four desktop applications in 12 categories by ad- apting most criteria defined by Neves and Leser (Neves / Leser 2012) to compare different annota- tion tools:

1. Availability and up-to-dateness of the docu- mentation

2. Active development at the present time 3. Source code for download

4. Complexity of system requirements

5. Interoperability by supporting certain formats 6. Support of different annotation layers

7. Support of NLP-preprocessing to speed up ma- nual annotation

8. Support of visualization

9. Support of self-learning systems to speed up manual annotation

10. Support of querying annotated data 11. Possibility to do an inter-annotator-agree-

ment, this is important for projects, in which more than one annotator labels the same do- cuments

12. Extensibility

We explicitly do not want to compare subjective features like usability or how the annotations are presented.

Table 1: Comparison of three web-based and four desktop applications with ATHEN in twelve categories. No tool excels in every category.

All of the listed tools have an accessible docu- mentation, either web-based or as a PDF, avail- able for download. Besides UAM (O'Donnell 2008), every other application is listed as open source, so at least extensions based on code level can be made. WebAnno (Yimam et al. 2013) is the only

application having a tutorial supporting a new de- veloper to make changes in their project. ATHEN stands out in the sense that extensions to its UI can be made at runtime, therefore easing the pro- cess of adding functionality to it. WebAnno sup- ports the largest number of formats and comes with a machine learning based automatic anno- tation, however lacks integrated NLP-preproces- sing. CATMA (Meister 2017) is the only project that has a very good visualization component and also supports TEI-XML (Wittern et al 2009), the unspo- ken standard of text processing. Being a standa- lone web application, CATMA itself does not sup- port NLP-preprocessing. ATHEN comes with the support of the execution of UIMA analysis engi- nes, accessible from web repositories or a local repository, giving the user a chance to integrate her custom-made annotators. Four tools, ATHEN, UAM, MMAX2 (Müller / Strube 2006) and CATMA feature an integrated query language which helps to analyze existing corpora. Most tools allow the annotation of user-defined annotation schemas earning therefore the title “generic annotation tool”. Alongside UAM, ATHEN supports the anno- tation based on queries, while UAM defines its own language, ATHEN supports the annotation using Apache UIMA Ruta (Kluegl et al. 2016) ru- les. Three of the listed tools, MMAX2, Knowtator (Ogren 2006) and WordFreak (Morton / LaCivita 2003) are currently no longer in active develop- ment.

Brief technological description of ATHEN

ATHEN is a Java-based desktop application with the vision to be extensible. Therefore, it makes use of the flexible plugin architecture of the eclipse Rich- Client- Platform (RCP) 2. Internally, it is built around Apache UIMA, which means incom- ing data is automatically converted into the UIMA specific Common Analysis Subject (CAS) architec- ture. Working with UIMA allows the integration of standalone analysis engines, which can be used to preprocess data and speed up manual annota- tion. The use of Apache Lucene enables ATHEN to create an index comprising documents, as well as their annotations, which results in queries that can answer questions based on text and meta in- formation in real time. With the ability to execute Apache UIMA Ruta one can even create queries of far higher complexity. On top of that, ATHEN fea- tures OWL-Support, which allows the definition of an ontological annotation schema in a machine- readable format. Using Apache UIMA internally allows ATHEN to even address more complicated

input. Currently ATHEN supports the annotation of image regions, based on user defined polygons.

Program of the workshop

The program is split into four sections:

1. Introduction to ATHEN and distinguishing from other existing annotation environments.

2. Working with ATHEN, which contains the de- finition of scenarios and annotating sample documents.

3. Utility of ATHEN (beyond regular annotation), which addresses the following topics:

1. Defining an annotation schema using OWL 2. Preprocessing texts based on Apache UIMA

Analysis Engines

3. Creating and executing queries based on Apache Lucene

4. Annotating images with ATHEN

4. Extending ATHENs functionalities and adapt- ing it to your needs (developer specific)

The first section is a presentation which shows the main differences between the existing anno- tation tools. The second section defines an or- dinary annotation scenario and it is used to in- troduce the participants to the general-purpose annotation view of ATHEN. Afterwards, for tasks to which ATHEN has special support (annotating character references and their coreferences, an- notating direct speech and their speaker) an intro- duction to the special purpose views of ATHEN is given.

The third panel introduces the participants to the functionality of ATHEN beyond regular text annotation. It starts with the definition of an OWL ontology (and its utilization for texts). This is cen- tered on relation detection of character referen- ces, as well as an attribution of those references.

To speed up manual annotation it is helpful to have it preprocessed with existing tools. The task definition is then changed from pure annotation to an application with a consecutive correction of the output of the automatic engines. In this con- text, Nappi, a submodule of ATHEN is presented and it is shown how to define, execute and inte- grate custom analysis engines.

The next part is dedicated towards extracting knowledge from annotated data, for this purpose, an Apache Lucene Index is created using ATHEN and is queried in a live fashion. This feature al- lows rapid insight into an existing corpus and enables the user to answer their own hypothesis.

The tutorial continues with the presentation of how images can be annotated with polygon-based

annotations to show, that ATHEN is not only limi- ted to textual resources.

The last part is directed towards Java developers who are interested in developing their own anno- tation component.

Each section starts with a set of slides which in- troduce the features in focus and presents the par- ticipants with one or more tasks that can be fulfil- led by using ATHEN.

Requirements

The participants need their own laptops with an active internet connection. The number of partici- pants is limited to 15 to 20. The last section requi- res knowledge of Java. Data which is necessary for the tutorials will be hosted on our own server and will be made accessible for download.

Research projects

ATHEN is mainly developed in the context of the project Kallimachos at the University of Wuerz- burg. Its main purpose was to support the annota- tion process of DROC ( Deutscher ROman Corpus).

Currently automatic creation of literary interac- tion networks, automatic genre detection of no- vels and sentiment analysis in literary novels are in the focus of interest.

An extension to ATHEN was made in the project

“Redewiedergabe” to manually annotate different forms of speech, thought and writing representa- tion (STWR). These annotations will then be used to train an automatic recognizer for STWR.

Fußnoten

1. https://gitlab2.informatik.uni-wuerzbur- g.de/kallimachos/Athen

2. A web version of ATHEN with its major fea- tures is available at: https://webathen.informati- k.uni-wuerzburg.de

Bibliographie

Kluegl, Peter / Toepfer, Martin / Beck, Phi- lip-Daniel / Fette, Georg / Puppe, Frank (2016):

“UIMA Ruta: Rapid Development of Rule-based Information Extraction Applications“, in: Natural Language Engineering 22.1 1-41.

Meister, Jan Christoph / Gius, Evelyn / Jacke, Janina / Petris, Marco: CATMA 5.0. http://cat- ma.de/ [Accessed September 22, 2017].

Morton, Thomas / LaCivita, Jeremy (2003):

“WordFreak: an open tool for linguistic annota- tion“, in: Proceedings of the 2003 Conference of the North American Chapter of the Association for Computational Linguistics on Human Language Technology: Demonstrations-Volume 4 17-18.

Müller, Christoph / Strube, Michael (2006):

“Multi-level annotation of linguistic data with MMAX“, in : Corpus technology and language pe- dagogy: New resources, new tools, new methods 3 197-214.

Neves, Mariana / Leser, Ulf (2012): “A survey on annotation tools for the biomedical literature“, in: Briefings in Bioinformatics 15.2 327-340.

O'Donnell, Mick (2008): “Demonstration of the UAM CorpusTool for text and image annotation“, in: Proceedings of the 46th annual meeting of the Association for computational linguistics on hu- man language technologies: Demo session 13-16.

Ogren, Philip V. (2006): “Knowtator: a Protégé plug-in for annotated corpus construction“, in:

Proceedings of the 2006 Conference of the North American Chapter of the Association for Compu- tational Linguistics on Human Language Techno- logy: companion volume: demonstrations 273-275.

Stenetorp, Pontus / Pyysalo, Sampo / Topić, Goran / Ohta, Tomoko / Ananiadou, Sophia / Tsujii, Jun’ichi (2012): “BRAT: a Web-based Tool for NLP-Assisted Text Annotation“, in : Procee- dings of the Demonstrations at the 13th Conference of the European Chapter of the Association for Computational Linguistics 102-107.

Wittern, Christian / Ciula, Arianna / Tuohy, Conal (2009): “The making of TEI P5“, in: Literary and Linguistic Computing 24.3 281-296.

Yimam, Seid Muhie / Gurevych, Iryna / de Cas- tilho, Richard Eckart / Biemann, Chris (2013):

“WebAnno: A Flexible, Web-based and Visually Supported System for Distributed Annotations“, in: Proceedings of ACL-2013, demo session, Sofia, Bulgaria 1-6 .

Audio Mining für die Geistes- und

Kulturwissenschaften:

Nutzungsszenarien und Herausforderungen

Köhler, Joachim

joachim.koehler@iais.fraunhofer.de Fraunhofer IAIS

Leh, Almut

almut.leh@fernuni-hagen.de FernUniversität in Hagen

Himmelmann, Nikolaus

sprachwissenschaft@uni-koeln.de Universität zu Köln, Deutschland

Rau, Felix

f.rau@uni-koeln.de

Universität zu Köln, Deutschland

Workshopleiterinnen und -lei- ter

• Nikolaus P. Himmelmann, Universität zu Köln,

• Joachim Köhler, Fraunhofer IAIS,

• Almuth Leh, FernUniversität in Hagen,

• Felix Rau, Universität zu Köln,

Ort

Der Workshop findet in Raum S16 des Seminar- gebäudes (Gebäude 106) der Universität zu Köln statt.

Programm

Zum Workshop gibt es Beiträge, die primär aus Entwicklerperspektive das Thema angehen, und solche, die eher eine Anwenderperspektive ein- nehmen, wobei das keine scharfe Trennung ist.

Aus Entwicklerperspektive berichten Alexandre Arkhipov vom Hamburger Zentrum für Sprach- korpora, Christoph Draxler vom Bayerisches Schallarchiv (LMU), Jens Gorisch vom IDS Mann- heim, Joachim Köhler vom Fraunhofer IAIS sowie Burkhard Meyer-Sickendiek und Hussein Hussein von der FU Berlin über Audiomining Werkzeuge, die bei Ihnen entwickelt wurden und werden.

Aus der Anwenderperspektive stellen Thomas Beckers vom WDR, Thorsten Dresing von der Firma audiotranskription (Marburg), Almuth Leh von der FernUniversität Hagen sowie Anna-Ma- ria Götz, Annabelle Petschow & Ruth Rosenberger von der Stiftung Haus der Geschichte der Bundes- republik Deutschland (Bonn) Herausforderungen für die automatischen Spracherkennung in unter- schiedlichen Anwendungsbereichen dar.

Ein detailliertes Programm ist Ende Januar über die Webseite des KA3 Projekts zugänglich. Im An- schluss an die Beiträge gibt es jeweils Gelegen-

heit zu Fragen und kurzer Diskussion. Am Schluss des Workshops gibt es eine kurze Abschlussdis- kussion. Workshopsprache ist Deutsch, Beiträge können aber auch auf Englisch präsentiert wer- den.

Weitere Details zum Thema

Moderne intelligente Analyse- und Auswer- tungsmethoden für Audiodaten ermöglichen ef- fektivere Arbeitsweisen und neue Fragestellun- gen in den Geistes- und Kulturwissenschaften.

Dieser Workshop soll Fortschritte, Herausforde- rungen und Perspektiven im Audio Mining prä- sentieren und Forscherinnen und Forscher aus dem Bereich der Sprachtechnologie mit (potenti- ellen) Nutzerinnen und Nutzern aus den Geistes- und Kulturwissenschaften zusammenbringen.

Audiovisuelle (multimodale) Primärdaten spie- len eine zunehmend größer werdende Rolle in den Geistes‐ und Kulturwissenschaften. Einfacher und kostengünstiger werdende Aufnahme- und Speicherungstechniken für Audio- und Videoda- ten ermöglichen die Erhebung von immer um- fangreicheren Datensets. Die wissenschaftliche Analyse und Auswertung dieser Daten basiert aber weiterhin überwiegend auf Transkripten, also konvertiert ins schriftsprachliche Medium.

Dabei gehen wesentliche Merkmale dieses Da- tentyps (Sprechmelodie, Stimmqualitäten, Gestik, Mimik etc.) verloren. Selbst wenn die Primärda- ten als audiovisuelle Daten analysiert werden ge- schieht dies meist durch arbeitsintensive manu- elle Segmentierung und Annotation.

Von zunehmender Bedeutung ist auch die Nach- nutzung audiovisueller Daten, namentlich quali- tativer Interviews, wie sie in fast allen Geistes- und Kulturwissenschaften eine Rolle spielen. AV- Daten stellen schon allein aufgrund ihres gro- ßen Umfangs besondere Herausforderungen dar für den flexiblen und systematischen Zugriff wie auch eine zweckmäßige langfristige Speicherung.

Es bedarf einer Arbeitsumgebung, in der flexibel online auf den gesamten Datensatz zugegriffen werden kann und je nach Bedarf Unterkorpora definiert werden können. Für die einschlägigen Archive, Medienzentren und Dokumentations- stellen ermöglicht das Audio Mining eine nutzer- spezifische Recherche in der Gesamtdatenmenge bei direktem Zugriff auf das Audiosignal und se- kundengenauer Trefferanzeige. Dadurch wird die Ermittlung und Bereitstellung relevanter Daten für Sekundäranalysen erheblich verbessert.

Der Einsatz von intelligenten Analyse- und Aus- wertungsmethoden für multimodale Daten ge- winnt vor diesem Hintergrund in den letzten Jah- ren stark an Bedeutung. Fortschritte im Bereich

des maschinellen Lernens ermöglichen stärker automatisierte Arten der Datenanalyse und füh- ren zu einer weniger zeit- und arbeitsintensiven Aufbereitung. Diese Analysemethoden operieren darüber hinaus auf den audiovisuellen Primärda- ten und nicht auf textuellen Derivaten.

Im Vergleich zu Textdaten sind die Möglichkei- ten der Analyse und Auswertung von audiovi- suelle Daten noch weniger verbreitet. Besonders bei der Sprachanalyse von Audio- und Videoauf- zeichnungen gibt es aber in jüngster Zeit bemer- kenswerte Fortschritte. So lassen sich inzwischen umfangreiche Sprachkorpora automatisch analy- sieren. Die Sprachaufnahmen können mittels sta- tistischer Verfahren in kleinere Segmente unter- teilt werden, Sprecher erkannt und Sprache in Text umgewandelt werden. Diese Techniken wer- den unter dem Begriff Audio Mining zusammen- gefasst und ermöglichen den exakten Zugriff auf einzelnen Begriffe, Abschnitte und Ereignisse in Audiodaten.

Technologien und Anwendungen des Audio Mi- nings sind daher für verschiedenste Bereiche der Geistes- und Kulturwissenschaften von großem Interesse. So lassen sich zum Beispiel Sprachauf- nahmen automatisch vorsegmentieren, so dass diese anschließend mit gängigen Tools (z.B. ELAN und EXMARaLDA) weiter verarbeitet werden können. Diese Anwendung von Audio Mining ist besonders für die Forschung in Linguistik und Gesprächsanalyse sowie anderen Bereichen, die sich mit Interaktion und Sprache beschäf- tigen, interessant. Für Oral History, Ethnologie und andere vor allem an inhaltlichen Aspekten der Sprachdaten interessierte Fachgebiete lassen sich die hier typischerweise sehr langen Inter- views automatisch segmentieren und transkri- bieren. Biographische, narrative Interviews sind das Produkt eines kommunikativen Geschehens und damit hoch komplexe Quellen mit vielfäl- tigen Ansatzpunkten für die Interpretation. Aus forschungspraktischen Gründen wird die Analyse von Interviewdaten bisher meist auf das schrift- sprachliche Medium reduziert. Das Audio Mining eröffnet hier ganz neue Dimensionen und Frage- stellungen. Während die Fallzahlen bei konven- tionellen Analysemethoden meist bei um die 30 Interviews liegen, können mit technischer Unter- stützung viel größere Fallzahlen bearbeitet und somit unter vielfältigen vergleichenden Frage- stellungen auch quantitativ ausgewertet werden.

Gleichzeitig bieten die Werkzeuge auch der qua- litativen Analyse neue Dimensionen, indem so- wohl sprachliche wie nicht-sprachliche Aspekte der Kommunikation differenziert erfasst und so- mit für Forschungsfragen zugänglich gemacht werden können. Um diese Potentiale realisieren zu können, besteht allerdings Forschungsbedarf.

Für die Sprachtechnologien stellen die Audioda- ten vieler Fachrichtungen der Digital Humanities interessante Herausforderungen dar. Denn wäh- rend die Spracherkennung bei Sprachaufnahmen aus dem Nachrichtenbereich (optimale Aufnah- mebedingungen und Aufnahmetechnik, artiku- lierte Hochsprache professioneller Sprecher) in- zwischen gute Ergebnisse liefert, stellen zum Beispiel Zeitzeugeninterviews noch eine erhebli- che Herausforderung dar. Ursachen sind die oft schlechte Qualität der Audiodaten bedingt durch Modalitäten der Aufzeichnung (Rauschen, Über- steuerung, geringe Lautstärke durch schlechte Platzierung des Mikrophons), Alterungsprozesse der Magnetbänder bis zur Digitalisierung und Fehlentscheidungen bei der Wahl des Audiofor- mats sowie die Charakteristiken der Spontanspra- che (undeutliche Aussprache, schnelles Sprechen und Dialektfärbung). Bei den Aufnahmen aus Lin- guistik und Interaktionsforschung handelt es sich oft um Daten aus wenig erforschten Sprachen, zu denen es kaum Ressourcen und wenig andere linguistische Information gibt. Aber selbst Daten aus gut erforschten Sprachen wie dem Deutschen können für die Analyseverfahren anspruchsvoll sein. Datensets bestehen in beiden Fällen häufig aus natürlicher, spontaner Sprache mit mehre- ren Gesprächsteilnehmern und entsprechenden Sprechüberlappungen. Werkzeuge und Verfah- ren, die an Daten aus geplanter Sprache trainiert wurden, stoßen bei diesen Aufnahmen schnell an ihre Grenzen. Da diese Daten nicht unter Studio- bedingungen erhoben werden können, ist dar- über hinaus die Aufnahmequalität zumeist deut- lich geringer als bei Aufnahmen aus Hörfunk und Fernsehen. Die im Vergleich zu Daten auf dem Rundfunk recht kleinen Datensets erschweren da- bei die Anwendung von intelligenten Analyse- und Auswertungsverfahren noch weiter. So beste- hen eine Vielzahl von Forschungsthemen im Be- reich der Sprachanalyse, wie beispielsweise die Detektion von überlappenden Sprachsegmenten, eine robuste Sprechersegmentierung von kurzen Dialogsequenzen, Diarisierung von Aufnahmen für die Analyse von Turn-Takings, die Erken- nung von Sprechern, Erkennung von Dialekten, robuste Transkription von Sprachdaten hinsicht- lich Hintergrundgeräusche und Raumhall, Code- Switching in gesprochener Sprache, Erkennung von Pausen und gegebenenfalls Satzzeichen.

Weitere Informationen zu den Ausrichtern des Workshops

Der Workshop wird von dem an der Universi- tät zu Köln angesiedelten BMBF-Zentrum »Kölner

Zentrum Analyse und Archivierung von AV-Da- ten« (KA³) ausgerichtet. Ziele des über drei Jahre geförderten Projektes sind die Erforschung und Entwicklung von Werkzeugen und Services zur akustischen Analyse von AV-Daten, die Einrich- tung einer Nutzerplattform für die Analyse und Archivierung von AV-Daten sowie die Erprobung und Anwendung der Methoden in ausgewählten Pilotprojekten im Bereich der Oral History/Bio- grafieforschung und der Linguistik/Interkultu- relle Kommunikation. Besondere Aufmerksam- keit gilt den miteinander zusammenhängenden Problemen der interaktionsbezogenen Struktu- rierung und der effizienten Bereitstellung und Archivierung von audiovisuellen Daten. Im Rah- men des Verbundprojektes wird ein fach- und standortübergreifendes Zentrum für die Analyse und Archivierung audiovisueller Daten mit den drei Komponenten Analyse, Archivierung/Publi- kation und Schulung/Beratung aufgebaut, das die im Projekt entwickelten Werkzeuge und Services interessierten Forscherinnen und Forschern zur Verfügung stellt. Das geplante Zentrum ist insti- tutionell eingegliedert in das umfassender an- gelegte Kölner Data Center for the Humanities (DCH), das informationstechnologische Unterstüt- zung für alle Datentypen in den Geisteswissen- schaften anbietet und erforscht. Das Projekt KA³ ist eine Kooperation des Instituts für Linguistik (N. P. Himmelmann), dem Regionalen Rechenzen- trum (U. Lang) und dem Data Center for the Hu- manities (A. Witt und B. Mathiak) der Universität zu Köln, dem Fraunhofer‐ Institut für Intelligente Analyse‐ und Informationssysteme, Sankt Augus- tin (J. Köhler), dem Institut für Geschichte und Bio- graphie der FernUniversität Hagen (A. Leh) und dem Max-Planck-Institut für Psycholinguistik (P.

Trilsbeek).

Nikolaus P. Himmelmann lehrt Allgemeine Sprachwissenschaft an der Universität zu Köln.

Zentrales Forschungsgebiet ist sprachliche Diver- sität und was diese uns über menschliche Ko- gnition und Gesellschaftlichkeit lehrt. Er hat ent- scheidend zur Entwicklung des Konzepts digitaler Sprachdokumentationen und Spracharchive bei- getragen.

Joachim Köhler leitet den Bereich Spracher- kennung am Fraunhofer Institut IAIS. Zentrale Arbeitsgebiete sind maschinelles Lernen, Mus- tererkennung, Deep Learning, Information Re- trieval, Medieninformationssysteme, Metadaten sowie Linked Data.

Almuth Leh leitet das Archiv ‚Deutsches Ge- dächtnis‘ an der FernUniversität Hagen und forscht zu deutscher Mentalitätsgeschichte im 20.

Jahrhundert mit Einzelarbeiten zum Naturschutz in Nordrhein-Westfalen, Gewerkschafterinnen, Soldaten im Zweiten Weltkrieg, Wehrmachtsjus-

tiz, Universitätsgeschichte. Weitere Interessens- gebiete sind forschungsethische und methodische Fragen der Oral History und die Archivierung le- bensgeschichtlicher Interviews.

Felix Rau ist Projektmitarbeiter im Projekt »Köl- ner Zentrum für Analyse und Archivierung au- diovisueller Daten« (KA³) und koordiniert die Faschspezifische Arbeitsgruppe »Linguistische Feldforschung, Ethnologie, Sprachtypologie« (Lei- tung: Himmelmann) in CLARIN-D. Er ist Feldlin- guist mit einem Schwerpunkt auf den Munda- Zweig der austroasiatischen Sprachen und ist ein Archivmanager am Language Archive Cologne.

Automatic Text Recognition:

Mit Transkribus Texterkennung trainieren und anwenden

Hodel, Tobias

tobias.hodel@hist.uzh.ch

Staatsarchiv des Kantons Zürich, Schweiz

Strauß, Tobias

tobias.strauss@uni-rostock.de Universität Rostock CITLab

Diem, Markus

diem@caa.tuwien.ac.at

Vienna University of Technology, Computer Vision Lab

Die Aufbereitung und Erkennung von hand- schriftlichen Dokumenten oder von speziellen Druckschriften ist sowohl für Menschen als auch für Computeralgorithmen eine (technische) Her- ausforderung. Die Bearbeitung von schriftlichem, insbesondere handschriftlichem Material aber auch früher Drucke wird bislang von spezia- lisierten Experten durchgeführt, um technisch und qualitativ hochstehende Resultate aus histo- rischen Dokumenten zu erhalten. Zur Erstellung hochwertiger Editionen sind hilfswissenschaftli- che Kenntnisse (Paläographie, Editorik), histori- sches Kontextwissen und technisches Know-how gefragt.

Im Rahmen des Projekts READ (Recognition and Enrichment of Archival Documents) wer- den unterschiedliche Aufgaben der Automatisie- rung (weiter-)entwickelt, um qualitativ gute Er- gebnisse mit optimalem Ressourceneinsatz zu erhalten. Ein speziell dafür entwickeltes Tool ist die Software Transkribus und die Transkribus Weboberfläche (öffentliche Vorstellung im No- vember 2017). Beide Ansätze verkoppeln auf un- terschiedliche Weise die Arbeit von Expertinnen und maschinelle Erkennleistung. Software und Webservice sind frei verfügbar unter www.tran- skribus.eu. Im Workshop wird Transkribus vorge- stellt und kann durch die Teilnehmenden mit ei- genen oder zur Verfügung gestellten Dokumenten getestet werden.

Transkribus unterstützt alle Prozesse vom Im- port der Bilder über die Identifikation der Text- blöcke und Zeilen, die zu einer detaillierten Ver- linkung zwischen Text und Bild führt, sowie die Transkription und Annotation der Handschrift bis zum Export der gewonnen Daten in standardi- sierten Formaten.

Workflow in Transkribus

Um Texte zu transkribieren oder zu edie- ren, müssen digitale Bilder hochgeladen und danach mit Layouterkennungswerkzeugen bear- beitet werden. Die Analyse des Layouts kann automatisiert geschehen, wobei die manuelle Kontrolle und falls nötig die Nachbearbeitung im Moment noch sinnvoll ist.

Dokumente können entweder automatisch mit bereits bestehenden ATR-Modellen (Automatic Text Recognition) erkannt werden oder die Tran- skription erfolgt händisch und kann danach zum Training neuer Modelle genutzt werden. Insbe- sondere für die Bearbeitung großer Dokumenten- korpora, die in ähnlichen Handschriften verfasst wurden, lassen sich bereits heute Effizienzge- winne und Vereinfachungen erzielen.

Aufbauend auf den Transkriptionen ist es mög- lich eine Vielzahl von Auszeichnungen und Anno- tationen innerhalb des Textes, aber auch darüber hinaus für Einzeldokumente und ganze Doku- mentenbestände anzulegen. Neben der Anreiche- rung der Dokumente mit Metadaten (Identifika- tion von Personen, Orten und Sachwörtern) ist somit auch die Möglichkeit der Herstellung von Bestandsbeschreibungen und der Hinterlegung von Transkriptions- und Editionsvorschriften ge- geben.

Ausgabeformate

Für den Export stehen unterschiedliche For- mate und Ausgabeformen zur Verfügung. So ist es möglich XML-Dateien zu exportieren, die den Vorgaben der TEI entsprechen. Ausgehend davon können komplexe digitale Editionen erstellt wer- den, die jedoch im Unterschied zu den meisten herkömmlichen Editionen eine enge Verzahnung mit den verwendeten Bilddateien aufweisen. Da- durch werden Editionen ermöglicht, die den tran- skribierten Text in der Zusammenschau mit der faksimilierten Vorlage sichtbar machen. Daneben sind auch Ausgaben als Druckdaten (PDF) oder zur Weiterbearbeitung für Textverarbeitungspro- gramme (DOCX) implementiert. Schließlich ist auch ein Export im PAGE-Format (zur Anzeige in Viewern für OCR gelesene Dokumente, Pletscha- cher, 2010) sowie als METS (Metadata Encoding and Transmission) möglich.

Zielpublikum

Die Plattform ist für unterschiedliche Gruppen konzipiert. Einerseits für Geisteswissenschaft- lerINNEN, die selbst Transkriptionen und Editio- nen historischer Dokumente erstellen möchten.

Andererseits richtet sich die Plattform an Archive, Bibliotheken und andere Erinnerungsinstitutio- nen, die handschriftliche Dokumente in ihren Sammlungen aufbewahren und ein Interesse an der Aufbereitung des Materials haben. Angespro- chen werden sollen auch Studierende der Geis- tes-, Archiv- und Bibliothekswissenschaften mit einem Interesse an der Transkription historischer Handschriften.

Das Ziel, eine robuste und technisch hochste- hende Automatisierung von Layout- und Hand- schriftenerkennung, lässt sich nur durch die enge Zusammenarbeit zwischen Geisteswissenschaft- lerINNEn und ComputerspezialistINNen mit un- terschiedlichen Voraussetzungen und Ansprü- chen an Datenqualität und Herstellung von Transkriptionen erreichen. Die Algorithmen wer- den somit nicht nur bis zu einem Status als proof- of-concept erarbeitet, sondern bis zur Praxistaug- lichkeit verfeinert und in grösseren Forschungs- und Aufbewahrungsumgebungen getestet und verbessert. Die ComputerwissenschaftlerINNEN sind entsprechend ebenfalls ein wichtiges Zielpu- blikum, wobei bei ihnen weniger die Nutzung der Plattform als das Beisteuern von Software(teilen) anvisiert wird.

Die Speicherung der Dokumente erfolgt in der Cloud, gehostet auf Servern der Universität Inns- bruck. Die importierten Daten bleiben auch wäh- rend der Bearbeitung unverändert im Dateisys- tem liegen und werden ergänzt durch METS und PAGE XML. Alle bearbeiteten Dokumente und Da-

ten bleiben somit in den unterschiedlichen Bear- beitungsstadien nicht nur lokal verfügbar, son- dern können für andere Transkribusnutzerinnen und -nutzer freigegeben werden. Dank elaborier- tem user-management ist die Zuteilung von Rol- len möglich.

Die eingespeisten Dokumente und Daten blei- ben privat und vor dem Zugriff Dritter geschützt.

Von Projektseite können vorgenommene Arbeits- schritte zwecks besserem Verständnis der ausge- führten Arbeiten und letztlich der Verbesserung der Produkte ausgewertet werden.

Die Erkennprozesse werden serverseitig durch- geführt, sodass die Ressourcen auf den lokalen Rechnern nicht strapaziert werden. Transkribus ist mit JAVA und SWT programmiert und kann da- her plattformunabhängig (Windows, Mac, Linux) genutzt werden.

Ein- und Ausblicke im Workshop

Der Workshop richtet sich sowohl an Geisteswis- senschaftlerINNEN als auch an Computerwissen- schaftlerINNEN, wobei vorwiegend die Tools und Möglichkeiten von Transkribus präsentiert wer- den.Zwei zentrale Forschungsaspekte aus READ werden im Rahmen des Workshops durch Exper- ten vorgestellt:

Einerseits das technische Verfahren des Auto- matic Text Recognition mit rekurrenten neurona- len Netzen (Leifert et al. 2016). Dabei wird kurz in die Trainings- und Auswertungsmechanismen mit neuronalen Netzen eingeführt und Möglich- keiten der Auswertung demonstriert.

Andererseits wird die Erkennung von komple- xen Layouts, insbesondere Tabellen, erklärt und neueste technische Lösungen vorgestellt.

Programm/Ablauf des Workshops

• Begrüßung und Informationen zum Projekt RE- AD (Tobias Hodel, Zürich): 20‘

Überblick über Ziele und Fortschritte im Rah- men des von der EU geförderten Projekts.

• Machine Learning und automatisierte Text Er- kennung (Tobias Strauß, Rostock): 30‘

Einführung und Erklärung zum Einsatz neuro- naler Netze bei der Texterkennung

• Einführung in Transkribus 30‘

Aufbau und Funktionieren des Programms, Demonstration des Gebrauchs anhand von Beispielen. Aufzeigen der Möglichkeiten zum Einsatz der Automatisierungen.

• Selbstständiges Arbeiten der Teilnehmenden mit Transkribus: 90‘

• Die Möglichkeiten und Grenzen von Transkri- bus sollen von den Teilnehmenden (falls ge- wünscht mit eigenen Dokumenten) selbst aus- getestet werden.

• Layout Analyse: Tabellen und andere schwie- rige Formen (Markus Diem, Wien): 30‘

Ein über Transkribus hinausgehender Teil des Projekts beschäftigt sich mit computer vision.

Ziel ist es, auch komplexe Strukturen korrekt als Layout zu erkennen, um die automatisierte Texterkennung überhaupt zu ermöglichen. Ta- bellen gehören in dem Bereich zu den schwie- rigsten Formen der Texterkennung.

• Diskussion über Vor- und Nachteile der Soft- ware: 30‘

Inklusive Evaluation des Tools und der Ver- anstaltung. Feedbacks werden eingeholt, zur Verbesserung der Software und Webtools (usability, Umfang und Leistung der Automati- sierungen etc.).

• Nach Interesse der Teilnehmenden werden während des Workshops Kurzinputs zu fol- genden Themen angeboten:

1. Matching von Text und Bild (bspw. aus be- stehenden Transkriptionen),

2. Transkribus Learn (e-Learningumgebung), 3. Crowdsourcing-Infrastruktur,

4. ScanTent und DocScan (Fotografieren eige- ner Dokumente mit Android App).

Workflow in Transkribus

Um Texte zu transkribieren oder zu edie- ren, müssen digitale Bilder hochgeladen und danach mit Layouterkennungswerkzeugen bear- beitet werden. Die Analyse des Layouts kann automatisiert geschehen, wobei die manuelle Kontrolle und falls nötig die Nachbearbeitung im Moment noch sinnvoll ist.

Dokumente können entweder automatisch mit bereits bestehenden ATR-Modellen (Automatic Text Recognition) erkannt werden oder die Tran- skription erfolgt händisch und kann danach zum Training neuer Modelle genutzt werden. Insbe- sondere für die Bearbeitung großer Dokumenten- korpora, die in ähnlichen Handschriften verfasst wurden, lassen sich bereits heute Effizienzge- winne und Vereinfachungen erzielen.

Aufbauend auf den Transkriptionen ist es mög- lich eine Vielzahl von Auszeichnungen und Anno- tationen innerhalb des Textes, aber auch darüber hinaus für Einzeldokumente und ganze Doku- mentenbestände anzulegen. Neben der Anreiche- rung der Dokumente mit Metadaten (Identifika- tion von Personen, Orten und Sachwörtern) ist somit auch die Möglichkeit der Herstellung von Bestandsbeschreibungen und der Hinterlegung von Transkriptions- und Editionsvorschriften ge- geben.