Software Engineering 2011 Workshopband

Volltext

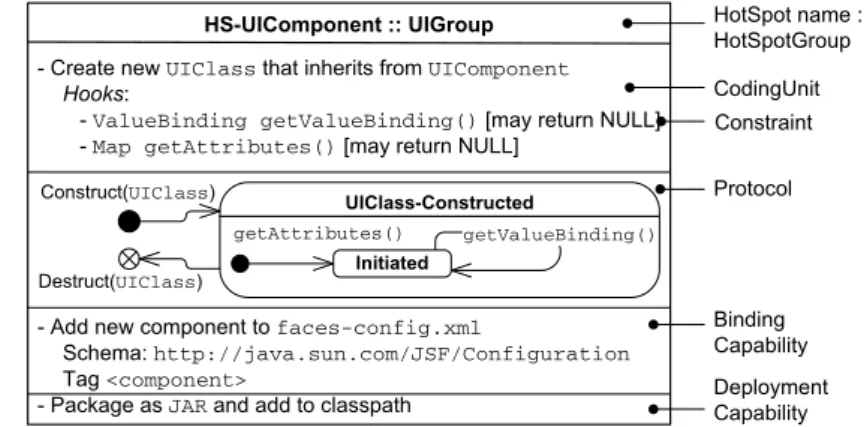

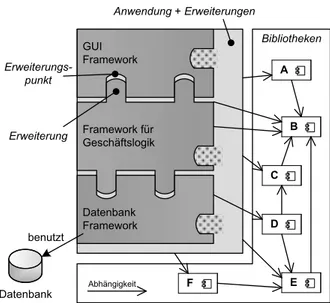

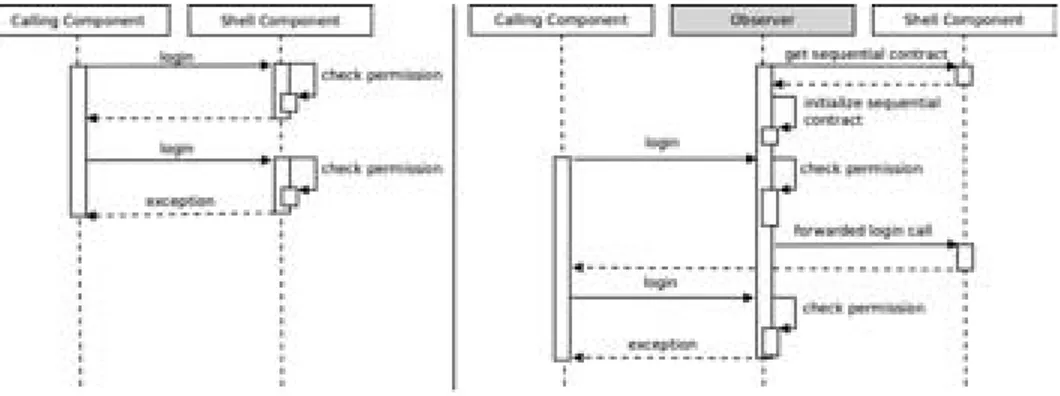

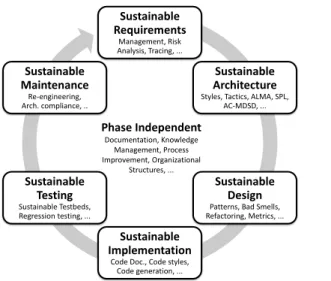

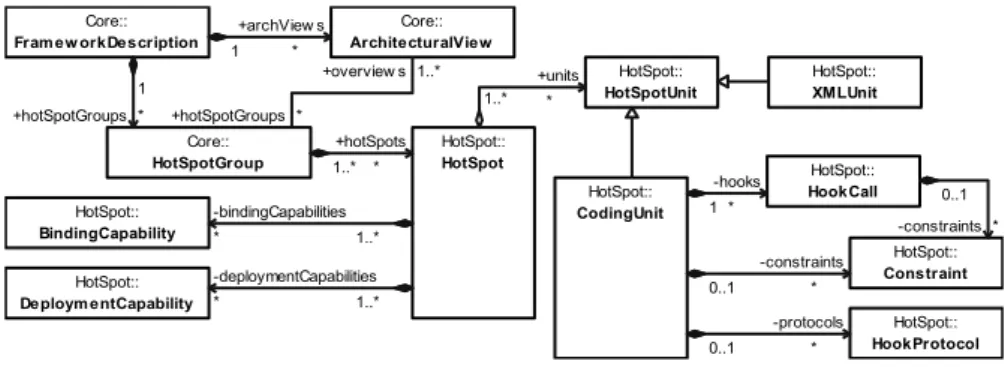

Abbildung

ÄHNLICHE DOKUMENTE

printer and computer or smart device closer to the wireless router to help with radio wave communication, and then try to make network settings again. The printer is not connected

printer and computer or smart device closer to the wireless router to help with radio wave communication, and then try to make network settings again. The printer is not connected

If you register the paper size and type on the screen displayed when you insert the paper cassette, the printer informs you when the registered information and print settings

If you register the paper size and type on the screen displayed when you insert the paper cassette, the printer informs you when the registered information and print settings

To write to the memory device, enter Settings > General Settings > Printer Settings > Memory Device Interface > File Sharing on the control panel and then select

printer and computer or smart device closer to the wireless router to help with radio wave communication, and then try to make network settings again.. The printer is not connected

If you register the paper size and type on the screen displayed when you insert the paper cassette, the printer informs you when the registered information and print settings

[r]